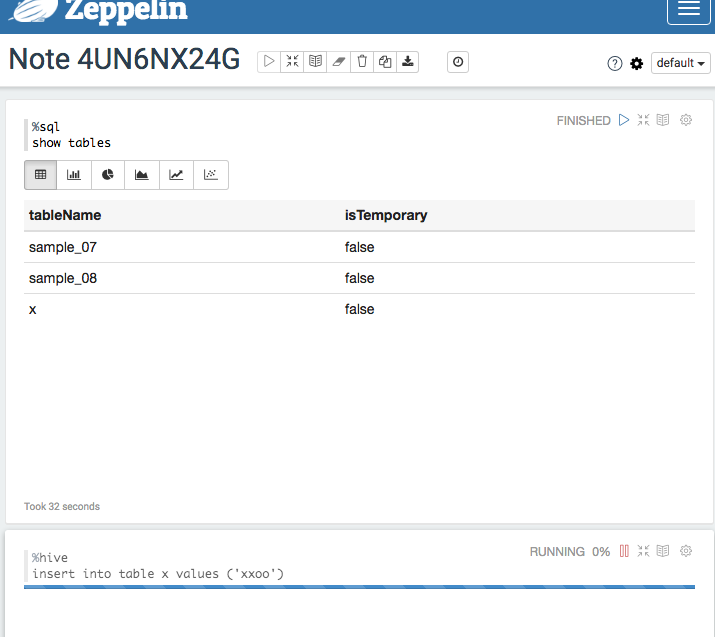

在自带的zeppelin界面上,操作hive sql往表里面插入一条数据,一直卡着不动。是不是有bug啊?

补充一下图:

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

哪里的?截图看看。

你的集群配置是什么,是不是配置比较低?在zeppelin里面运行spark之后,zeppelin会启一个常驻的spark job来接受zepplein notebook上的其他spark作业提交,你上集群的hadoop ui看一下是不是一直有个spark job在运行。这个spark job一直运行导致其他的mapreduce作业拿不到资源,状态一直是accepted。

你可以点击“interpreter”, 在“ spark”这一段,点击右上角的“restart”,这样可以将处理spark submit的常驻作业停掉,然后你其他的mapreduce作业就能获得资源,里面可以运行了。你试一下。