dataworks数据同步报错?RequestID:[ddb2330a808d4776d5e062e7cdae47a3],Message:[The realtime task failed to run. Please check the log details.Error Message:RequestID:[3386d18e433d40e182ed29293cb2f643],Message:[{"errorMessage":"OutOfMemoryError: Java heap space","stackTrace":"java.util.concurrent.ExecutionException: org.apache.flink.client.deployment.application.UnsuccessfulExecutionException: Application Status: FAILED\n\tat java.base/java.util.concurrent.CompletableFuture.reportGet(CompletableFuture.java

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

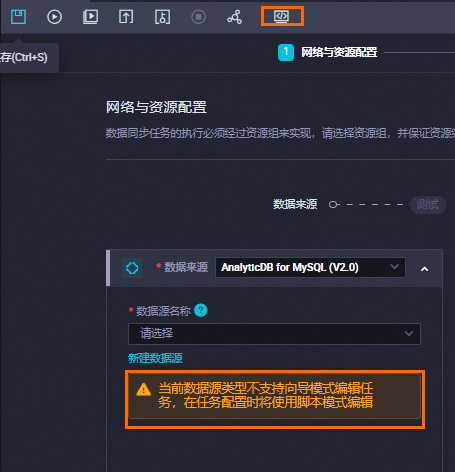

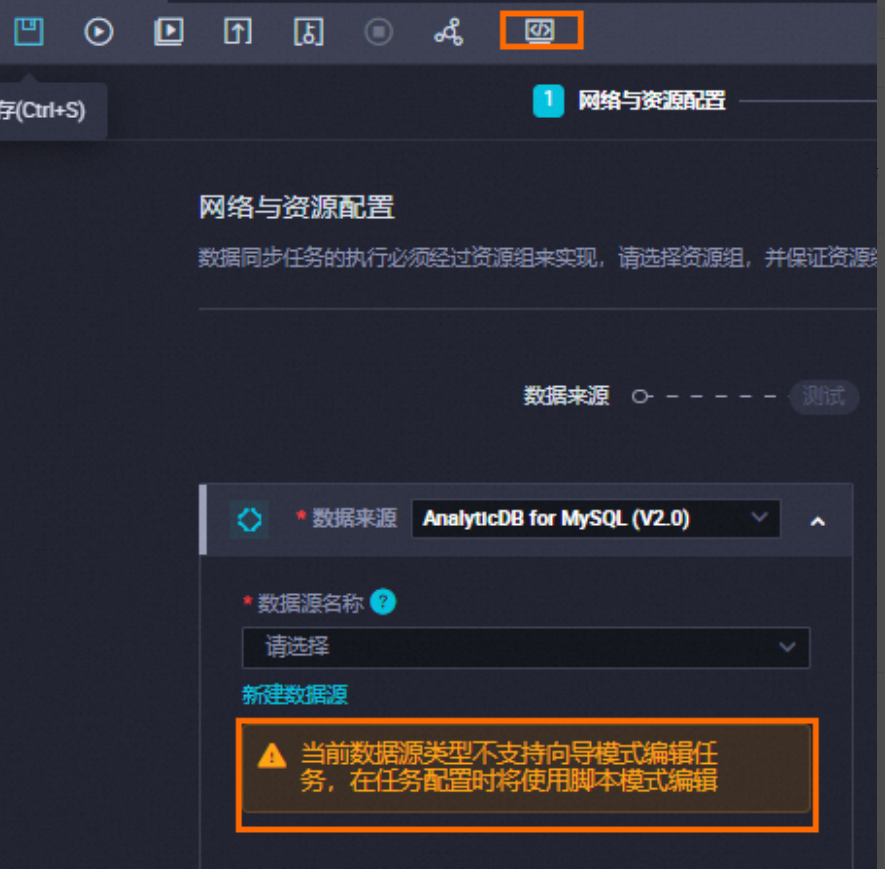

数据源或目标源不可用:

如果数据源或目标源不可用,就会导致数据同步报错。在DataWorks中,您需要确保数据源和目标源都是可用的,才能进行数据同步。

数据源或目标源不存在:

如果数据源或目标源不存在,就会导致数据同步报错。在DataWorks中,您需要确保数据源和目标源都是存在的,才能进行数据同步。

针对您在DataWorks中遇到的数据同步任务报错问题,错误信息为OutOfMemoryError: Java heap space,这表明在执行任务时Java虚拟机(JVM)分配的堆内存空间不足。根据提供的参考资料,您可以采取以下措施解决此问题:

调整JVM参数:

如果您使用的是独享数据集成资源组,可以通过修改JVM参数来扩大堆内存空间。例如,可以在任务配置的setting.jvmOption中设置 -Xms(初始堆大小)和 -Xmx(最大堆大小),如:"jvmOption": "-Xms1024m -Xmx1024m",这将JVM的初始和最大堆内存都设置为1GB

减小批处理量和文件大小:

检查同步任务的配置,如果插件支持batchsize或maxfilesize参数,尝试减小这些值以降低单次处理的数据量,从而减少内存消耗<

降低并发数:

调整任务的并发执行数。如果您使用向导模式配置任务,需在通道控制中减小任务期望最大并发数;若采用脚本模式,则调整concurrent参数以减小并发度<

请逐步尝试上述解决方案,并监控任务执行情况,以确定最适合您场景的调整策略。务必注意,调整JVM参数或其他配置前,应评估数据任务的实际规模,避免过度分配资源。如果问题依旧,建议进一步检查数据源和任务逻辑,确认是否有其他潜在因素导致内存使用激增。

Java堆空间不足(OutOfMemoryError: Java heap space):

调整JVM参数: 如果使用的是独享数据集成资源组,可以通过修改JVM参数来扩大堆内存。例如,可以在任务配置的JVM选项中设置 -Xms1024m -Xmx1024m 来调整初始和最大堆内存大小

若错误信息提示并发槽位超过限制,如[TASK_MAX_SLOT_EXCEED],应减小任务的并发设置,确保不超过最大允许的并发数。

在处理DataWorks数据同步报错的问题时,可以按照以下步骤进行排查和解决:

检查网络连接:

确保设备与DataWorks服务的网络是连通的。如果设备处于离线状态,或者网络连接有问题,可能导致无法访问DataWorks。

对于在不同地域或不同账号下的数据库与DataWorks之间的数据同步,需要确保它们之间的网络是连通的。

优化同步任务配置:

检查并确保使用了正确的数据库连接参数,如地址、用户名、密码等。

考虑增加任务并发数以提高数据同步效率。

如果数据量大,可以考虑分片同步或将数据分成多个部分分别进行同步。

数据库性能优化:

对于数据量大的表,在数据库层面进行优化,如添加索引、优化查询语句等,以减少数据同步过程中的资源消耗。

使用专用同步服务器:

如果条件允许,使用专用的同步服务器进行数据同步,避免在业务服务器上执行大量同步操作。

脏数据的排查和定位:

了解如何查看和处理脏数据,特别是在同步过程中由于数据约束导致的数据插入失败等问题。

检查是否存在编码格式设置错误或乱码问题导致的脏数据报错。

资源组管理:

确保已购买并正确配置了独享资源组,以便在数据源测试连通性或任务执行时能够找到并使用该资源组。

如果任务资源不足,需要调整资源配置以启动任务。

同步任务的详细配置检查:

根据具体的同步类型(如整库离线同步、一键实时同步等),检查相关的配置项,包括同步来源与规则、目标表的相关属性、写入规则等。

高级配置的调整:

设置同步来源与规则,包括源表名和目标表名的转换规则。

定义写入目标表的相关属性,如写入模式、是否写入分区表以及分区字段名称等。

设置任务运行资源,包括任务名称及任务执行所使用的资源组。

此外,在处理DataWorks数据同步报错时,还应注意以下几点:

如果同步任务涉及到时间类型的字段,需要注意同步任务不支持跨时区同步数据的限制。

对于特定插件的报错,如MongoDB、OSS、DataHub等,需要查阅相关文档来获取详细的解决方案。

实时同步任务的配置和性能优化也是重要的考量因素,例如选择正确的数据源、处理TRUNCATE操作、提高同步速度等。

总的来说,DataWorks数据同步报错的处理需要综合考虑网络连接、任务配置、数据库性能、资源组管理等多个方面。通过细致的配置检查和优化,可以有效地解决同步过程中出现的问题。

当DataWorks数据同步出现报错时,可以通过以下步骤进行排查和解决:

一、检查数据源和目标配置

数据源配置:

确认数据源(如数据库、文件系统等)的连接信息(地址、端口、用户名、密码等)是否正确。

检查数据源是否可用,没有宕机或维护中的情况。

验证数据源中是否有足够的权限供DataWorks访问。

目标配置:

确认数据同步的目标位置(如另一个数据库、数据仓库等)的配置信息是否正确。

检查目标系统是否已准备好接收数据,如存储空间是否足够,是否有相应的表结构等。

二、检查数据同步任务配置

字段映射:

检查数据源和目标系统中的字段映射是否正确,确保没有遗漏或错误的映射。

验证数据类型是否兼容,避免数据格式不匹配导致的错误。

同步策略:

检查数据同步的策略设置,如同步周期、同步方式(全量同步、增量同步)等,确保它们符合实际需求。

三、检查网络和权限

网络连接:

确保DataWorks与数据源和目标系统之间的网络连接稳定可靠。

检查是否有防火墙、安全组等网络设备或策略阻止了必要的网络通信。

权限问题:

验证DataWorks账号是否具有足够的权限来执行数据同步任务。

如果涉及到跨账号或跨系统的数据同步,确保已正确配置跨账号或跨系统的访问权限。

四、查看日志和错误信息

DataWorks日志:

仔细查看DataWorks的运行日志和错误日志,寻找可能导致数据同步失败的具体原因。

注意日志中的错误代码和错误描述,这些信息通常能提供解决问题的线索。

数据源和目标日志:

如果可能的话,也查看数据源和目标系统的日志,以了解数据同步过程中可能发生的任何异常或错误。

五、尝试解决问题

修改配置:

根据日志和错误信息中提供的线索,修改数据源、目标或数据同步任务的配置。

重启任务:

在修改配置后,尝试重启数据同步任务以查看问题是否得到解决。

联系支持:

如果问题依然存在且难以解决,建议联系阿里云的技术支持团队或查看DataWorks的官方文档和社区论坛以获取帮助。

六、预防措施

定期备份:

在进行数据同步之前和之后,定期备份数据源和目标系统的数据,以防止数据丢失或损坏。

监控和警报:

设置数据同步任务的监控和警报功能,以便在出现错误或异常情况时及时收到通知并采取相应的措施。

通过以上步骤,您可以系统地排查和解决DataWorks数据同步中出现的报错问题。

在DataWorks中,数据同步任务失败并报错的情况可能由多种原因引起。根据您提供的错误信息,看起来是出现了Java堆空间不足(OutOfMemoryError)的异常。这通常是由于Java应用程序的内存使用超出了可用内存限制导致的。

以下是一些可能的解决方案和建议:

增加JVM内存分配:可以尝试增加Java虚拟机(JVM)的内存分配,以避免内存不足的问题。这可以通过修改DataWorks的任务配置或通过命令行参数来实现。

优化内存使用:检查数据同步任务中的内存使用情况,确保没有不必要的内存占用。例如,可以检查任务中的数据处理逻辑,确保没有过多的内存消耗。

调整数据同步策略:如果数据同步任务涉及大量的数据处理,可以尝试调整数据同步策略,例如分批处理或增加缓存等,以减少内存使用和压力。

检查硬件资源:确保运行的服务器或虚拟机具有足够的内存和CPU资源,以满足数据同步任务的需求。如果资源不足,可以考虑增加硬件资源或优化资源分配。

总之,在处理数据同步任务失败和内存不足的问题时,最重要的是仔细检查任务配置和执行日志,确保所有步骤都是正确的,并且按照预期的顺序执行。。

您在DataWorks的数据同步任务中遇到的错误提示表明任务由于内存溢出(OutOfMemoryError: Java heap space)而失败。这通常是因为分配给任务的内存不足以处理任务所需的资源。以下是一些排查和解决此类问题的步骤:

ddb2330a808d4776d5e062e7cdae47a3 和 3386d18e433d40e182ed2929293cb2f643)可以用来追踪具体的任务执行日志。通过上述步骤,您应该能够更好地定位问题所在,并采取相应的措施来解决实时同步任务中的内存溢出问题。如果需要进一步的帮助,请随时提供更多信息。

OutOfMemoryError: Java heap space 表示 Java 堆空间不足,这通常是因为 DataWorks 同步任务在执行过程中消耗的内存超过了配置的堆大小限制

1.如果任务配置允许,尝试增加任务的内存分配,以便为 Java 堆空间提供更多资源。

2.检查任务配置中的 batchSize 或 bufferSize 参数,减小这些参数的值,可以减少单次处理的数据量,从而降低内存消耗

3.如果任务使用了多线程或并发执行,适当降低并发数,以减少同时运行的任务数和内存占用。

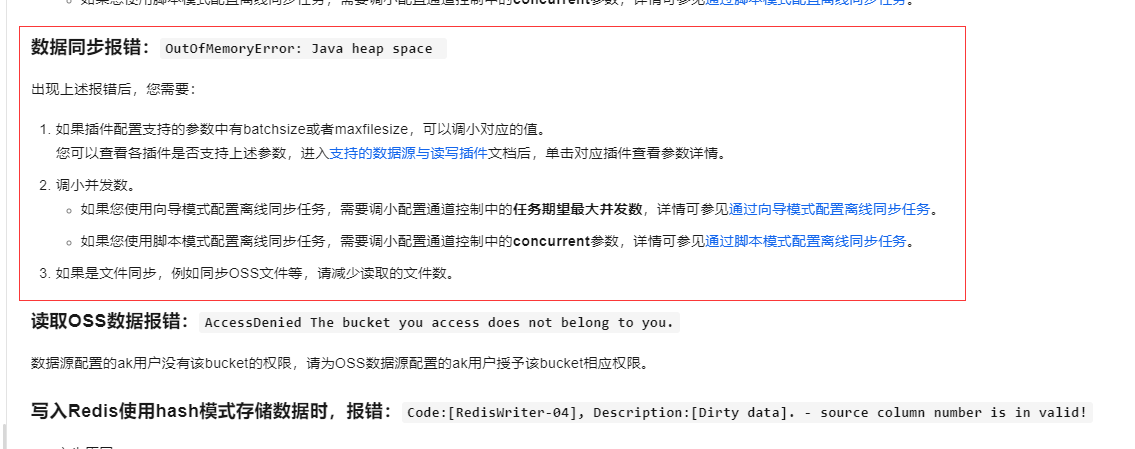

数据同步报错:OutOfMemoryError: Java heap space

出现上述报错后,您需要:

如果插件配置支持的参数中有batchsize或者maxfilesize,可以调小对应的值。

您可以查看各插件是否支持上述参数,进入支持的数据源与读写插件文档后,单击对应插件查看参数详情。

调小并发数。

如果您使用向导模式配置离线同步任务,需要调小配置通道控制中的任务期望最大并发数,详情可参见通过向导模式配置离线同步任务。

如果您使用脚本模式配置离线同步任务,需要调小配置通道控制中的concurrent参数,详情可参见通过脚本模式配置离线同步任务。

如果是文件同步,例如同步OSS文件等,请减少读取的文件数。

参考文档https://help.aliyun.com/zh/dataworks/support/batch-synchronization?spm=a2c4g.11186623.0.i59

DataWorks基于MaxCompute/Hologres/EMR/CDP等大数据引擎,为数据仓库/数据湖/湖仓一体等解决方案提供统一的全链路大数据开发治理平台。