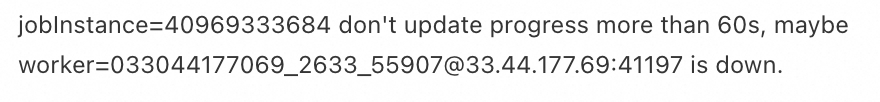

在表格存储中这个任务每次到96%就会报错失败,是什么原因?请参考图片:

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在表格存储中,任务每次运行到96%时失败,可能的原因可以从以下几个方面进行分析和排查:

表格存储是一个分布式NoSQL服务,在运行过程中会根据数据量和访问情况进行动态负载均衡。当某个数据分区的数据量过大或访问过热时,系统会自动将该分区分裂为多个分区,并调度到不同的服务节点上。在此过程中,涉及的数据分区可能会有短暂的不可用时间(通常为百毫秒级别,但在高负载情况下可能持续到秒级别)。

影响: 如果任务在96%时正好触发了某个分区的分裂或负载均衡操作,可能会导致读写操作失败,返回类似OTSPartitionUnavailable、OTSServerBusy或OTSTimeout等错误码。

解决方案: - 重试机制: 表格存储官方SDK默认提供重试策略,建议在初始化Client端时配置合理的重试策略,以应对短暂的分区不可用问题。 - 预分区优化: 如果任务涉及大量数据写入,可以在表创建时预先划分多个数据分区,避免运行时动态分裂带来的性能波动。

如果任务中使用了批量读写操作(如BatchWriteRow或BatchGetRow),这些操作可能涉及多张表或一张表的多个数据分区。由于批量操作仅保证单行操作的原子性,而不保证整个操作的原子性,因此在某些分区不可用或分裂时,部分操作可能失败。

影响: 即使批量操作返回的状态码为200,仍需检查response中的getFailedRows()方法,确认是否有失败的单行操作。

解决方案: - 检查失败行: 在接收到批量操作的响应后,调用getFailedRows()方法,定位失败的具体行并进行重试。 - 拆分批量操作: 如果任务涉及大量数据,可以将批量操作拆分为更小的批次,降低单次操作失败的概率。

如果任务涉及对二级索引表的读取操作,而二级索引的存量数据尚未同步完成,则会导致Disallow read index table in building base state错误。

影响: 在存量数据同步完成之前,无法正常读取二级索引表,可能导致任务失败。

解决方案: - 等待同步完成: 确保二级索引的存量数据构造和同步完成后再进行数据读取操作。 - 监控同步进度: 可通过控制台或SDK监控二级索引的同步状态。

如果任务是通过Kafka Connect将数据导入表格存储,可能由于解析消息记录或写入表格存储时发生错误,导致任务失败。

影响: 默认情况下,Sink Task会在发生错误时立即失败。如果错误未被正确处理,可能导致任务在接近完成时失败。

解决方案: - 配置错误容忍策略: 在Kafka Connect的配置文件中添加以下配置,跳过非致命错误:

errors.tolerance=all

runtime.error.tolerance=all

runtime.error.mode=tablestore

runtime.error.table.name=error

curl http://localhost:8083/connectors/{name}/status

curl http://localhost:8083/connectors/{name}/tasks/{taskid}/status

curl -X POST http://localhost:8083/connectors/{name}/restart

curl -X POST http://localhost:8083/connectors/{name}/tasks/{taskId}/restart

如果任务在写入数据时,主键类型与建表时设置的类型不一致,可能会导致OTSInvalidPK错误。

影响: 例如,建表时主键类型为binary,但写入时提供了string类型的值,会导致任务失败。

解决方案: - 检查主键类型: 确保写入数据的主键类型与建表时设置的类型一致。 - 修改写入逻辑: 如果主键类型确实需要调整,可重新建表或修改写入逻辑。

根据上述分析,任务在96%时失败的原因可能包括: 1. 数据分区负载均衡导致的短暂不可用; 2. 批量操作的非原子性; 3. 二级索引存量数据同步未完成; 4. Kafka数据导入过程中的错误处理不当; 5. 主键类型不匹配。

建议按照以下步骤排查和解决问题: 1. 检查任务是否涉及动态分区分裂,配置合理的重试策略或预分区优化; 2. 验证批量操作的失败行,并拆分大批次操作; 3. 确认二级索引的存量数据同步状态; 4. 配置Kafka Connect的错误处理策略,确保任务能够容忍非致命错误; 5. 核对主键类型,确保写入数据与建表时的定义一致。

如果问题仍未解决,请提供更多上下文信息(如具体的错误码、日志内容等),以便进一步分析。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。