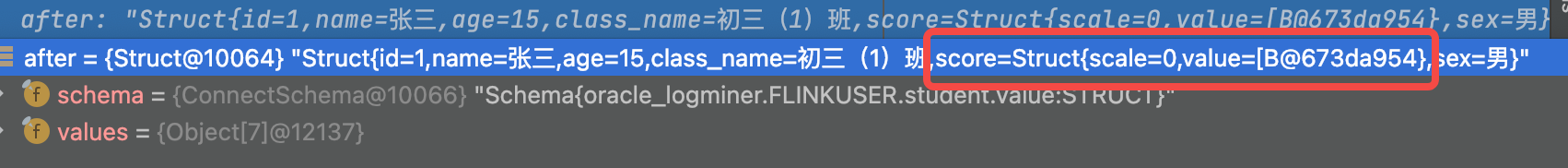

flinkcdc oracle 获取的值是这样的,请问该如何解析?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在使用 Flink CDC 获取 Oracle 数据时,返回的值可能包含完整的变更数据(如插入、更新或删除操作),这些数据通常以 JSON 格式呈现。解析这些值需要根据具体的字段映射和数据类型进行处理。以下是详细的解析步骤和注意事项:

Flink CDC 捕获的数据变更信息通常包括以下内容: - 操作类型:INSERT、UPDATE 或 DELETE。 - 表名:发生变更的表名称。 - 主键信息:用于标识记录的唯一性。 - 变更前后的数据: - before:表示更新或删除操作前的数据。 - after:表示插入或更新操作后的数据。

示例 JSON 数据格式如下:

{

"op": "u", // 操作类型:u 表示 UPDATE

"table": "SCHEMA.TABLE_NAME",

"before": {

"ID": 1,

"NAME": "OldName"

},

"after": {

"ID": 1,

"NAME": "NewName"

}

}

通过 op 字段判断当前数据的操作类型: - c:插入(Create)。 - u:更新(Update)。 - d:删除(Delete)。

通过 table 字段获取发生变更的表名称,例如 SCHEMA.TABLE_NAME。

before 字段:表示更新或删除操作前的数据。如果为 null,说明是插入操作。after 字段:表示插入或更新操作后的数据。如果为 null,说明是删除操作。根据 Oracle 和 Flink 的字段类型映射规则,将数据转换为适合下游处理的格式。例如: - Oracle 的 DATE 类型需要映射为 Flink 的 TIMESTAMP 类型。 - 数字类型(如 NUMERIC)需要确保精度和小数位一致。

如果运行日志报错 DataException: file is not a valid field name,请确保 Flink 中字段的大小写与 Oracle 表中的字段完全一致。

如果日志能读取到 Oracle LogMiner 数据但无法读取到实际数据,建议优化 SQL 查询逻辑或使用更高效的实时集成工具(如 Dataphin)。

如果 CDC 消费过程中连接数占用过高,请检查以下配置: - 降低作业并发数。 - 减少连接池大小。 - 优化 SQL 逻辑,尝试使用 CDAS(Change Data As Service)复用连接。

以下是一个简单的 Flink SQL 示例,用于解析 Oracle CDC 数据并写入下游系统:

CREATE TABLE oracle_cdc_source (

op STRING, -- 操作类型

table_name STRING, -- 表名

before ROW< -- 变更前数据

ID INT,

NAME STRING

>,

after ROW< -- 变更后数据

ID INT,

NAME STRING

>

) WITH (

'connector' = 'oracle-cdc',

'hostname' = 'your-oracle-host',

'port' = '1521',

'username' = 'your-username',

'password' = 'your-password',

'database-name' = 'your-database',

'schema-name' = 'your-schema',

'table-name' = 'your-table'

);

-- 解析数据并写入下游

INSERT INTO downstream_table

SELECT

op,

table_name,

before.ID AS before_id,

before.NAME AS before_name,

after.ID AS after_id,

after.NAME AS after_name

FROM oracle_cdc_source;

LOGMINER 权限,并正确配置 debezium.database.pdb.name 参数(如果使用 PDB 模式)。decoding.plugin.name 参数设置为 pgoutput,避免非 UTF-8 编码导致的乱码问题。通过以上步骤和注意事项,您可以成功解析 Flink CDC 获取的 Oracle 数据,并将其应用于下游系统。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。