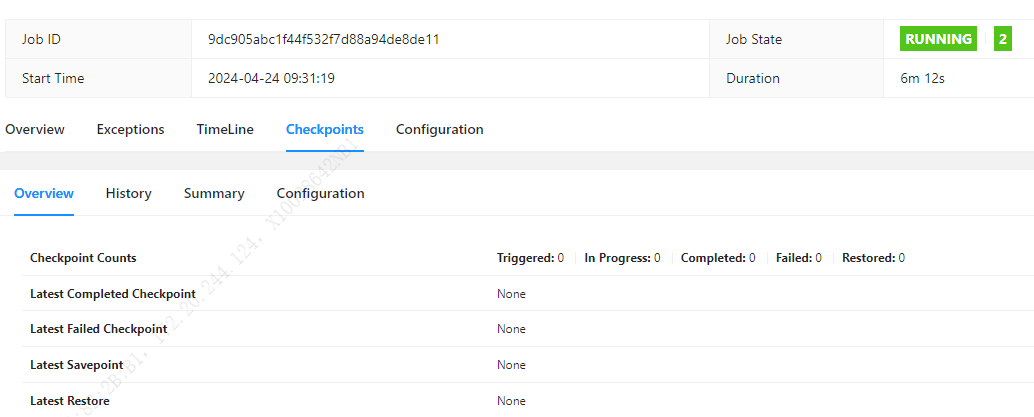

Flink CDC里这样的CheckPoint算正常吗?Overview中各指标要么是0,要么是None。

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在Flink CDC中,如果Checkpoint的Overview中各指标(如lastCheckpointDuration、lastCheckpointSize等)显示为0或None,这通常表明Checkpoint机制未正常工作或未正确配置。以下是可能的原因及解决方案:

env.enableCheckpointing(60000); // 每60秒触发一次Checkpoint

其他配置中正确设置了Checkpoint相关参数,例如execution.checkpointing.interval。execution.checkpointing.interval: 10min

execution.checkpointing.tolerable-failed-checkpoints: 100

restart-strategy: fixed-delay

restart-strategy.fixed-delay.attempts: 2147483647

You are using the new V4 state engine to restore old state data from a checkpoint报错。此时需要参考相关文档解决兼容性问题。Checkpoints页面检查Sync Duration和Alignment Duration是否较长。如果是,则说明瓶颈在同步阶段,需优先解决反压问题。部署详情页签,确保开启了日志归档功能,并设置合理的日志归档有效期(默认7天)。rs.initiate()命令初始化副本集。如果Flink CDC中的Checkpoint指标显示为0或None,建议按照以下步骤排查: 1. 确认Checkpoint已启用并正确配置。 2. 检查是否处于全量同步阶段,并根据需要开启增量快照功能。 3. 确保状态后端配置正确,并解决可能的兼容性问题。 4. 排查是否存在反压问题,并优化作业性能。 5. 检查日志归档和日志级别设置,确保能够捕获Checkpoint相关信息。 6. 确认是否属于特殊场景下的正常现象。

如果以上方法仍无法解决问题,请提供更详细的作业配置和日志信息,以便进一步分析。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。