在使用 Flink CDC Stream 模式编写代码时,您需要安装和配置以下软件和工具,以确保开发环境能够支持 Flink CDC 的功能:

1. 开发工具

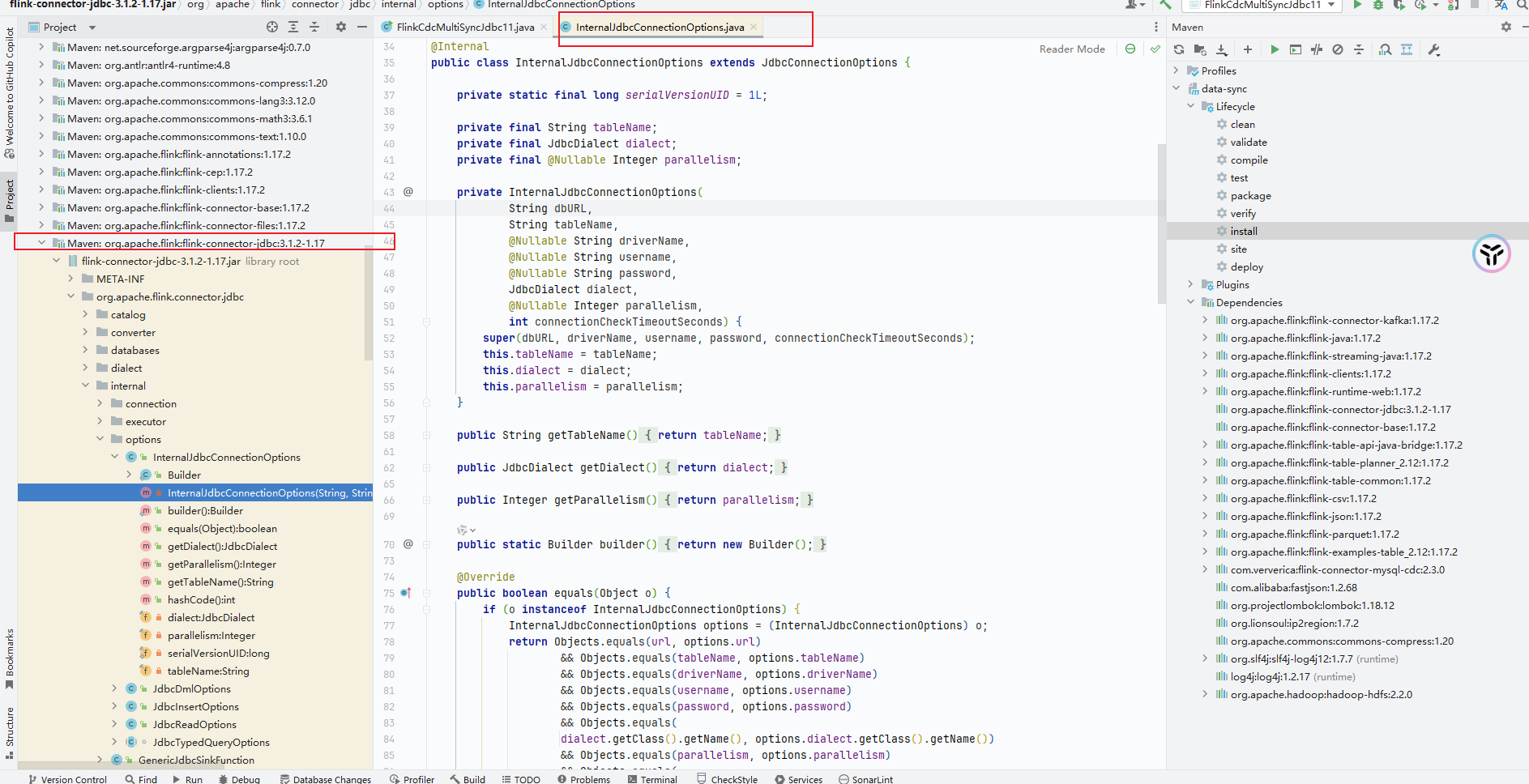

- IntelliJ IDEA 或其他支持 Java 开发的 IDE 工具。

- 这是用于编写、调试和运行 Flink 程序的主要开发环境。

2. 构建工具

- Maven 3.6.3 及以上版本。

- Maven 是用于管理项目依赖和打包的工具。Flink CDC 项目通常通过 Maven 构建,因此需要确保已正确安装并配置 Maven。

3. Java 开发环境

- JDK 8 或 JDK 11。

- Flink 作业开发仅支持这两个版本的 JDK,请根据需求选择合适的版本进行安装。

4. Flink 环境

- Apache Flink。

- 需要下载并安装与目标引擎版本兼容的 Flink 版本。例如,实时计算 Flink 版支持的 DataStream API 完全兼容开源 Flink 版本。

- 如果您使用的是阿里云实时计算 Flink 版,则无需手动安装 Flink,因为其服务端已经集成了 Flink 引擎。

5. Flink CDC 连接器

- Flink CDC Connector。

- 根据数据源类型(如 MySQL、Postgres、MongoDB 等),需要引入对应的 Flink CDC 连接器依赖。例如:

- 对于 MySQL 数据源,可以使用

flink-connector-mysql-cdc。

- 对于 Postgres 数据源,可以使用

flink-connector-postgres-cdc。

- 对于 MongoDB 数据源,可以使用

flink-connector-mongodb。

- 这些连接器可以通过 Maven 中央仓库获取,或者从源码编译生成 JAR 文件。

6. 数据源客户端

- 数据库客户端工具。

- 如果您的数据源是 MySQL、Postgres 或 MongoDB,建议安装对应的客户端工具以便管理和验证数据源的状态。例如:

- MySQL Workbench(适用于 MySQL)。

- pgAdmin(适用于 Postgres)。

- MongoDB Compass(适用于 MongoDB)。

7. 阿里云相关工具(可选)

- VS Code 插件。

- 如果您使用阿里云实时计算 Flink 版,可以安装 VS Code 的本地开发插件,用于快速创建和部署 Flink 作业。

- OSS 客户端工具。

- 如果需要将 JAR 包上传到阿里云对象存储服务(OSS),可以使用 OSS 客户端工具或控制台完成上传操作。

8. 网络和权限配置

- VPC 网络配置。

- 确保 Flink 作业所在的 VPC 能够访问数据源(如 MySQL、Postgres、MongoDB 等)。如果数据源位于不同的 VPC,需要配置跨 VPC 访问。

- 白名单设置。

- 如果数据源启用了白名单限制,需要将 Flink 作业的 IP 地址添加到白名单中。

9. 其他依赖

- Debezium Deserialization Schema。

- Flink CDC 使用 Debezium 解析变更日志,因此需要引入

JsonDebeziumDeserializationSchema 或其他自定义的反序列化器。

总结

在编写 Flink CDC Stream 模式的代码时,您需要安装和配置上述软件和工具。具体包括开发工具(如 IntelliJ IDEA)、构建工具(如 Maven)、Java 环境(JDK 8 或 11)、Flink 环境、Flink CDC 连接器以及相关的数据源客户端工具。此外,还需要确保网络和权限配置正确,以便 Flink 作业能够正常访问数据源。