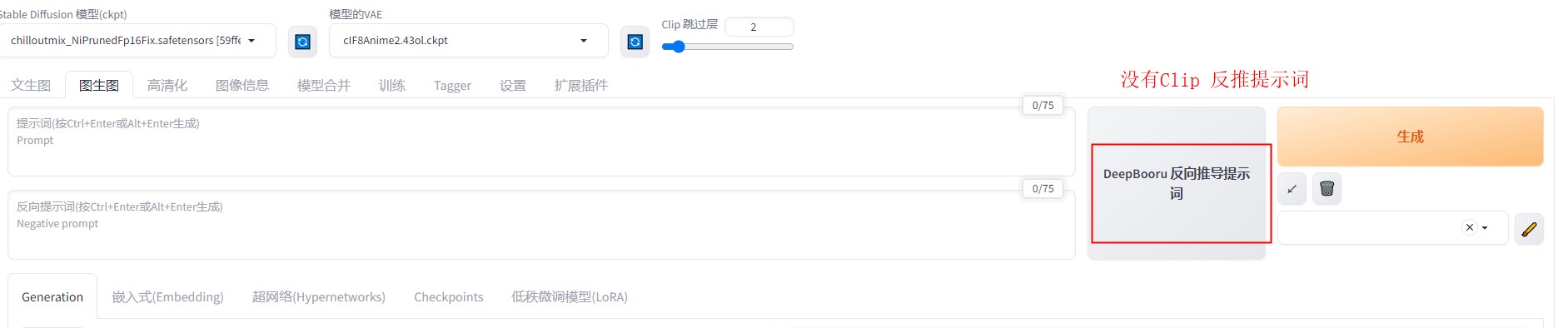

在函数计算FC使用官方的SD ,没有Clip 的反推,这个大家知道什么问题么?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在函数计算(FC)中使用官方的Stable Diffusion(SD)镜像时,如果遇到没有Clip反推功能的问题,可能与以下因素相关:

函数计算提供的官方基础镜像是基于特定版本的机器学习框架和依赖库构建的。这些镜像虽然预装了主流框架(如PyTorch、TensorFlow等)以及热门模型平台(如ModelScope),但可能并未包含所有扩展功能或插件。例如,Clip反推功能可能需要额外的依赖或自定义代码支持,而这些内容未被默认集成到官方镜像中。

解决方法: - 检查您使用的官方基础镜像是否包含Clip相关的依赖库。可以通过查看镜像的Dockerfile或文档说明确认。 - 如果官方镜像不包含所需功能,可以基于官方镜像自行扩展。例如,在Dockerfile中添加Clip相关的依赖安装命令:

FROM registry.cn-shanghai.aliyuncs.com/serverless_devs/modelscope:ubuntu20.04-cuda11.3.0-py37-torch1.11.0-tf1.15.5-1.5.0

# 安装Clip相关依赖

RUN pip install clip

官方镜像中的推理框架版本可能较低,导致某些高级功能(如Clip反推)无法正常工作。根据知识库信息,函数计算的基础镜像版本是固定的,如果您需要更高版本的推理框架,可能需要自行构建镜像。

解决方法: - 确认当前镜像中安装的推理框架版本是否满足Clip反推的需求。例如,检查PyTorch版本:

python -c "import torch; print(torch.__version__)"

Clip反推功能可能需要特定的代码逻辑或配置文件支持。如果您的应用代码中未正确实现或调用Clip反推逻辑,可能导致该功能不可用。

解决方法: - 确保您的代码中已正确引入并调用Clip相关模块。例如:

import clip

import torch

# 加载Clip模型

model, preprocess = clip.load("ViT-B/32", device="cuda")

函数计算的GPU实例依赖NVIDIA提供的驱动和CUDA环境。如果您的代码或依赖库对特定版本的驱动或CUDA有强依赖,可能会因版本不匹配导致功能异常。

解决方法: - 确认函数计算实例的CUDA版本是否与您的代码或依赖库兼容。可以通过以下命令检查CUDA版本:

nvcc --version

如果以上方法均无法解决问题,建议加入函数计算官方用户群(钉钉群号:11721331)获取技术支持。技术支持团队可以帮助您分析具体问题,并提供针对性的解决方案。

重要提醒: - 避免在镜像中添加驱动相关的组件,以免因版本不匹配导致未定义行为。 - 如果需要自定义镜像,请确保遵循函数计算的最佳实践,例如使用官方基础镜像作为起点,并避免使用docker commit命令创建镜像。

通过以上步骤,您可以逐步排查并解决Clip反推功能不可用的问题。如果仍有疑问,请随时联系技术支持团队获取进一步帮助。