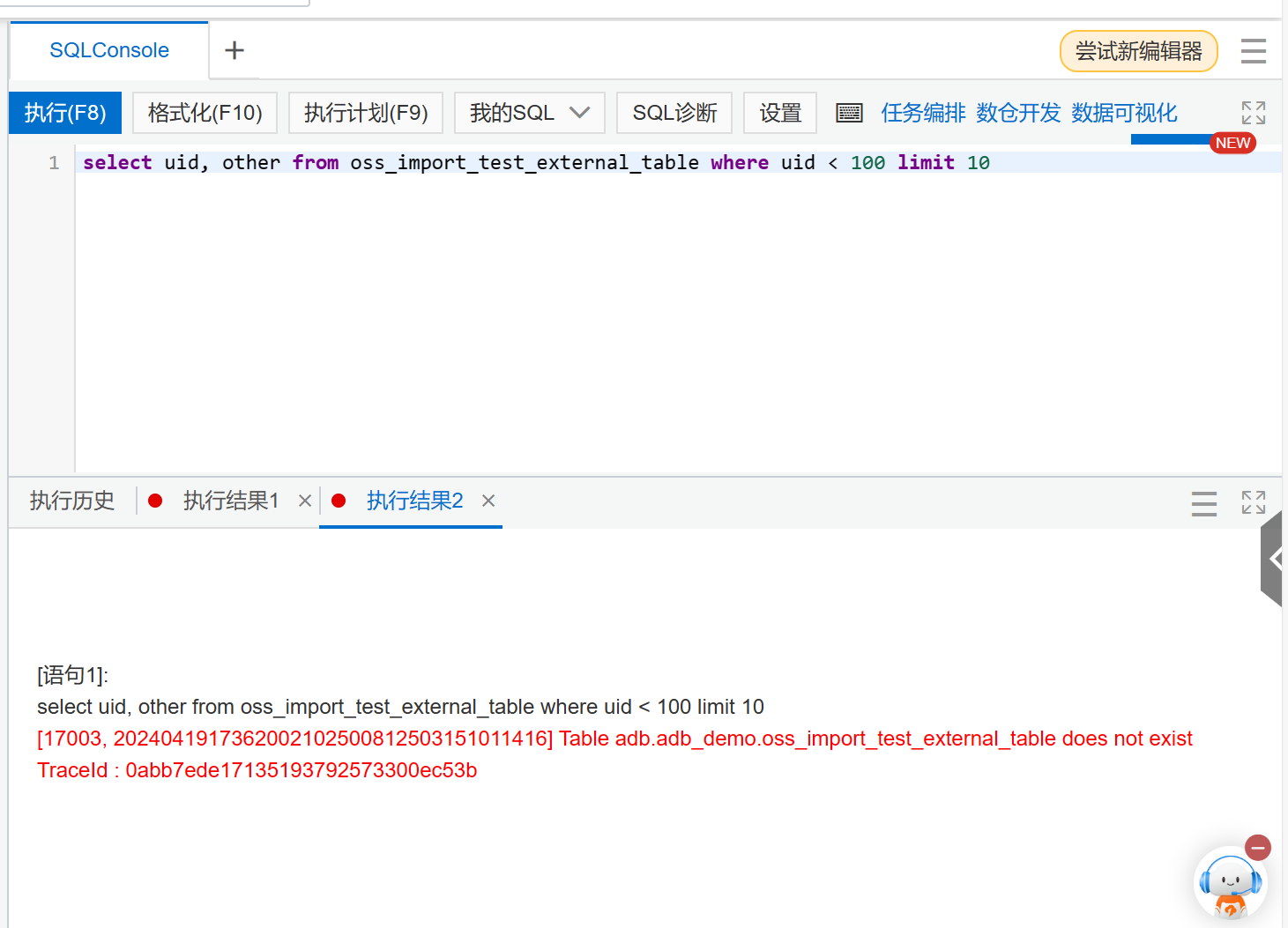

云数据仓库ADB这是报啥错呀,是地址填错了吗?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您提供的错误信息“云数据仓库ADB报错”,结合知识库中的相关资料,以下是可能的原因及解决方法:

如果错误信息中包含类似Communications link failure或unknown host的提示,可能是由于网络配置问题导致的。

如果错误信息中包含类似unknown host或ts.adb.com的提示,可能是DNS解析失败导致的。

spark.adb.eni.adbHostAlias.enabled=true以解决DNS解析问题。如果错误信息中包含table is not ready,说明新创建的表尚未分配资源,无法立即查询。

如果错误信息中包含NO_NODES_AVAILABLE,说明数据库内部某个计算节点压力较大,暂时离线。

如果错误信息中包含scanRows exceed limit,说明SQL扫描的行数超过了系统限制。

SELECT的列是否必要,减少列数可以增加可扫描的数据条数。如果错误信息与分区键或生命周期相关,例如partition format function error或LIFECYCLE设置不生效,可能是分区键定义或数据写入不符合要求。

SHOW CREATE TABLE <table_name>查看建表语句,确认生命周期设置是否正确。如果错误信息与上述情况均不匹配,可能是以下原因导致的: - 广播表过大:错误信息中包含Cannot broadcast the table that is larger than,说明广播表大小超过了限制。 - 解决方法:调整spark.sql.autoBroadcastJoinThreshold参数,建议不超过400MB。 - 磁盘空间不足:错误信息中包含No space left on device,说明磁盘空间不足。 - 解决方法:通过spark.adb.executorDiskSize参数挂载额外磁盘。

请根据具体的错误信息判断问题原因,并参考上述解决方法进行排查。如果问题仍未解决,建议提供完整的错误日志,联系AnalyticDB技术支持进一步排查。

重要提醒:在排查问题时,请确保网络配置、安全组规则和VPC设置正确,避免因基础环境问题导致的错误。

阿里云自主研发的云原生数据仓库,具有高并发读写、低峰谷读写、弹性扩展、安全可靠等特性,可支持PB级别数据存储,可广泛应用于BI、机器学习、实时分析、数据挖掘等场景。包含AnalyticDB MySQL版、AnalyticDB PostgreSQL 版。