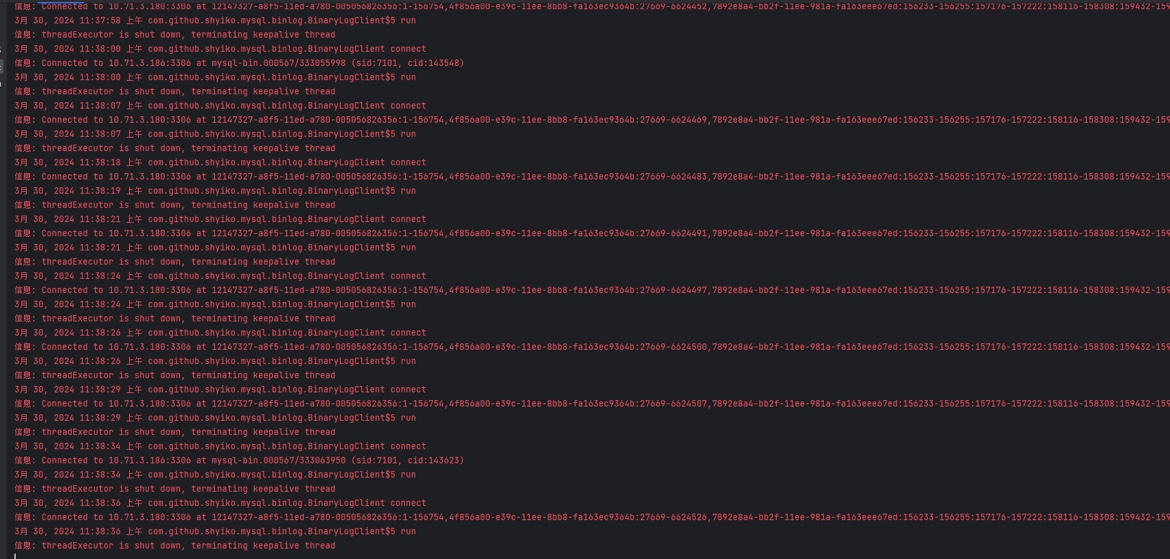

Flink CDC里控制台频繁打印这些信息一般是因为什么,是正常现象还是异常现象?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在使用 Flink CDC 时,如果控制台频繁打印某些信息,可能是由以下原因导致的。这些信息可能是正常现象,也可能是异常现象,需要根据具体情况进行分析和判断。

在非正常情况下(例如发生故障时),Debezium 只能保证 at-least-once 的投递语义,这可能导致重复的变更事件被投递到 Kafka 中。当 Flink 消费这些事件时,可能会频繁打印与重复事件相关的日志信息。

解决方法:

table.exec.source.cdc-events-duplicate 设置为 true。是否正常:

如果是由于故障导致的重复事件,这是 Debezium 的预期行为,但需要通过上述配置进行处理以避免对下游计算产生影响。

如果数据流中存在乱序数据,Flink 可能会频繁打印与 Watermark 或延迟数据相关的日志信息。例如,迟到的数据可能被丢弃,或者触发了延迟窗口计算。

原因分析:

解决方法:

WATERMARK FOR event_time AS event_time - INTERVAL '5' SECOND

是否正常:

数据乱序在分布式流处理中是常见现象,但如果频繁打印相关日志,则需要优化 Watermark 和窗口配置。

在维表 JOIN 场景中,如果查询不到数据,Flink 可能会频繁打印与维表缓存或查询失败相关的日志信息。

原因分析:

解决方法:

是否正常:

如果是由于配置错误导致的查询失败,则属于 异常现象,需要修正配置。

如果 Flink 作业的 Checkpoint 过程存在问题,可能会频繁打印与 Checkpoint 相关的日志信息,例如 Checkpoint 超时或写入失败。

原因分析:

解决方法:

python.fn-execution.bundle.size: 50000

python.fn-execution.bundle.time: 500

是否正常:

如果是由于反压或性能瓶颈导致的 Checkpoint 异常,则属于 异常现象,需要优化作业性能。

如果日志级别设置为 Info 或更低级别,Flink 可能会频繁打印调试信息或中间结果,尤其是在使用 Print 连接器时。

原因分析:

解决方法:

是否正常:

如果是由于日志级别设置不当导致的频繁打印,则属于 正常现象,但建议调整日志配置以减少干扰。

Flink CDC 控制台频繁打印信息的原因可能包括: 1. Debezium 投递重复事件。 2. 数据乱序或延迟触发窗口计算。 3. 维表 JOIN 查询不到数据。 4. Checkpoint 异常或性能问题。 5. 日志级别设置不当。

重要提醒:

- 正常现象:如日志级别设置不当、Debezium 的 at-least-once 投递语义等。

- 异常现象:如数据乱序、Checkpoint 异常、维表查询失败等,需根据具体场景进行优化和处理。

建议结合实际日志内容和作业运行状态,进一步排查问题根源并采取相应措施。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。