Flink目前hive-server2 endpoint 支持提交到不同集群么?

Flink目前hive-server2 endpoint 支持提交到不同集群么,还是说只支持绑定当前host集群, 如果上k8s的话需要每个cluster部署一个伴生hive-server2 endpoint么?

-

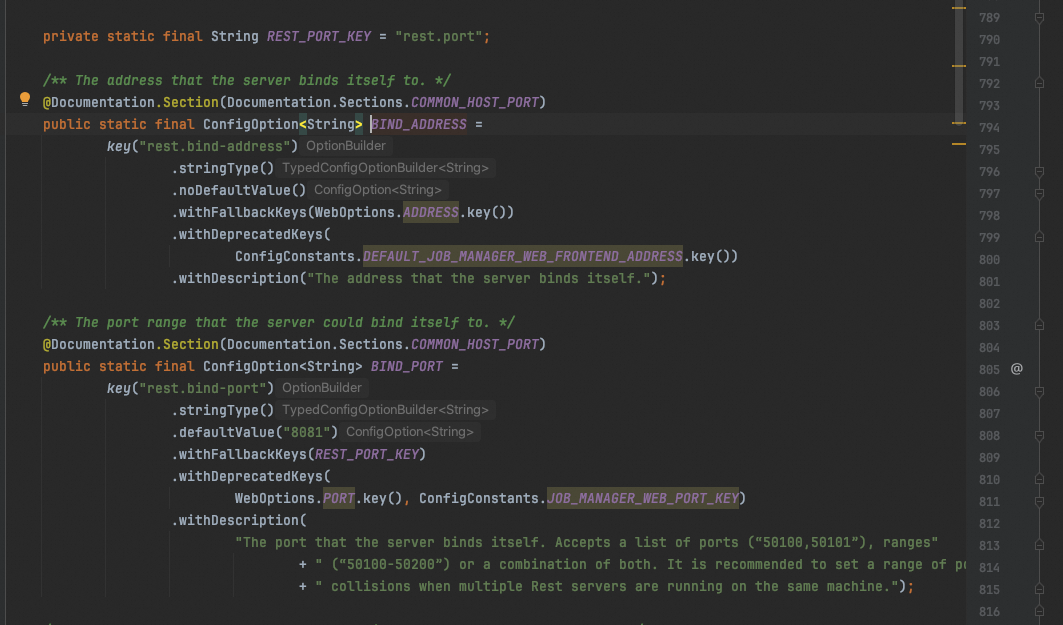

session 集群的话 set 下 rest 的地址就可以了。

,此回答整理自钉群“【②群】Apache Flink China社区”2024-03-19 20:26:23赞同 展开评论 打赏 -

Apache Flink 与 Hive 集成时,通常是通过 HiveCatalog 或者其他类似的 Catalog 实现来连接 Hive 的元数据。对于 HiveServer2 endpoint,这通常用于提供对 Hive 元数据的访问,以及在某些情况下执行 SQL 查询。

关于你的问题:

Flink 是否支持将 HiveServer2 endpoint 提交到不同集群:

Flink 本身并不直接“提交”到 HiveServer2 endpoint。相反,它使用 HiveServer2 作为元数据的访问点。Flink 可以配置为连接到任何可达的 HiveServer2 实例,无论它位于哪个集群上。但是,这并不意味着 Flink 可以跨集群执行查询或操作数据——它只是使用 HiveServer2 来获取元数据。是否只支持绑定当前 host 集群:

不是。Flink 配置中的 HiveServer2 endpoint 可以指向任何网络可达的地址,无论它是否位于与 Flink 相同的集群或主机上。在 Kubernetes 上部署时的情况:

如果你在 Kubernetes 上部署 Flink 和 Hive,并且希望 Flink 能够访问 Hive 的元数据,那么你需要确保 HiveServer2 是可达的。这可以通过多种方式实现:在同一个 Kubernetes 集群中部署 HiveServer2:这样,Flink Pod 就可以通过 Kubernetes 的服务发现机制(如 Service)来访问 HiveServer2。

使用外部 HiveServer2:如果 HiveServer2 部署在另一个集群或云环境中,你需要确保 Flink Pod 能够通过网络访问到它。这可能涉及到配置 VPN、VPC Peering 或其他网络连通性方案。

为每个 Flink 集群部署伴生的 HiveServer2:这不是必须的,但取决于你的具体需求和架构。如果你有多个 Flink 集群,并且每个集群都需要独立地访问 Hive 元数据,那么为每个集群部署一个 HiveServer2 实例可能是有意义的。但是,如果所有的 Flink 集群都可以共享相同的 Hive 元数据,那么一个共享的 HiveServer2 实例可能就足够了。

2024-03-19 15:24:09赞同 展开评论 打赏

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。