dataworks一个py3任务实例默认内存大小是多少?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

DataWorks中一个Py3任务实例的默认内存大小并没有明确的公开标准。

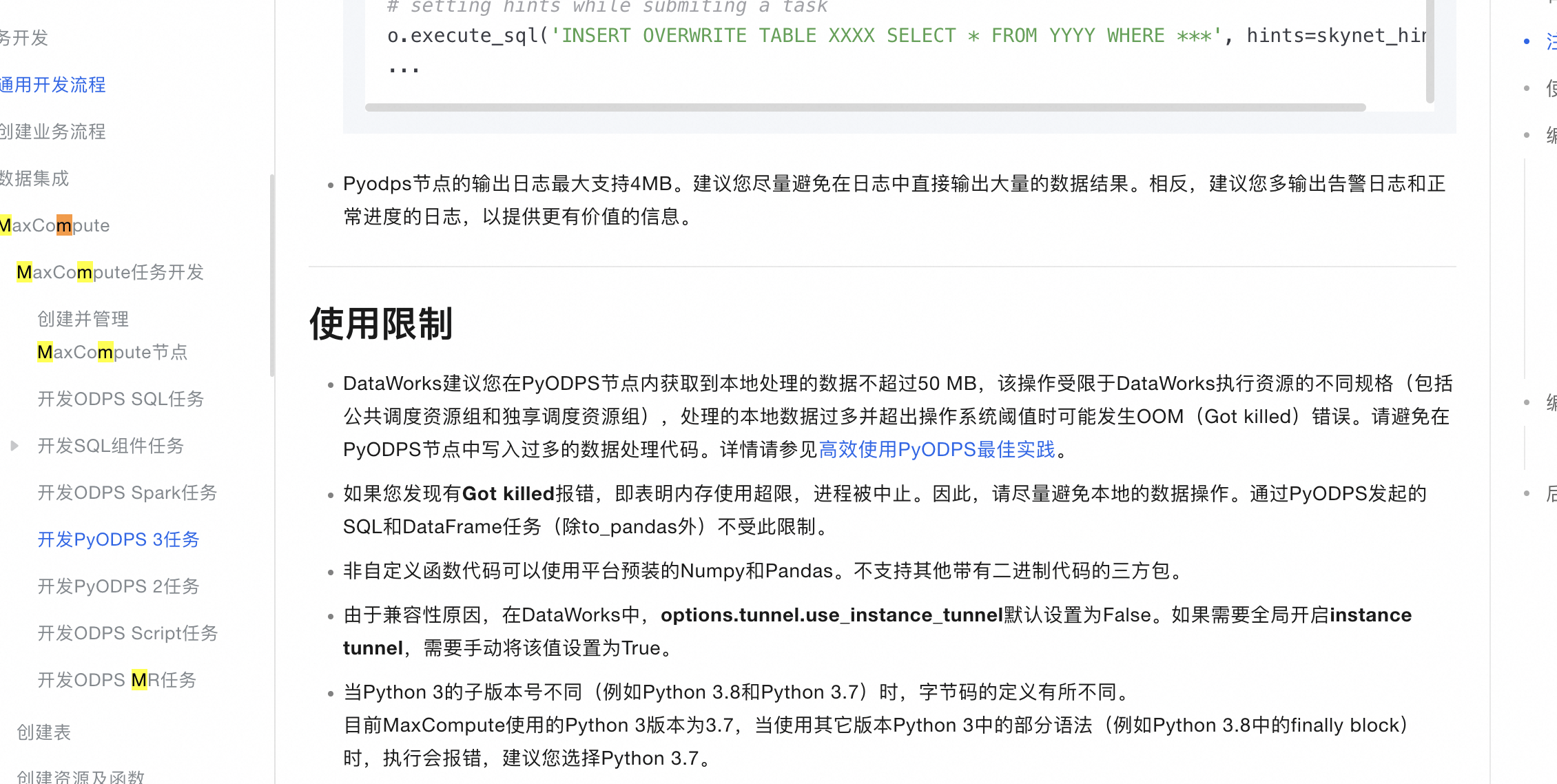

DataWorks作为阿里云提供的一个大数据开发治理平台,其资源的配置包括内存分配往往取决于用户选择的服务规格和设置。对于PyODPS节点,建议本地处理的数据不超过50MB,以避免发生内存溢出(OOM)错误。这表明,在不进行特别配置的情况下,DataWorks的任务实例可能会受到一定的内存限制。如果用户需要处理更多数据或进行更复杂的计算,可能需要优化代码以减少内存使用,或者增加节点的资源规格。

此外,DataWorks提供了一些系统参数,如${bdp.system.cyctime}和${bdp.system.bizdate},但这些参数与内存分配无关,而是用于定义任务的运行时间和业务日期等。任务的超时时间也是可以配置的,但这同样不直接决定任务的内存大小。

因此,如果需要了解具体的默认内存大小或进行内存相关的配置,建议查阅阿里云DataWorks的官方文档或联系客服获取详细信息。同时,根据实际的任务需求和数据处理量,合理规划和调整资源配置,以确保任务的顺利执行。

看下使用限制哈 https://help.aliyun.com/zh/dataworks/user-guide/create-a-pyodps-3-node?spm=a2c4g.11186623.0.0.53f712a3REIfpq

,此回答整理自钉群“DataWorks交流群(答疑@机器人)”

DataWorks的任务实例默认内存大小并不是固定的,它取决于多种因素,如集群配置、资源组设置以及任务的具体需求等。

在DataWorks中,你可以为不同的任务实例分配不同的内存大小。这通常是在创建或编辑任务时,在任务配置部分进行设置的。你可以根据任务的预期负载和数据处理量来选择合适的内存大小。

如果你不确定某个任务实例的默认内存大小,建议查看DataWorks的官方文档或联系平台的技术支持团队以获取更准确的信息。此外,你还可以查看任务实例的执行日志或监控信息,以了解实际使用的内存情况,并根据需要进行调整。

需要注意的是,为任务实例分配过多的内存可能会导致资源浪费,而分配的内存过少则可能导致任务执行失败或性能下降。因此,在设置任务实例的内存大小时,需要根据实际情况进行权衡和调整。

DataWorks基于MaxCompute/Hologres/EMR/CDP等大数据引擎,为数据仓库/数据湖/湖仓一体等解决方案提供统一的全链路大数据开发治理平台。