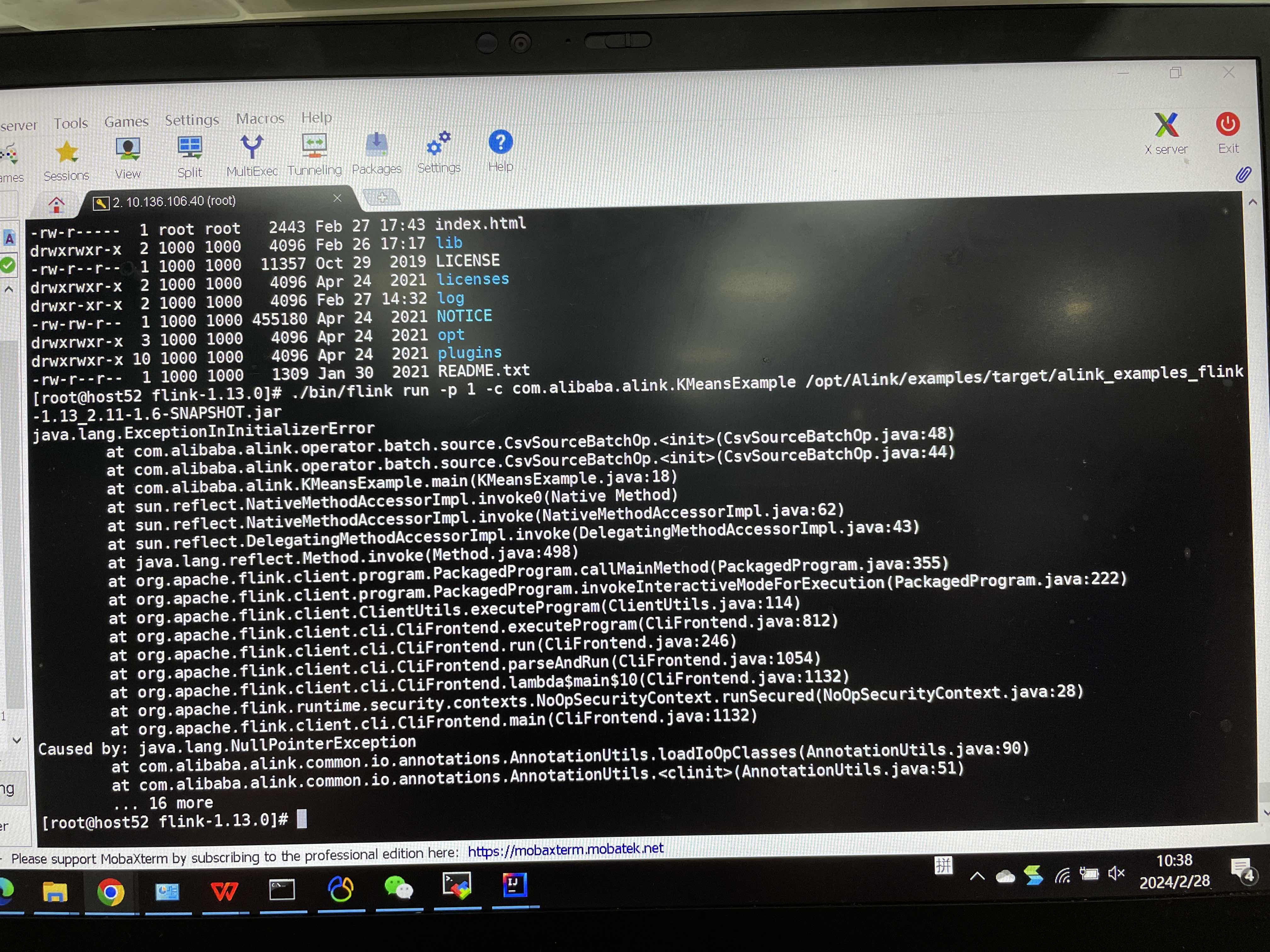

机器学习PAI 编译的jar包和部署的flink集群,报错误,有人知道是哪里出了问题吗?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

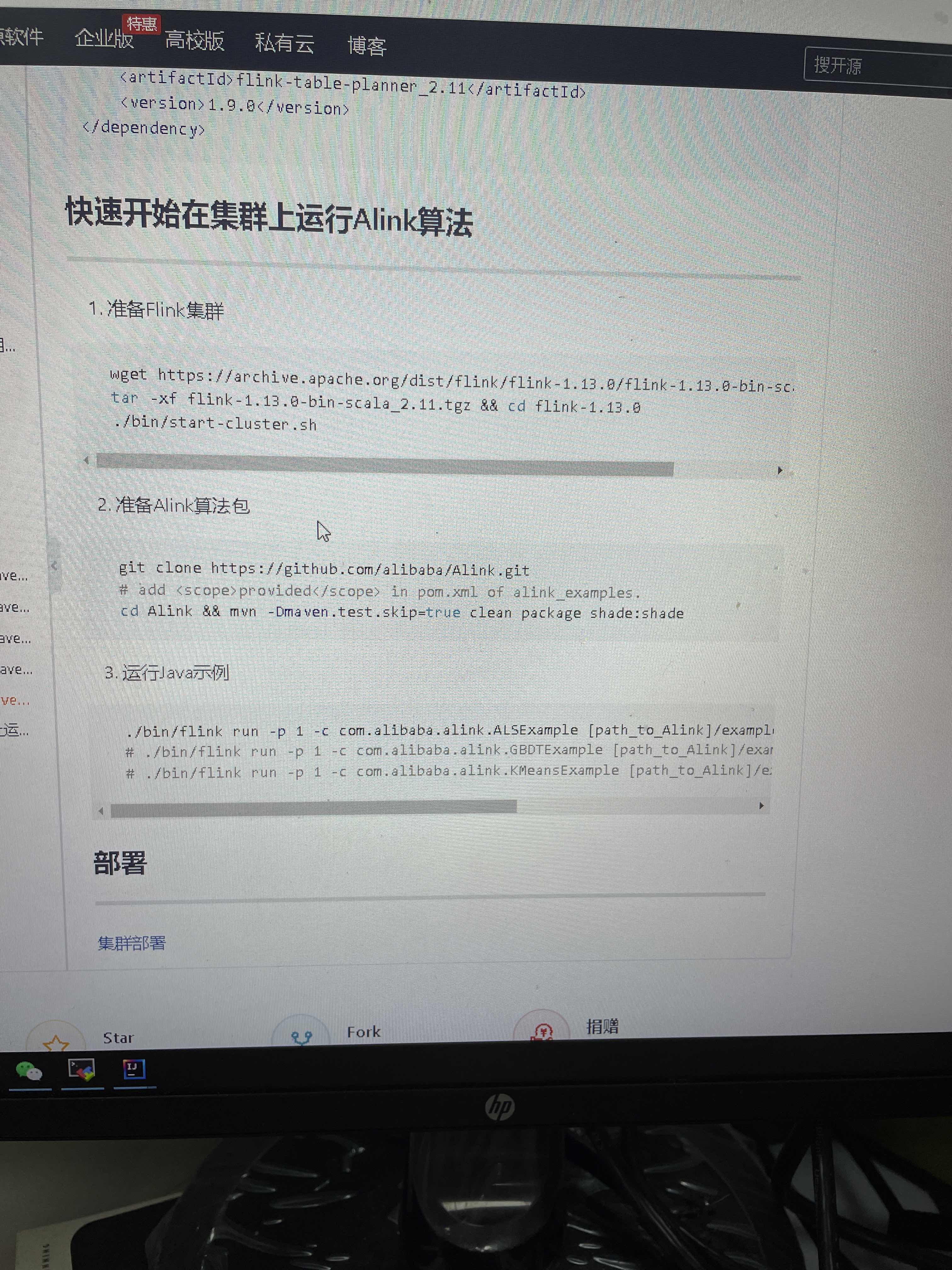

根据您提供的问题描述,机器学习PAI编译的JAR包在部署到Flink集群时出现错误。以下是可能的原因分析及解决方案,基于知识库中的相关资料进行整理:

java.lang.NoSuchMethodErrorjava.lang.ClassCastExceptionjava.lang.NoClassDefFoundErrorjava.lang.AbstractMethodErrorinternal API,而阿里云Flink版本对这些API进行了优化或修改,导致兼容性问题。org.codehaus.janino.CompilerFactory)在不同机器上的类加载顺序不一致,引发类冲突。deps.zip)未正确上传或配置。pipeline.classpaths正确指定。mvn dependency:tree命令查看项目的依赖树,检查是否存在冲突的依赖。jar tf <your-jar-file>命令查看JAR包内容,确认是否包含不必要的依赖。调整依赖作用域:

org.apache.flink组下的非Connector依赖),建议将作用域设置为provided,避免将其打包到JAR中。例如:

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-streaming-java_2.11</artifactId>

<version>${flink.version}</version>

<scope>provided</scope>

</dependency>

maven-shade-plugin对相关类进行重定位(relocation)。解决类加载冲突:

org.codehaus.janino.CompilerFactory类冲突,可以在Flink运行参数中添加以下配置:

classloader.parent-first-patterns.additional: org.codehaus.janino

配置方法: 1. 在运维中心 > 作业运维页面,单击目标作业名称。 2. 在部署详情 > 运行参数配置区域,输入上述参数后保存。

pipeline.classpaths指定类路径。例如:

pipeline.classpaths: 'file:///flink/usrlib/jar1.jar;file:///flink/usrlib/jar2.jar'

deps.zip文件上传至Flink集群。deps.zip。deps.zip。def map():

with open("/flink/usrlib/data.txt") as f:

...

dependency中的exclusions排除相关依赖。maven-shade-plugin对log4j相关类进行重定位。Cannot allocate the requested resources或NoResourceAvailableException。classloader.parent-first-patterns.additional参数调整类加载顺序。如果您能提供具体的报错信息,可以进一步帮助您定位问题并提供更精确的解决方案。

人工智能平台 PAI(Platform for AI,原机器学习平台PAI)是面向开发者和企业的机器学习/深度学习工程平台,提供包含数据标注、模型构建、模型训练、模型部署、推理优化在内的AI开发全链路服务,内置140+种优化算法,具备丰富的行业场景插件,为用户提供低门槛、高性能的云原生AI工程化能力。