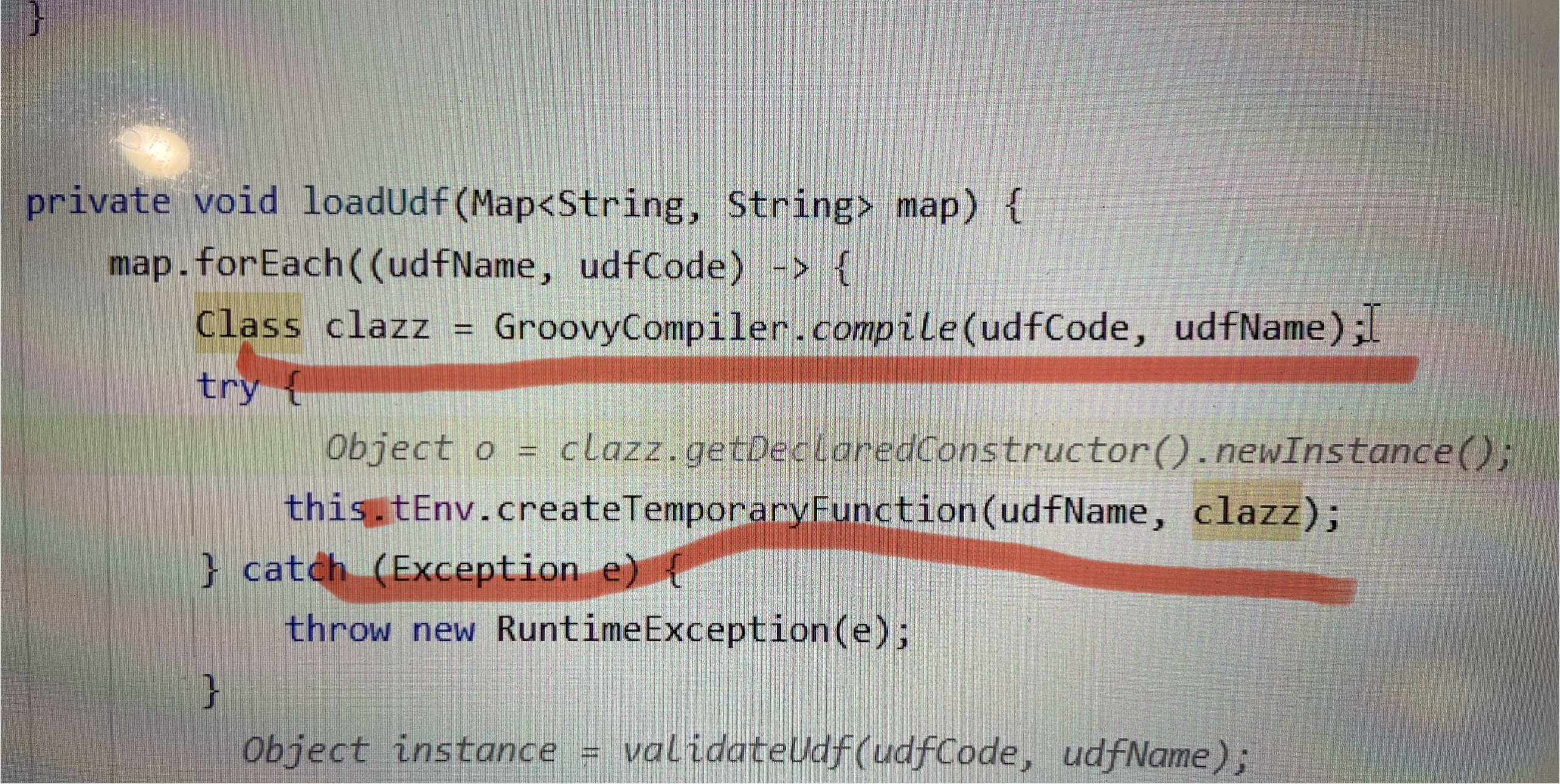

请问一下,flink sql udf 通过字符串这样传进来,然后用groovy编译成Class,然后通过tableEnv去注册,这样会报错。大家有没有一个好办法,实现外面传个字符串就能注入进tableEnv的udf的?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

你可以尝试使用Class.forName()方法将字符串转换为类对象,然后使用tableEnv.createTemporaryFunction()方法注册UDF。以下是一个示例:

import org.apache.flink.table.api.TableEnvironment;

import org.apache.flink.table.functions.ScalarFunction;

public class UDFRegistration {

public static void main(String[] args) throws Exception {

// 假设你已经有一个字符串表示的Groovy函数

String groovyFunction = "return x * 2";

// 将字符串转换为类对象

Class<?> clazz = Class.forName("groovy.lang.GroovyShell");

Object shellInstance = clazz.getDeclaredConstructor().newInstance();

clazz = Class.forName("org.codehaus.groovy.control.CompilerConfiguration");

Object configInstance = clazz.getDeclaredConstructor().newInstance();

clazz = Class.forName("org.codehaus.groovy.control.customizers.ImportCustomizer");

Object importCustomizerInstance = clazz.getDeclaredConstructor(String.class).newInstance("groovy.sql");

clazz = Class.forName("org.codehaus.groovy.control.customizers.StaticMethodsCustomizer");

Object staticMethodsCustomizerInstance = clazz.getDeclaredConstructor().newInstance();

clazz = Class.forName("org.codehaus.groovy.runtime.InvokerHelper");

Object invokerHelperInstance = clazz.getDeclaredConstructor().newInstance();

clazz = Class.forName("org.codehaus.groovy.runtime.ScriptBytecodeAdapter");

Object scriptBytecodeAdapterInstance = clazz.getDeclaredConstructor().newInstance();

clazz = Class.forName("org.codehaus.groovy.runtime.TypeCheckingCompilerConfiguration");

Object typeCheckingCompilerConfigurationInstance = clazz.getDeclaredConstructor().newInstance();

clazz = Class.forName("groovy.sql.SqlOutputFormat");

Object outputFormatInstance = clazz.getDeclaredConstructor().newInstance();

// 注册UDF

TableEnvironment tableEnv = ...; // 获取TableEnvironment实例

ScalarFunction udf = new ScalarFunction() {

@Override

public Object evaluate(Object... arguments) {

// 在这里调用你的Groovy函数并返回结果

return null;

}

};

tableEnv.createTemporaryFunction("my_udf", udf);

}

}

请注意,这个示例使用了Groovy库,你需要将其添加到你的项目依赖中。如果你使用的是Maven,可以在pom.xml文件中添加以下依赖:

<dependency>

<groupId>org.codehaus.groovy</groupId>

<artifactId>groovy-all</artifactId>

<version>3.0.9</version>

</dependency>

如果你使用的是Gradle,可以在build.gradle文件中添加以下依赖:

implementation 'org.codehaus.groovy:groovy-all:3.0.9'

你可以尝试使用Flink的UDFRegistration接口来注册自定义的UDF。首先,你需要创建一个实现UDFRegistration接口的类,然后在该类的register方法中注册你的UDF。最后,将这个类的实例添加到TableEnvironment的udfManager中。

以下是一个简单的示例:

UDFRegistration接口的类:import org.apache.flink.table.functions.ScalarFunction;

import org.apache.flink.table.types.DataType;

import org.apache.flink.table.udf.UDFRegistration;

public class CustomUDFRegistration implements UDFRegistration {

private final String name;

private final DataType returnType;

private final ScalarFunction udf;

public CustomUDFRegistration(String name, DataType returnType, ScalarFunction udf) {

this.name = name;

this.returnType = returnType;

this.udf = udf;

}

@Override

public void register(TableEnvironment tableEnv) throws Exception {

tableEnv.createTemporarySystemFunction(name, returnType, udf);

}

}

import groovy.lang.Binding

import groovy.lang.GroovyShell

import org.apache.flink.table.api.TableEnvironment

import org.apache.flink.table.functions.ScalarFunction

// 假设你已经将字符串编译成Class对象,例如:compiledClass

Class<?> compiledClass = ...

// 从Class对象中获取UDF实例

Object udfInstance = compiledClass.newInstance()

// 创建UDFRegistration实例

CustomUDFRegistration customUDFRegistration = new CustomUDFRegistration("myUDF", DataTypes.STRING(), (ScalarFunction) udfInstance)

// 获取TableEnvironment实例

TableEnvironment tableEnv = ...

// 将UDFRegistration实例注册到TableEnvironment

customUDFRegistration.register(tableEnv)

这样,你就可以通过字符串动态地注册UDF到TableEnvironment了。注意,这个示例仅适用于简单的UDF,如果你的UDF需要参数或者有其他特殊需求,你可能需要进行相应的调整。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。