flink cdc哪个版本有sqlserverCatalog,能根据表名拿到对应的字段和字段类型?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

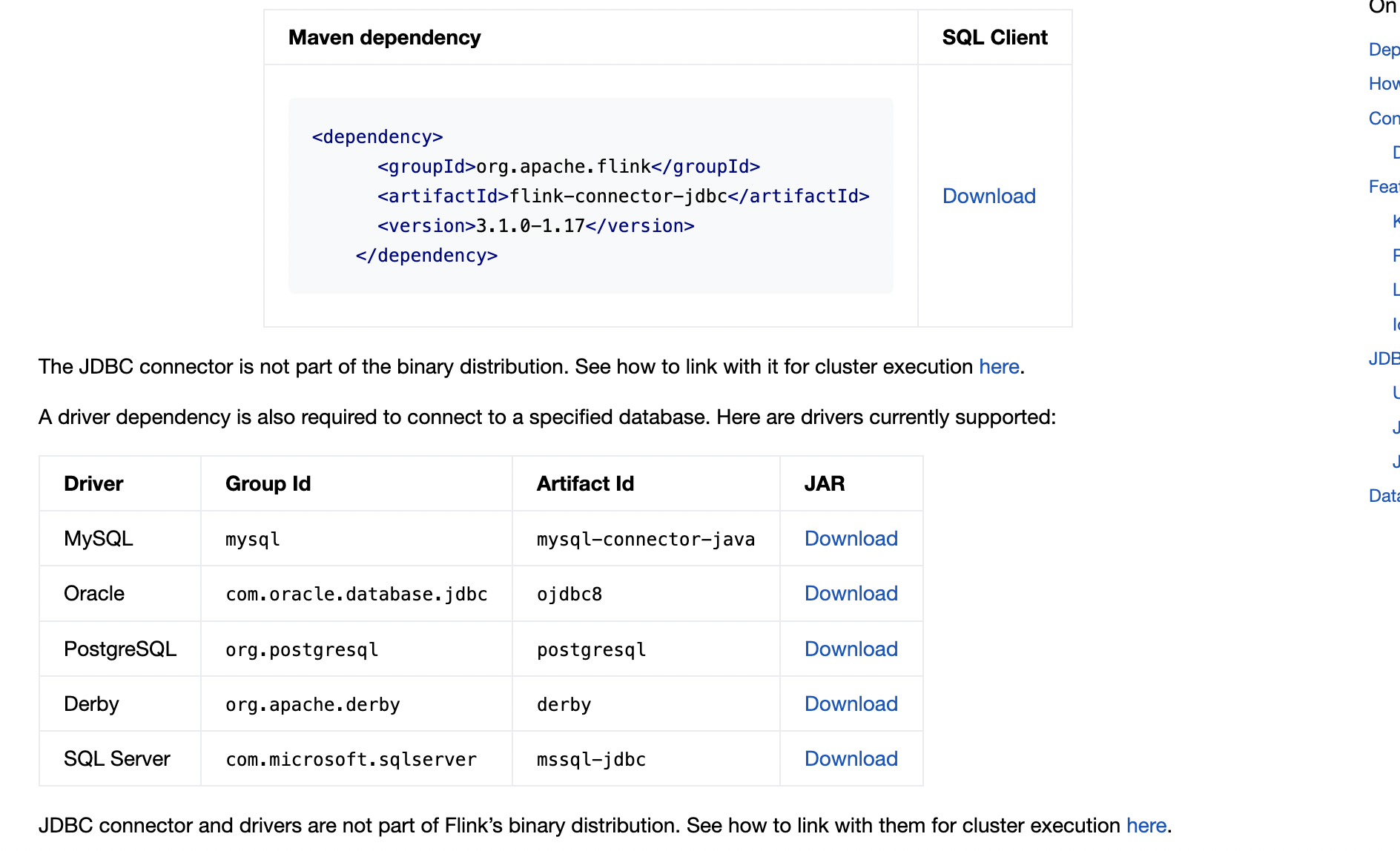

你指的是flink-connector-jdbc吧,这个是连接器的特性,1.17的好像就支持了

,此回答整理自钉群“Flink CDC 社区”

Apache Flink 1.12.x 版本对应的 Flink CDC 版本是 1.3.x,这个版本的Flink CDC支持sqlserverCatalog。通过使用Flink CDC,您可以根据表名获取到对应的字段和字段类型。同时,请注意,正确的配置非常关键,例如,如果表名、列名、主键、数据类型等配置不正确,可能会导致 Flink CDC 无法正确识别表结构以及数据变化。

Flink CDC 1.12版本引入了对SQL Server的支持,包括SqlServerCatalog和SqlServerTable。在SqlServerCatalog中,你可以根据表名获取对应的字段和字段类型。

要使用Flink CDC 1.12版本的SqlServerCatalog,你需要添加以下依赖到你的项目中:

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-connector-debezium_2.11</artifactId>

<version>1.12.0</version>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-connector-jdbc_2.11</artifactId>

<version>1.12.0</version>

</dependency>

然后,你可以创建一个SqlServerCatalog实例,并使用它来获取表的字段和字段类型:

import org.apache.flink.table.api.EnvironmentSettings;

import org.apache.flink.table.catalog.Catalog;

import org.apache.flink.table.catalog.hive.HiveCatalog;

import org.apache.flink.table.catalog.jdbc.JdbcCatalog;

import org.apache.flink.table.catalog.mysql.MySqlCatalog;

import org.apache.flink.table.catalog.postgres.PostgresCatalog;

import org.apache.flink.table.catalog.sqlite.SqliteCatalog;

import org.apache.flink.table.catalog.sqlserver.SqlServerCatalog;

import org.apache.flink.table.descriptors.*;

import org.apache.flink.types.Row;

public class Main {

public static void main(String[] args) {

env = StreamExecutionEnvironment.getExecutionEnvironment();

EnvironmentSettings settings = EnvironmentSettings.newInstance().useBlinkPlanner().inStreamingMode().build();

env.setExecutionEnvironment(settings);

// ...其他配置...

// 创建SqlServerCatalog实例

String name = "mySqlServer";

String defaultDatabase = "your_database";

String username = "your_username";

String password = "your_password";

String baseUrl = "jdbc:sqlserver://your_host:your_port;databaseName=" + defaultDatabase;

SqlServerCatalog sqlServerCatalog = new SqlServerCatalog(name, defaultDatabase, username, password, baseUrl);

env.registerCatalog("mySqlServer", sqlServerCatalog);

env.useCatalog("mySqlServer");

// 根据表名获取表的字段和字段类型

String tableName = "your_table_name";

try {

TableDescriptor tableDescriptor = sqlServerCatalog.getTable(tableName);

List<ColumnDescriptor> columns = tableDescriptor.getColumns();

for (ColumnDescriptor column : columns) {

System.out.println("Column Name: " + column.getName());

System.out.println("Column Type: " + column.getType().toString());

}

} catch (Exception e) {

e.printStackTrace();

}

}

}

请将上述代码中的your_database、your_username、your_password、your_host、your_port和your_table_name替换为实际的值。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。