flinkcdc的序列化器怎么重写?有教程吗?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在Flink CDC中,序列化器的重写通常与自定义数据类型或特定业务逻辑相关。以下是基于知识库资料的详细解答:

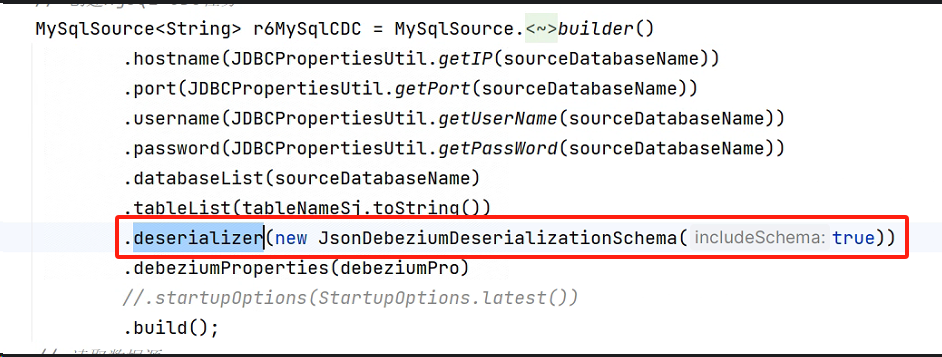

Flink CDC 的序列化器主要用于将数据从源端(如 MySQL)读取并转换为 Flink 内部可处理的数据格式。默认情况下,Flink 提供了对常见数据类型的内置支持。如果需要自定义序列化器,可以通过以下方式实现:

public 的。public 的无参数构造函数。public 或者提供符合 Java Bean 命名规范的 getter 和 setter 方法。如果默认的序列化器无法满足需求,可以通过以下步骤实现自定义序列化器:

Flink 支持通过 Java 编写自定义 UDF 函数,并将其用于序列化和反序列化操作。具体要求如下: - 实现 org.apache.flink.cdc.common.udf.UserDefinedFunction 接口。 - 提供一个公共无参构造器。 - 定义至少一个名为 eval 的公共方法,用于处理数据。

示例代码:

public class CustomSerializerFunction implements UserDefinedFunction {

// 自定义序列化逻辑

public String eval(String input) {

// 示例:将输入字符串转换为大写

return input.toUpperCase();

}

@Override

public DataType getReturnType() {

// 明确指定返回类型

return DataTypes.STRING();

}

@Override

public void open() throws Exception {

// 初始化逻辑(可选)

}

@Override

public void close() throws Exception {

// 清理逻辑(可选)

}

}

将自定义的序列化器注册为 UDF 函数后,可以在 Flink SQL 中调用。例如:

CREATE FUNCTION custom_serializer AS 'com.example.CustomSerializerFunction';

在 Flink CDC 的 YAML 配置文件中,可以通过 UDF 函数对数据进行自定义处理。例如:

functions:

- name: custom_serializer

className: com.example.CustomSerializerFunction

pipeline:

source:

connector: mysql-cdc

hostname: "rm-bp1z69dodhh85z9qa.mysql.rds.aliyuncs.com"

port: 3306

username: "workshop"

password: "workshop#2017"

database-name: "github_events_share"

table-name: "events"

sink:

connector: starrocks

load-url: "fe-c-9b354c83e891****-internal.starrocks.aliyuncs.com:8030"

transform:

- "custom_serializer(column_name)"

通过以上步骤,您可以成功重写 Flink CDC 的序列化器以满足特定业务需求。如果有进一步的问题,请随时补充说明!

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。