flinkcdc的序列化器怎么重写?有教程吗?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

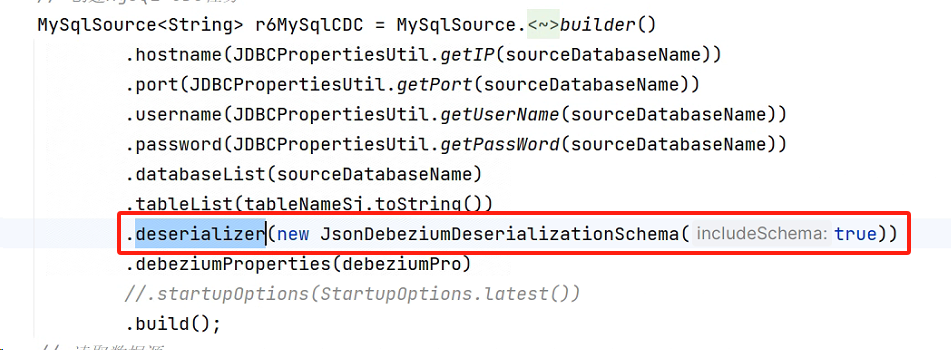

在使用 Flink CDC 时,序列化器的重写通常是为了满足特定的数据格式需求或优化数据传输效率。以下是关于如何重写 Flink CDC 序列化器的详细步骤和方法:

Flink 的序列化机制依赖于其内部的类型系统,支持多种序列化方式,包括 POJO、Avro、Kryo 等。对于自定义序列化器,您需要实现 Flink 提供的相关接口或扩展其默认行为。

根据知识库中的信息,Flink 对 POJO 类型的序列化有明确的规则: - 类必须是 public。 - 必须有一个 public 的无参数构造函数。 - 所有非静态、非瞬态字段必须是 public 或提供符合 Java Bean 命名规范的 getter 和 setter 方法。

如果您的数据模型不符合这些规则,则需要自定义序列化器。

org.apache.flink.api.common.serialization.SerializationSchema 接口Flink 提供了 SerializationSchema 接口,用于将数据对象序列化为字节数组。以下是一个示例代码:

import org.apache.flink.api.common.serialization.SerializationSchema;

import org.apache.flink.shaded.jackson2.com.fasterxml.jackson.databind.ObjectMapper;

public class CustomSerializationSchema<T> implements SerializationSchema<T> {

private static final ObjectMapper objectMapper = new ObjectMapper();

@Override

public byte[] serialize(T element) {

try {

// 将对象序列化为 JSON 字符串并转换为字节数组

return objectMapper.writeValueAsBytes(element);

} catch (Exception e) {

throw new RuntimeException("序列化失败", e);

}

}

}

说明: - 使用 Jackson 的 ObjectMapper 将对象序列化为 JSON 格式。 - 您可以根据需求替换为其他序列化工具(如 Protobuf、Avro 等)。

在 Flink CDC 的任务配置中,您可以通过 YAML 文件或代码显式指定自定义序列化器。例如,在 YAML 配置中:

sink:

connector: starrocks

serialization-schema: com.example.CustomSerializationSchema

或者在代码中通过 StreamExecutionEnvironment 设置:

env.addSink(

new StarRocksSink<>(

new CustomSerializationSchema<>(),

// 其他配置参数

)

);

如果您需要更复杂的序列化逻辑,可以结合 UDF 函数实现。根据知识库中的描述,UDF 函数需要满足以下要求: - 实现 org.apache.flink.cdc.common.udf.UserDefinedFunction 接口。 - 提供一个公共无参构造器。 - 至少包含一个名为 eval 的公共方法。

以下是一个示例 UDF 函数,用于在序列化前对数据进行预处理:

import org.apache.flink.cdc.common.udf.UserDefinedFunction;

import org.apache.flink.table.types.DataType;

import org.apache.flink.table.types.logical.IntType;

public class PreprocessUDF extends UserDefinedFunction {

public String eval(String input) {

// 示例:对输入字符串进行简单处理

return input.toUpperCase();

}

@Override

public DataType getReturnType() {

return DataTypes.STRING();

}

}

上述内容基于以下知识库资料整理: - Flink POJO 序列化规则 - Flink CDC 的 UDF 函数定义

如果您需要更详细的教程或示例代码,可以参考官方文档或社区资源。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。