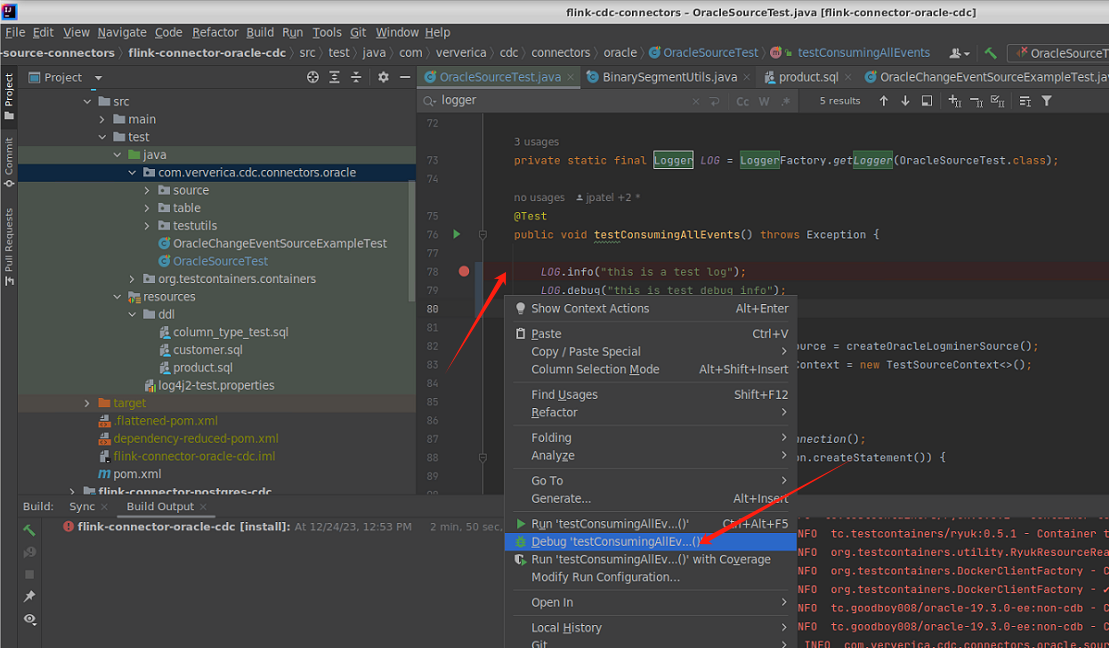

Flink CDC在IDEA环境中是怎么进行调试的?我在test函数中设置了断点,然后选择“ Debug testxxxx",断点没有命中,也没有输出我添加的log。但是确实每次选择debug都会重新编译一次。比如我这个图?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在IDEA环境中调试Flink CDC作业时,可能会遇到断点未命中或日志未输出的问题。以下是详细的解决方案和操作步骤,帮助您正确配置和调试Flink CDC作业。

Flink CDC作业的调试需要确保以下依赖和环境配置正确:

flink-connector-mysql-cdc等)。uber JAR包:

Configuration conf = new Configuration();

conf.setString("pipeline.classpaths", "file:///path/to/your-uber.jar");

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment(conf);

ververica-classloader相关的JAR包到运行配置中:

ververica-classloader JAR包。-Dlog4j.configuration=file:///path/to/log4j.properties

org.apache.flink.configuration.Configuration),在“Modify options”中勾选“Add dependencies with provided scope to classpath”。@Test

public void testCdcSource() throws Exception {

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

// 设置断点

env.execute("Test CDC Source");

}

env.execute()方法被执行,否则Flink作业不会启动。如果调试时没有输出日志,可能是日志配置或输出方式存在问题:

log4j.properties或logback.xml)。例如:

log4j.rootLogger=INFO, console

log4j.appender.console=org.apache.log4j.ConsoleAppender

log4j.appender.console.layout=org.apache.log4j.PatternLayout

log4j.appender.console.layout.ConversionPattern=%d{yyyy-MM-dd HH:mm:ss} %-5p %c{1}:%L - %m%n

System.out.println验证System.out.println语句,验证代码是否被执行。例如:

System.out.println("Debugging CDC source...");

DEBUG或更低,以便捕获更多调试信息。例如:

log4j.logger.org.apache.flink=DEBUG

env.execute(),否则Flink作业不会启动。ClassNotFoundException,请检查pipeline.classpaths配置是否正确。Build > Rebuild Project。通过上述步骤,您可以解决Flink CDC在IDEA环境中调试时断点未命中或日志未输出的问题。关键在于确保依赖配置正确、运行环境设置无误,以及日志输出配置合理。如果问题仍然存在,建议检查具体的异常信息,并根据错误提示进一步排查。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。