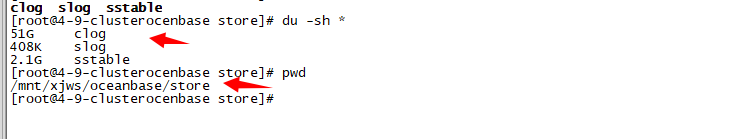

OceanBase数据库我发现这个clog日志太大了,我要是删除的话有什么需要注意的么,我的是集群是3个要一起删还是可以单独删?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

可以调整log_disk_utilization_threshold试下,一般默认80%,超过80%的clog空间使用会进行自动回收。

clog里面的文件不能手动删除哈,否则会出现不可预估的问题 ,此回答整理自钉群“[社区]技术答疑群OceanBase”

如果发现clog日志文件过大,处理起来需要非常小心。首先,clog默认位置位于/data/log1/下面。在删除或移动clog文件之前,您需要先停止集群的业务写入,防止clog盘临时腾挪的空间再次快速被业务写入打满。然后,建议您先少量执行100个clog文件的挪动,观察集群是否在恢复。这一步是为了确认您的操作是否安全有效。

另外,可以通过调整clog_disk_usage_limit_percentage参数来控制事务日志的磁盘I/O最大使用百分比,从而控制日志文件的大小。如果要解决磁盘不被很快占满的问题,还可以调高日志级别,只打印WARN或ERROR日志,这样可以延缓日志文件增长的速度。

参考下 节点日志盘(Clog)空间满https://www.oceanbase.com/docs/common-oceanbase-database-cn-1000000000218740

当遇到 clog 日志盘空间满的问题时,集群一般表现为无主选举,写入失败,缺副本等现象。

场景描述

业务写入数据失败,经排查发现后台 clog 日志盘满。

应急处理流程

在不损坏集群数据一致性的前提下修复 clog 盘空间满问题,一般需要遵循以下几个步骤:

主动停止租户的写入,防止 clog 盘临时腾挪的空间再次快速被业务写入打满,无法修复。

停止集群写入后,临时调大 clog 盘阈值比例,由 95% 调整到 98%。

ALTER system SET log_disk_utilization_limit_threshold = 98 server ='[IP 地址]:2882';

观察一段时间,多数情况下 clog 追上后,集群可以恢复,如果未恢复,联系 OceanBase 技术支持。