Flink CDC如何使用per job提交sql作业?

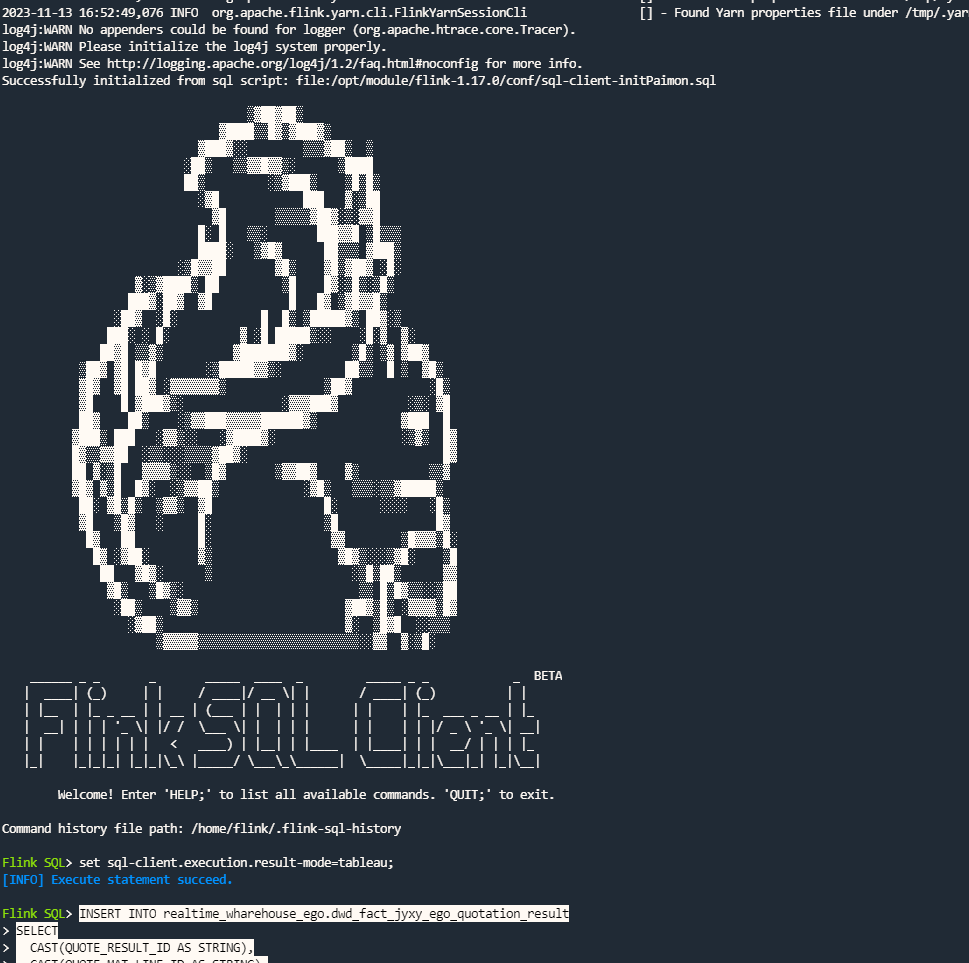

现在都是起一个yarn-session

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

Flink CDC可以通过以下方式进行per-job的模式提交Flink SQL作业:

但是session模式一直是不推荐的,yarn 现在官网推荐的不是Application Modehttps://nightlies.apache.org/flink/flink-docs-release-1.18/docs/deployment/resource-providers/yarn/%E5%90%B4%E6%B8%85%E8%93%9D,此回答整理自钉群“Flink CDC 社区”

Flink CDC支持通过Per Job提交SQL作业。具体步骤如下:

CREATE TABLE my_table (

id INT,

name STRING,

age INT

) WITH (

'connector' = 'mysql-cdc',

'hostname' = 'localhost',

'port' = '3306',

'username' = 'root',

'password' = 'password',

'database-name' = 'test',

'table-name' = 'my_table'

);

将上述SQL语句保存为一个文件,例如create_table.sql。

使用Flink的命令行工具或Web界面提交作业,并指定SQL文件的路径和名称,例如:

./bin/flink run -d -p 3306 /path/to/create_table.sql

其中,-d表示以detached模式运行作业,-p表示指定MySQL的端口号。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。