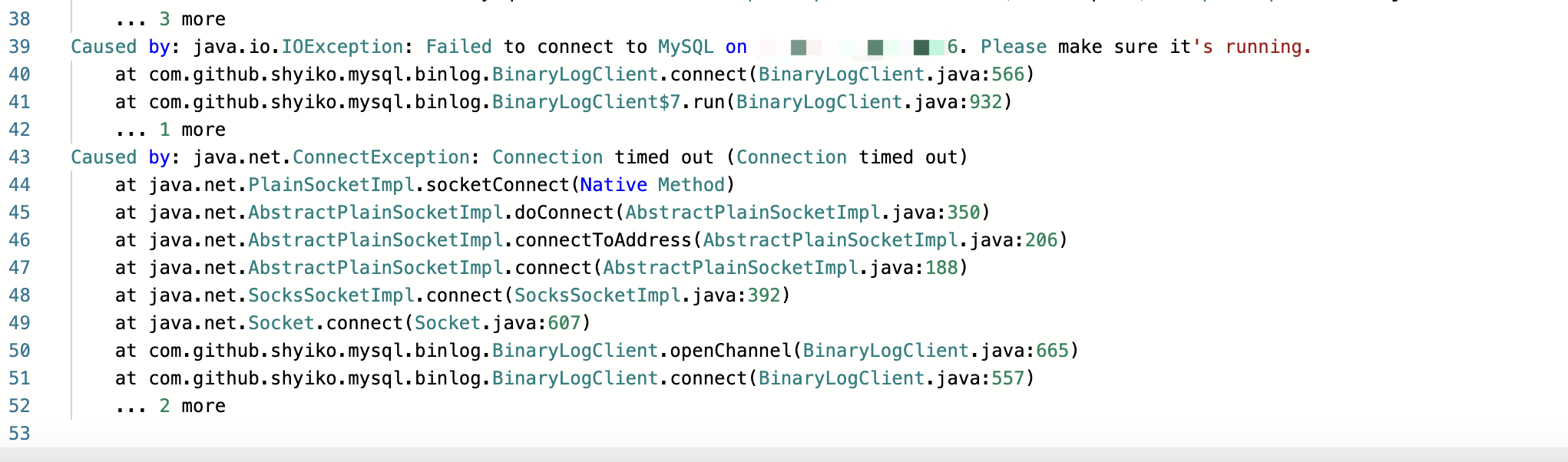

Flink CDC中用mysql-cdc 2.4.1版本的streamApi正则同步分库的一个表到kafka,有50个库里面,最大的一张表3千5百万左右。一共有9亿的数据,同步的时候总是提示mysql连接超时,我已经设置了cdc的connect.timeout=3600秒,但是过了几分钟就会提示这个超时. 目前还设置了,connection.poll.size=200,chunkSize设置的是60万。这个问题要怎么处理啊?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据你的描述,这可能是由以下几个因素引起的:

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。