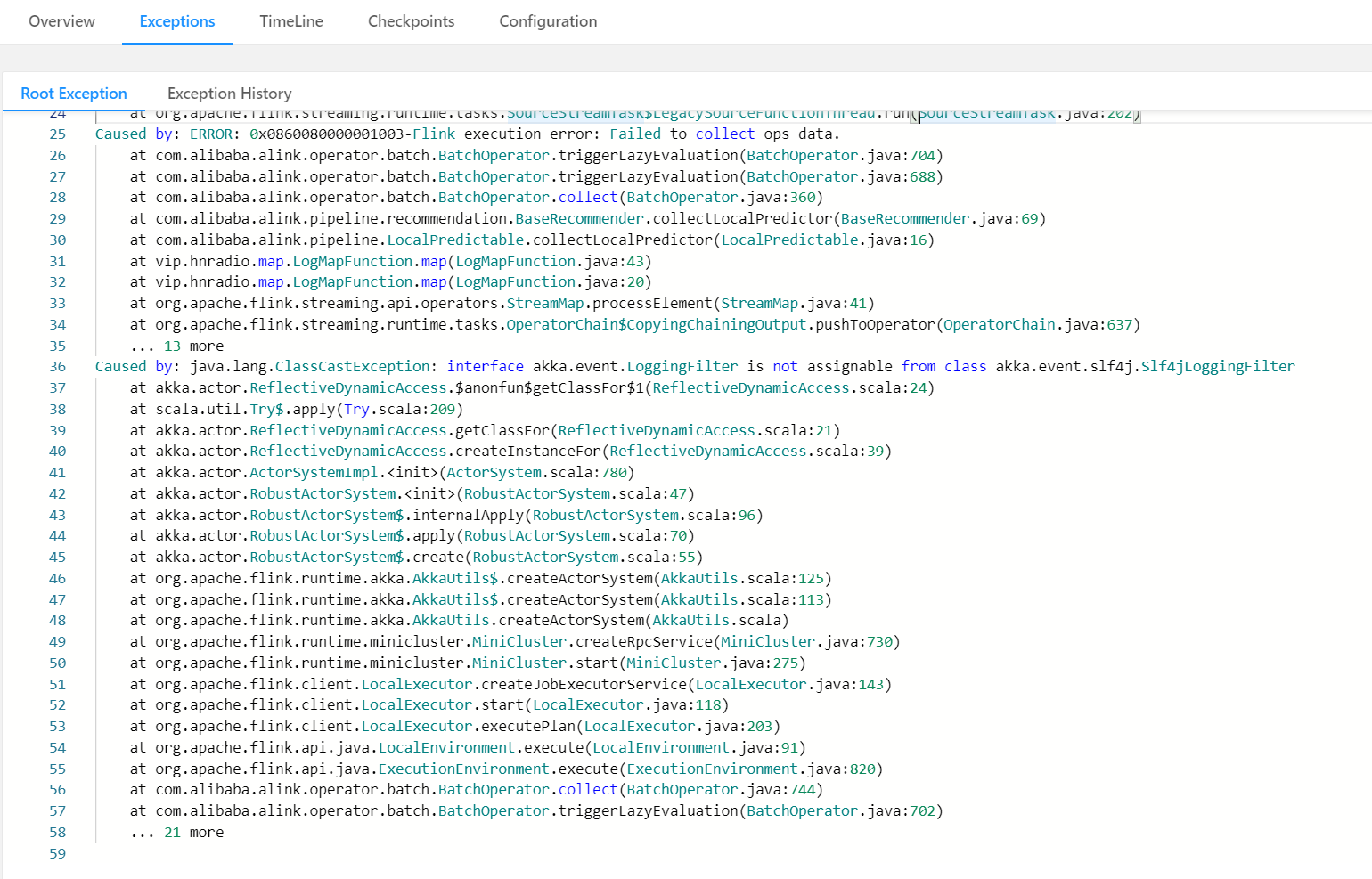

我现在在集群上提交了包含alink相关功能的flink任务,但是却报这样的错。 我在idea上跑是没问题的,而且也去除了log4j相关的依赖。 有没有大佬碰见过这样的问题的?我服务器上的flink是用docker启的,和本地的flink版本都是1.9.0

我在idea上跑是没问题的,而且也去除了log4j相关的依赖。 有没有大佬碰见过这样的问题的?我服务器上的flink是用docker启的,和本地的flink版本都是1.9.0

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

这个错误是由于Flink在运行时遇到了类型转换异常。具体来说,akka.event.LoggingFilter接口不能从akka.event.slf4j.slf4jLoggingFilter类分配。为了解决这个问题,你可以尝试以下方法:

确保你的项目中包含了正确的依赖库。检查你的pom.xml或build.gradle文件,确保已经添加了Akka和SLF4J的相关依赖。

如果你使用的是Maven,可以尝试在pom.xml文件中添加以下依赖:

<dependency>

<groupId>com.typesafe.akka</groupId>

<artifactId>akka-actor_2.12</artifactId>

<version>2.5.23</version>

</dependency>

<dependency>

<groupId>org.slf4j</groupId>

<artifactId>slf4j-api</artifactId>

<version>1.7.30</version>

</dependency>

build.gradle文件中添加以下依赖:implementation 'com.typesafe.akka:akka-actor_2.12:2.5.23'

implementation 'org.slf4j:slf4j-api:1.7.30'

mvn clean install

或者对于Gradle项目:

gradle clean build

slf4j没引好吧,看看FLINK平台里引的JAR包和版本和本地不一样的地方。FLINK平台里有原始自带的JAR 包。和你打包的又不一样。flink平台里的自带的其他jar包,不是flink jar 包 https://github.com/alibaba/Alink/blob/master/docs/deploy/cluster-deploy.md 把shade后的包放进lib目录,然后配置上classloader.resolve-order: parent-first,然后提交的时候把shipjars这个选项关了,应该就可以了——此回答来自钉群”Alink开源--用户群“

人工智能平台 PAI(Platform for AI,原机器学习平台PAI)是面向开发者和企业的机器学习/深度学习工程平台,提供包含数据标注、模型构建、模型训练、模型部署、推理优化在内的AI开发全链路服务,内置140+种优化算法,具备丰富的行业场景插件,为用户提供低门槛、高性能的云原生AI工程化能力。