大数据计算MaxCompute 使用客户端,最多不是10000条吗?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

默认单次最多可下载1W条数据,租户管理员、租户安全管理员可前往安全中心的数据查询与分析管控界面,设置单次可下载条数的上限。

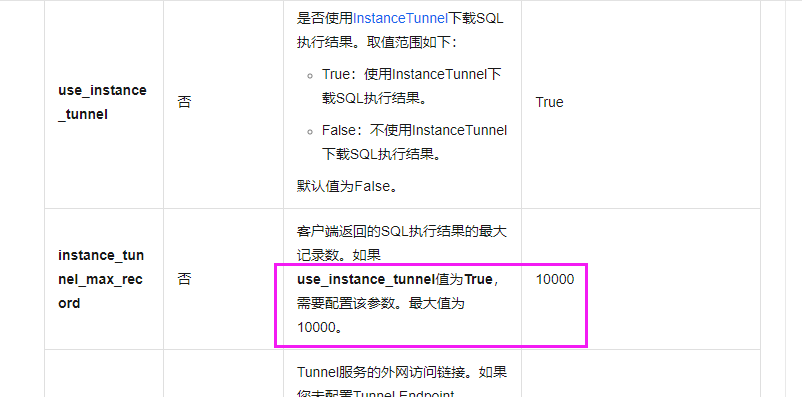

是的,MaxCompute的客户端(包括ODPS Command Line Tool和ODPS Studio)默认每次提交的SQL命令的最大行数为10000。这是为了防止单次提交的SQL命令过大,导致处理时间过长或内存溢出等问题。

然而,如果你需要处理的记录数超过10000条,你可以采取以下两种策略:

分多次提交:你可以将大表拆分为多个小表,然后分别提交查询。

使用批量处理:对于写入操作,MaxCompute提供了Batch Insert API,可以将多条记录一次性插入,而不受单次提交记录数的限制。

在MaxCompute中,使用客户端进行数据读取和写入时,通常可以一次性处理的记录数是有上限的。这个上限通常是10000条记录。

但是,如果你需要处理的数据量非常大,你也可以使用MaxCompute的MapReduce API来进行数据处理。MapReduce API可以将数据分发到多个计算节点上,并使用MapReduce脚本来处理数据。因此,使用MapReduce API可以处理的数据量没有上限。

另外,如果你需要处理的数据量非常大,你还可以考虑使用MaxCompute的Spark API来进行数据处理。Spark API可以将数据分发到多个计算节点上,并使用Spark API来处理数据。因此,使用Spark API可以处理的数据量也没有上限。

MaxCompute(原ODPS)是一项面向分析的大数据计算服务,它以Serverless架构提供快速、全托管的在线数据仓库服务,消除传统数据平台在资源扩展性和弹性方面的限制,最小化用户运维投入,使您经济并高效的分析处理海量数据。