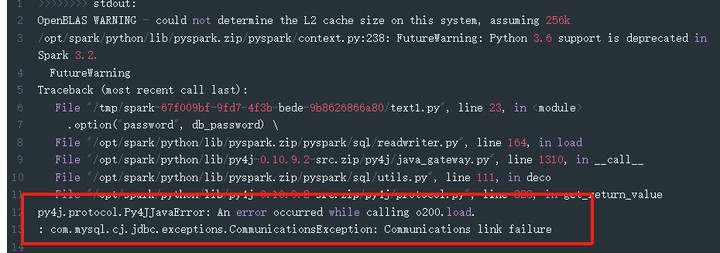

提交到adb3.0集群上的pyspark脚本连接不到云数据仓库ADB,而本地测试却连接的通什么原因?报错显示是连接ip被拒绝,要怎么解决?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

可能的原因有以下几点:

网络问题:请检查提交到adb3.0集群上的pyspark脚本的网络连接是否正常,确保可以访问云数据仓库ADB。

配置问题:请检查提交到adb3.0集群上的pyspark脚本中的连接配置是否正确,包括数据库地址、端口、用户名、密码等信息。

权限问题:请检查提交到adb3.0集群上的pyspark脚本是否具有访问云数据仓库ADB的权限,如果没有,需要联系管理员进行授权。

防火墙问题:请检查云数据仓库ADB的防火墙设置,确保允许提交到adb3.0集群上的pyspark脚本的IP地址进行访问。

集群资源问题:请检查adb3.0集群的资源使用情况,如CPU、内存等,确保有足够的资源供pyspark脚本运行。

如果您的pyspark脚本在本地测试可以连接到云数据仓库ADB,但在提交到ADB3.0集群上运行时却连接不上,可能是以下原因导致的:

解决上述问题的步骤如下:

可以参考一下这个连接问题的文档:https://help.aliyun.com/zh/analyticdb-for-mysql/support/connections?spm=a2c4g.11186623.0.i16 此回答整理自钉群“云数据仓库ADB-开发者群”

根据您提供的信息,您在提交到ADB3.0集群上的Pyspark脚本中连接不到云数据仓库ADB,而本地测试却连接的通。这个错误可能是由于您的ADB集群中的防火墙设置导致的。为了解决这个问题,您可以尝试以下方法:

阿里云自主研发的云原生数据仓库,具有高并发读写、低峰谷读写、弹性扩展、安全可靠等特性,可支持PB级别数据存储,可广泛应用于BI、机器学习、实时分析、数据挖掘等场景。包含AnalyticDB MySQL版、AnalyticDB PostgreSQL 版。