DataWorks离线同步,oss单文件大小上限是什么?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

DataWorks离线同步中,OSS单文件的上传大小上限是5GB。如果上传的文件超过了这个限制,OSS存储桶会自动进行分块处理。为了确保数据同步的稳定性和效率,建议在DataWorks的OSS数据源和OSS存储桶中都设置相同的maxFileSize,且尽量保持在10MB以下。如果您确实需要上传超过10MB的文件,可以考虑使用分块上传的方式。同时,要注意不超过阿里云OSS对单个文件的大小限制。

OSS/FTP/SFTP/HDFS同步后文件名加后缀的原因:

数据集成同步数据到OSS/FTP/SFTP/HDFS时将并行多线程写入,由于对应文件系统限制,只能生成多个不重名文件才可以保证同步任务的并发运行,所以在每个文件后面加上一串随机字符串防止文件名冲突

解决方法

目前只有OSS插件支持并发写入单个文件并且不会在文件后面加后缀,FTP/SFTP/HDFS插件不支持

OSS插件操作方法

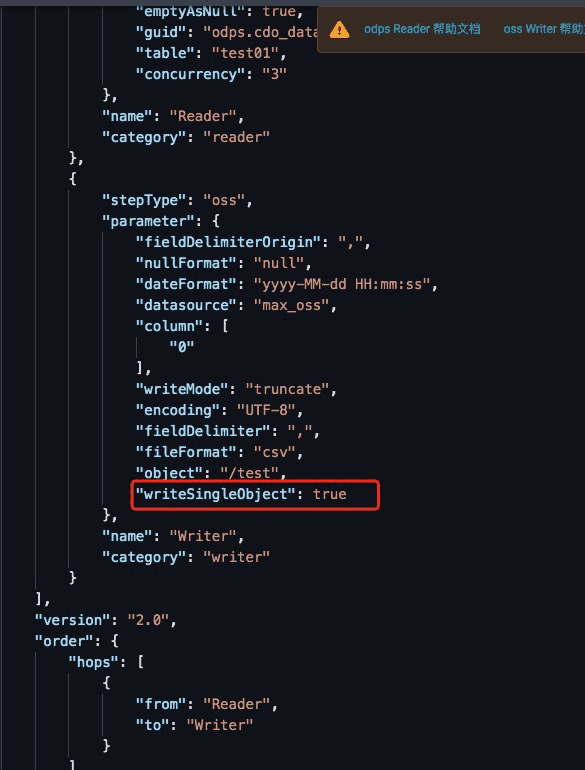

在脚本模式增加如下配置:"writeSingleObject": true

,此回答整理自钉群“DataWorks交流群(答疑@机器人)”

在 DataWorks 中,离线同步的 OSS 单文件大小上限为 10GB。如果需要同步的文件大小超过 10GB,可以考虑将文件拆分成多个小文件进行同步,或者使用其他方式处理大文件。

需要注意的是,文件大小上限可能会因为版本更新等原因发生变化,因此建议在使用前查看 DataWorks 的官方文档,以确保使用的功能是最新版本并且支持。

DataWorks基于MaxCompute/Hologres/EMR/CDP等大数据引擎,为数据仓库/数据湖/湖仓一体等解决方案提供统一的全链路大数据开发治理平台。