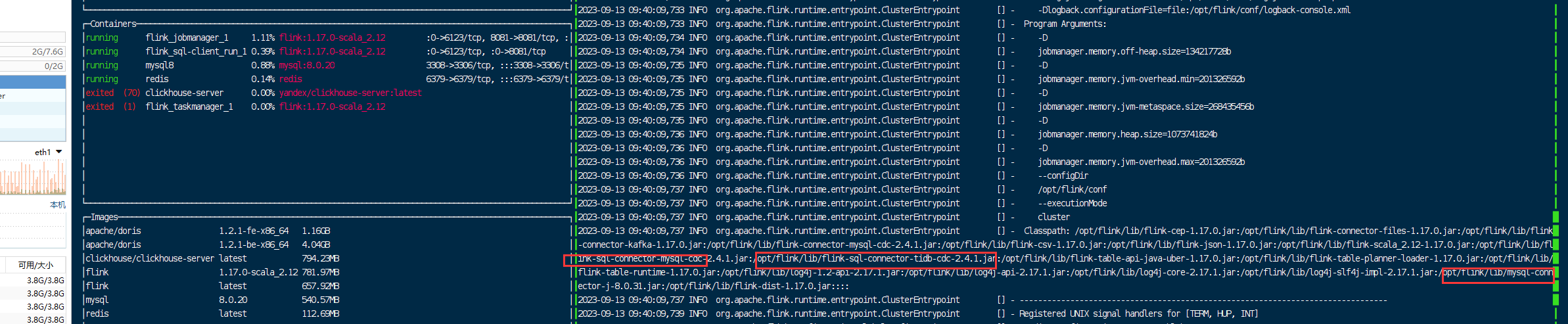

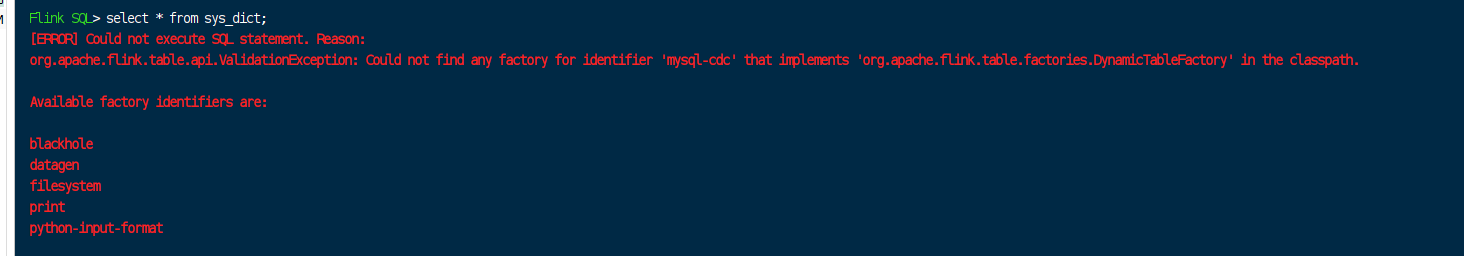

Flink CDC已经加了connector了为什么还报这个错?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在使用Flink CDC时,即使已经添加了Connector,仍然可能遇到报错。以下是可能导致问题的原因及解决方案:

报错示例:

Encountered change event for table xxx.xxx whose schema isn't known to this connector

原因分析: - 当前使用的数据库用户缺少对某些表的访问权限,导致CDC无法正确读取表结构或数据。 - 如果配置了'debezium.snapshot.mode'='never',CDC会尝试从Binlog开头读取数据,但此时表结构可能与当前Schema不匹配。

解决方案: 1. 确保数据库用户拥有作业中所有表的SELECT、REPLICATION SLAVE和REPLICATION CLIENT权限。 2. 避免使用'debezium.snapshot.mode'='never',建议改为默认的快照模式(如initial)。 3. 如果需要忽略Schema不一致的问题,可以设置参数:

'debezium.inconsistent.schema.handling.mode' = 'warn'

报错示例:

The connector is trying to read binlog starting at GTIDs ..., but this is no longer available on the server

原因分析: - MySQL服务器上的Binlog文件已被清理,可能是由于Binlog保留时间过短或存储空间不足。 - 如果是阿里云RDS MySQL,其默认策略为最长保留18小时或占用存储空间不超过30%,满足任一条件都会触发清理。

解决方案: 1. 增加Binlog的保留时间,例如设置为7天:

SHOW VARIABLES LIKE 'expire_logs_days';

SET GLOBAL expire_logs_days=7;

报错示例:

connector class not found

原因分析: - 内置Connector依赖未正确加载,可能是由于JAR包冲突或缺失。 - 本地运行时,IDEA可能未正确加载MySQL CDC相关的依赖。

解决方案: 1. 确保Flink作业的pom.xml文件中已正确引入Connector依赖,并将不必要的依赖(如Flink核心库)设置为provided:

<dependency>

<groupId>com.ververica</groupId>

<artifactId>flink-connector-mysql-cdc</artifactId>

<version>${cdc.version}</version>

</dependency>

mvn dependency:tree检查是否存在依赖冲突,并移除重复或冲突的依赖。报错示例:

Can't find any matched tables, please check your configured database-name: xxx and table-name: xxxx

原因分析: - 全量阶段发生表结构变更(如新增列),可能导致CDC无法正确同步数据。 - 如果表名或数据库名配置错误,也会出现类似报错。

解决方案: 1. 检查配置的表名是否正确,确保表存在于目标数据库中。 2. 如果全量阶段发生表结构变更,需停止作业并删除下游表,然后重新无状态启动作业。 3. 避免在同步过程中进行不兼容的表结构变更(如删除主键)。

报错示例:

EventDataDeserializationException: Failed to deserialize data of EventHeaderV4

原因分析: - Debezium无法解析某些特定的SQL变更事件,例如DEFAULT (now())等复杂表达式。

解决方案: 1. 查看日志中的io.debezium.connector.mysql.MySqlSchema WARN信息,定位具体无法解析的变更。 2. 根据日志提示调整表结构或SQL语句,避免使用Debezium不支持的语法。

报错示例:

timeout expired while fetching topic metadata

原因分析: - Flink与MySQL之间的网络不通,可能是由于VPC配置错误或白名单未正确设置。

解决方案: 1. 在Flink控制台测试网络连通性,确保上下游服务与Flink工作空间在同一VPC下。 2. 检查MySQL服务是否已将Flink所在IP地址加入白名单。 3. 调大连接超时时间,例如:

'connect.timeout' = '60s'

希望以上内容能帮助您快速解决问题!

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。