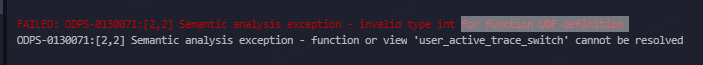

用scala编写udf函数,报错如上图,这个是因为啥原因能,dataworks上udf编写不支持scala吗

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

这个错误与Scala编程语言本身无关,而是由于您在DataWorks中编写UDF时可能存在一些语法或配置错误。

请注意,DataWorks支持使用Scala编写UDF函数。因此,问题可能出在您的代码中。

错误信息中的"Semantic analysis exception"表示语义分析异常,而"0DP5-0130071"和"0DPS-0130071"是具体的错误代码和位置信息。

根据错误信息中的提示,函数'user -activetrace_switch'无法解析。这可能是因为该函数在您的代码中未正确声明或定义,或者该函数名称不正确。

根据您提供的信息,我无法确定具体的错误原因。但是,通常情况下,UDF函数编写不支持Scala语言的原因可能是因为UDF函数需要使用Java或Python等其他编程语言来编写。

如果您需要在DataWorks上使用Scala编写UDF函数,您可以尝试使用Spark SQL中的自定义函数(User Defined Function,简称UDF)来实现。自定义函数可以使用Scala语言编写,并且可以在Spark SQL中使用。

以下是一个简单的示例代码,演示如何在Spark SQL中使用Scala编写UDF函数:

import org.apache.spark.sql.functions.udf

// 定义一个UDF函数,将字符串转换为大写形式

val toUpperCase = udf((input: String) => input.toUpperCase)

// 创建一个DataFrame,包含一列名为"name"的字符串数据

val df = spark.createDataFrame(Seq(("Alice",), ("Bob",), ("Charlie",))).toDF("name")

// 使用UDF函数将"name"列中的字符串转换为大写形式

df.withColumn("name_uppercase", toUpperCase($"name")).show()

上述代码中,我们首先导入了org.apache.spark.sql.functions.udf包,该包提供了用于创建UDF函数的工具。然后,我们定义了一个名为toUpperCase的UDF函数,该函数接受一个字符串作为输入,并返回该字符串的大写形式。接下来,我们创建了一个包含一列名为"name"的DataFrame,并使用withColumn方法将UDF函数应用于该列,将每个字符串转换为大写形式。最后,我们使用show方法显示转换后的DataFrame。

请注意,以上只是一个简单的示例代码,您可以根据您的实际需求进行修改和扩展。另外,确保在编写UDF函数时遵循正确的语法和规范,以避免出现错误。

DataWorks基于MaxCompute/Hologres/EMR/CDP等大数据引擎,为数据仓库/数据湖/湖仓一体等解决方案提供统一的全链路大数据开发治理平台。