如何调度DLA Spark 任务DataWorks?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

可以按照以下步骤进行操作:

创建DLA Spark任务:在DataWorks中,首先需要创建一个DLA Spark任务。在任务编排中心或类似的界面,选择创建任务,并选择DLA Spark作为任务类型。配置任务的相关参数,包括任务名称、输入输出表、代码逻辑等。

配置调度参数:在DLA Spark任务的配置中,您可以设置调度参数来定义任务的调度时间和频率。例如,您可以设置任务每天运行一次,或者每小时运行一次。您可以选择在DataWorks中配置调度参数,也可以选择使用外部调度工具(如MaxCompute Scheduler)来触发DLA Spark任务的运行。

保存并发布任务:在完成DLA Spark任务的配置后,保存并发布任务。确保任务的配置和代码逻辑都已正确设置和验证。

执行调度:根据您选择的调度方式,等待到达任务的调度时间点。根据调度参数配置,任务将自动触发并执行。DataWorks会自动分配资源并运行DLA Spark任务。

监控和日志:一旦DLA Spark任务开始执行,您可以在DataWorks的任务监控界面中查看任务的运行状态和日志。您可以检查任务的执行情况、运行时间、资源使用情况等。

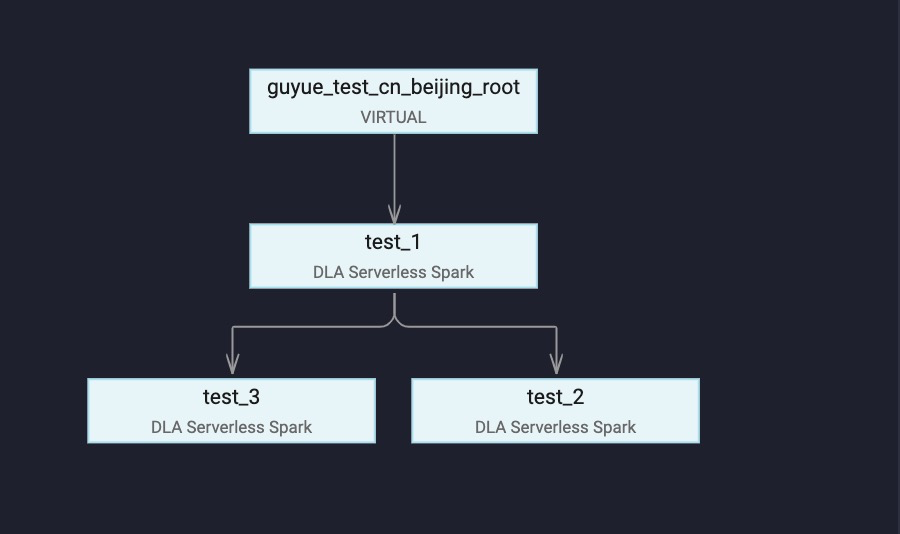

DataWorks是用于工作流可视化开发和托管调度运维的海量数据离线加工分析平台,支持按照时间和依赖关系的任务全面托管调度。任务调度中一个重要的功能是任务之间的依赖,为演示这个功能,本文会在DataWorks中创建三个DLA Spark任务, 任务之间的依赖关系如下图所示,任务test_2和 test_3 依赖上游任务test_1完成之后,才能执行。

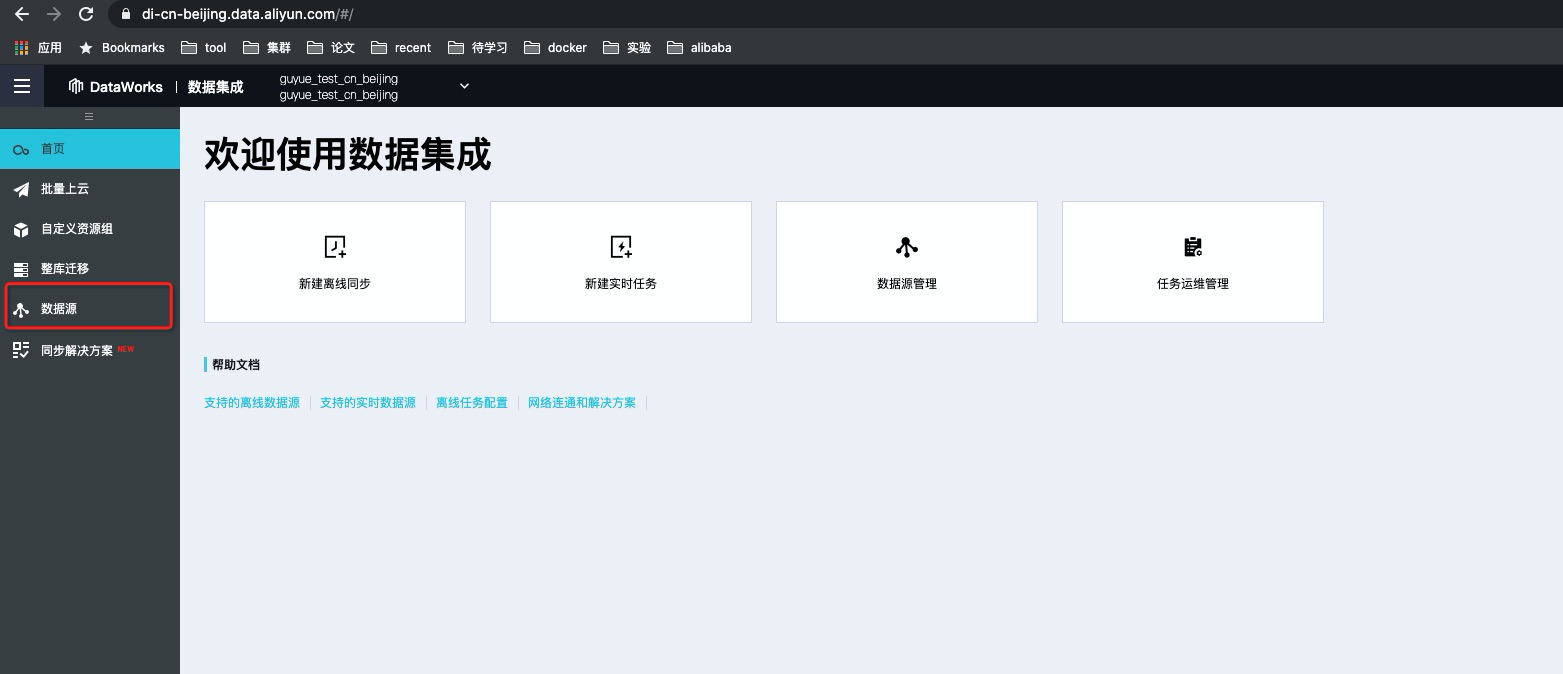

前提条件您已经开通DLA、DataWorks以及OSS服务,且DLA、DataWorks、OSS所属Region相同。在本文中三个服务所属Region均为华北2(北京)。创建DataWorks项目空间,详情请参见创建工作空间。说明如果您想用RAM子账号提交Spark作业,且之前未使用过子账号在DLA控制台提交作业,您可以参见细粒度配置RAM子账号权限进行子账号提交作业配置。DataWorks调度DLA Serverless Spark尚未全面开放,开通请联系DLA Spark答疑 钉钉号:dgw-jk1ia6xzp操作步骤在DataWorks中添加OSS数据源。登录DataWorks控制台单击对应项目栏中的进入数据集成,然后单击数据源按钮。

单击页面右上角新增数据源按钮,数据源选择OSS。

按照页面要求依次填写OSS信息,由于提交Spark作业需要用户的AccessKey ID 和 AccessKey Secret,您可以通过OSS数据源来获取这个信息。 注意不需要测试联通性,填完后单击右下角完成即可。

参数配置说明如下:数据源名称 为数据源指定一个名字,便与后续管理。

数

https://help.aliyun.com/document_detail/188048.html,此回答整理自钉群“DataWorks交流群(答疑@机器人)”

DataWorks基于MaxCompute/Hologres/EMR/CDP等大数据引擎,为数据仓库/数据湖/湖仓一体等解决方案提供统一的全链路大数据开发治理平台。