flink 的kafkaSink 如果我kafka突然宕机了 那没有发送成功的数据 flink的kafkaSink是怎么处理的。过期丢弃了还是怎么?kafka 宕机不会引起程序挂掉,所以上游发了数据 程序没有报错停止,但是kafka停了发不出去,直到kafka 恢复 这个数据是怎么处理的,会一直刷失去连接但是不会报错

我跑了10分钟,重连确实不会导致任务失败,发送数据失败会引起任务失败

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在 Flink 中,Kafka Sink 在发送数据时,默认会启用异步线程池来提高发送效率。如果 Kafka 突然宕机,异步线程池中的数据可能无法发送成功,这时需要考虑如何处理发送失败的数据。

Flink 的 Kafka Sink 提供了两种处理发送失败数据的方式:

抛出异常:在默认情况下,如果 Kafka 发送失败,Kafka Sink 会抛出异常。您可以通过捕获异常并处理来处理发送失败的数据。

重试发送:您可以通过设置 FlinkKafkaProducer 的 retries 参数来设置发送失败后的重试次数。当发送失败时,Kafka Sink 会自动进行重试,直到达到最大重试次数。您可以通过设置合适的重试次数和重试间隔,来提高发送成功率。

需要注意的是,如果您启用了重试机制,可能会导致数据重复发送,特别是在 Kafka 宕机后重新启动时。为了避免数据重复发送,您可以考虑在 Flink 中使用 Exactly-Once 语义来保证数据的一致性。具体来说,可以使用 Flink 的状态后端来保存已经发送过的数据的状态,从而避免数据重复发送。

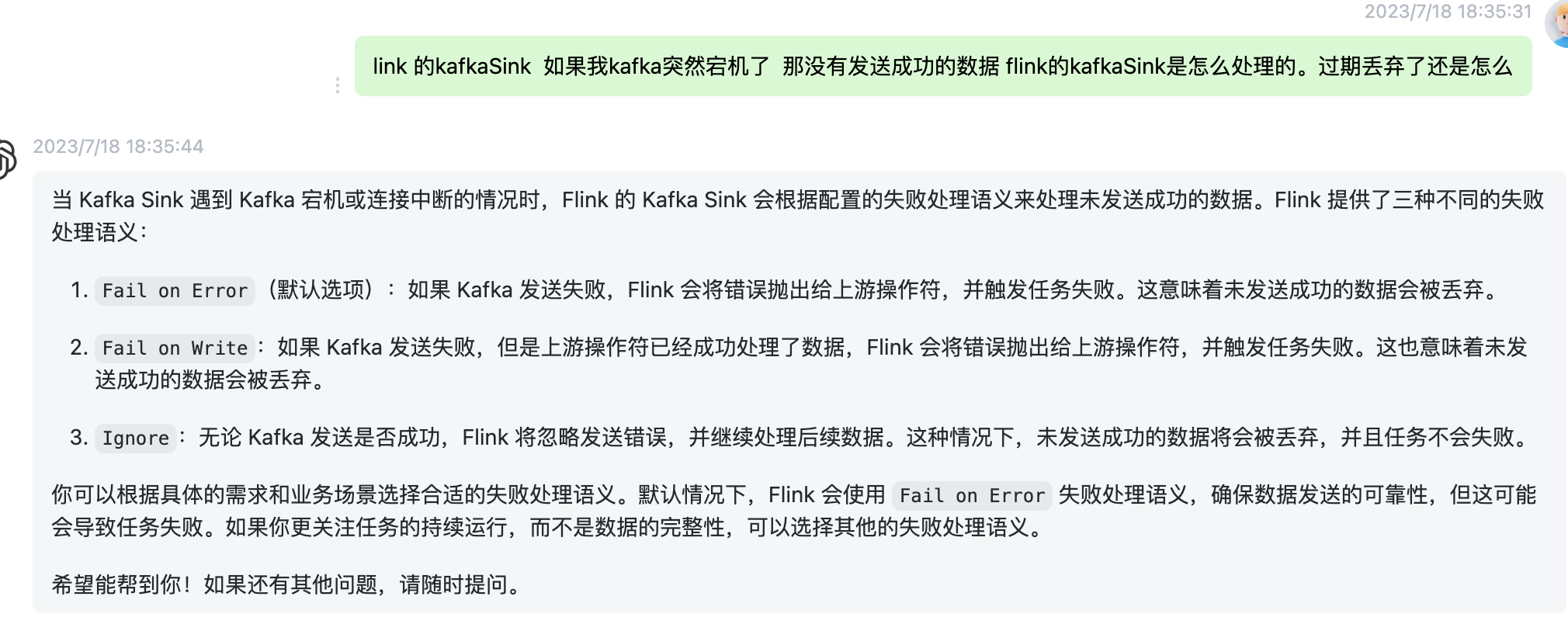

当 Flink 的 KafkaSink 在发送数据时,如果 Kafka 突然宕机,尚未成功发送的数据将由 KafkaSink 进行处理。具体处理方式取决于 KafkaSink 的配置和 Flink 作业的设置。

默认情况下,KafkaSink 使用 Kafka 生产者的 acks 属性设置为 "all",也就是要求所有副本都成功写入数据才会被视为发送成功。如果在发送过程中出现宕机或网络故障等异常情况,Kafka 生产者会自动进行重试,并且会保持连接直到 Kafka 恢复正常运行。这意味着,在 Kafka 宕机期间,Flink 作业将会阻塞等待 Kafka 恢复,以确保数据能够成功发送。

如果您希望在 Kafka 宕机期间对未发送的数据进行一些特殊处理(例如丢弃、缓存或记录错误信息),可以使用 Flink 的容错机制和用户定义的函数来实现。通过编写自定义的 SinkFunction 或 ProcessFunction,您可以在发送失败时捕获异常、记录日志或执行特定的逻辑来处理未发送的数据。

需要注意的是,如果 Kafka 宕机时间较长,可能会导致 Flink 作业的状态后端积压过多的未确认数据,从而影响作业的性能和稳定性。在这种情况下,您可以调整 Kafka 的配置参数,如 request.timeout.ms 和 max.in.flight.requests.per.connection,来适应宕机和恢复的时间窗口。

总结而言,Flink 的 KafkaSink 会自动处理在 Kafka 宕机期间未发送成功的数据,并在 Kafka 恢复正常后继续发送。您可以通过自定义函数来实现对未发送数据的特殊处理需求,并注意调整相关参数以保证作业的性能和稳定性。

两阶段提交协议,ack确认,这条数据的在kafka的偏移量已经是提交不成功的,连接超时了不报错嘛??kafka在一直尝试连接

,此回答整理自钉群“【③群】Apache Flink China社区”

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。