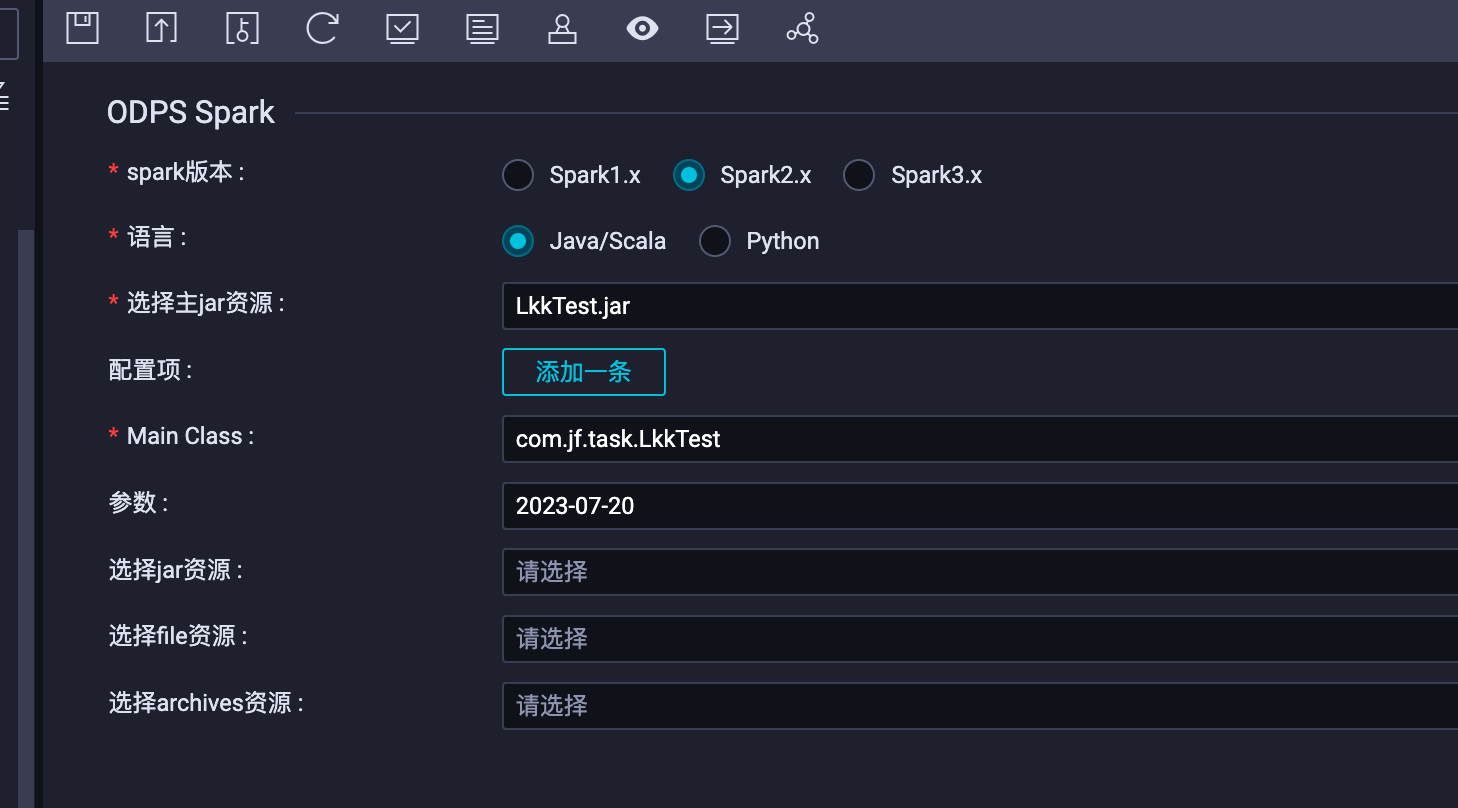

DataWorks这个页面的spark3.x选上之后就有问题?

DataWorks这个页面的spark3.x选上之后就有问题?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

-

北京阿里云ACE会长

作为一个 AI 模型,我无法确定您指的是 DataWorks 控制台中的哪个页面。但是,如果您在 DataWorks 控制台中选择了 Spark3.x,可能会出现以下几种常见问题:

环境问题:Spark3.x 相比 Spark2.x 版本需要更高版本的 Java 和 Scala 环境支持,如果您的集群环境不符合要求,可能会导致任务无法正常运行。

API 兼容性问题:Spark3.x 版本和 Spark2.x 版本在某些 API 和功能上有所不同,如果您的代码中使用了不兼容的 API 或功能,可能会导致任务无法正常运行。

资源配置问题:Spark3.x 版本相比 Spark2.x 版本需要更高的资源要求,需要更多的内存和 CPU 资源来支持,如果您的集群资源不足,可能会影响任务的运行效率和稳定性。

2023-07-30 16:03:02赞同 展开评论 -

如果在DataWorks中启用了Spark 3.x版本后出现问题,可能是由于以下一些原因导致:

兼容性问题:Spark 3.x与之前的版本(如Spark 2.x)存在一些不兼容的变化。这意味着你的作业代码、配置或数据处理逻辑可能需要进行相应的调整才能适配Spark 3.x。例如,一些API、参数或函数的变化可能会导致您的代码无法正常执行。

配置问题:Spark 3.x版本可能需要不同的配置参数或资源分配策略。如果你的集群和作业配置没有正确调整,可能导致资源利用不当、性能下降或作业失败等问题。

依赖库问题:Spark 3.x版本可能依赖于不同的第三方库或版本。如果你的作业使用了某些特定的库,但这些库在Spark 3.x中不再受支持或存在兼容性问题,可能会导致作业无法正常运行。

解决这些问题的方法包括:

检查代码兼容性:仔细检查你的Spark作业代码,确保它能够适应Spark 3.x的变化。查看Spark官方文档或升级指南,了解与之前版本的差异,并做出相应的修改。

调整配置参数:根据Spark 3.x的要求,适当调整作业的配置参数和资源分配策略。确保集群和作业的配置与Spark 3.x兼容。

更新依赖库:检查你的作业所使用的第三方库,并确保它们与Spark 3.x兼容。如果有必要,更新这些库的版本以适应新的Spark版本。

2023-07-26 20:37:44赞同 展开评论 -

DataWorks基于MaxCompute/Hologres/EMR/CDP等大数据引擎,为数据仓库/数据湖/湖仓一体等解决方案提供统一的全链路大数据开发治理平台。