有知道为啥flink connector jdbc新开了个项目,在flink repo里面已经不包含了?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

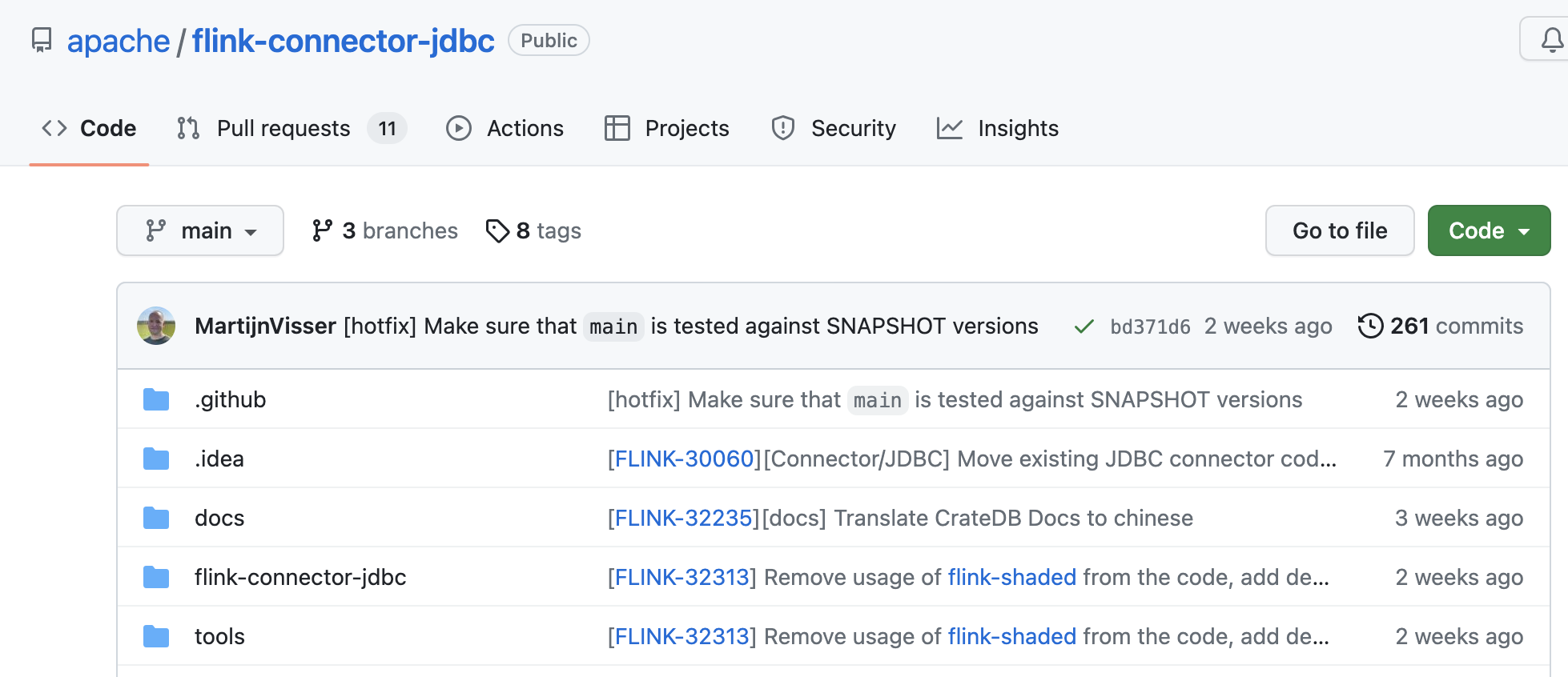

是的,Flink Connector JDBC 的代码已经从 Flink 项目中分离出来,成为了一个独立的项目,即 Flink JDBC Connector。这个项目的目标是将 JDBC 数据源集成到 Flink 的生态系统中,以便更方便地使用 JDBC 数据源进行批处理和流处理。

这个项目的分离是为了更好地管理和维护 Flink 的代码库,并使 Flink 的代码结构更加清晰和简洁。同时,这也使得 Flink JDBC Connector 可以独立地进行版本管理和发布,方便用户在使用时进行升级和维护。

现在,您可以在 Flink JDBC Connector 的官方仓库中找到该项目的代码和文档。如果您需要使用 Flink JDBC Connector,可以通过 Maven、Gradle 或者手动下载的方式将其集成到您的 Flink 应用程序中。

Flink Connector JDBC 从 Flink 1.13 版本开始被移动到了一个独立的仓库,而不再包含在 Flink 主仓库中。这个变化是为了更好地管理和维护连接器,并提供更灵活的版本发布。

将 Flink Connector JDBC 单独拆分为一个独立的项目有以下几个优点:

1. 独立的版本控制:连接器的开发和版本控制可以与 Flink 相互独立进行。这使得连接器的迭代和发布可以更加灵活,无需等待整个 Flink 发布周期。

2. 更容易参与贡献:将连接器作为一个独立项目,使得开发者更容易参与其中,并对连接器进行改进、修复和添加新功能。

3. 更好的模块化和可升级性:独立的连接器项目能够更好地实现模块化设计,使得可以更方便地添加其他数据库驱动程序支持或增强现有功能,同时也降低了对 Flink 主仓库的影响。

虽然 Flink Connector JDBC 被移动到了独立的项目仓库,但它仍然是 Flink 的官方连接器之一,并且与 Flink 主仓库保持紧密的合作。您可以通过访问 Flink Connector JDBC 项目的仓库,获取最新的版本、贡献代码或提出问题。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。