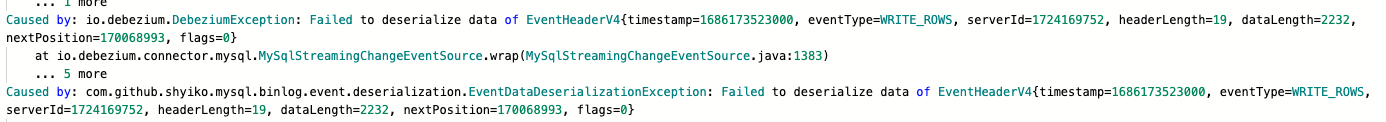

各位大佬有遇到Flink CDC这个报错的吗?问题发生在使用mysqlCDC消费阿里云RDS的时候,采用flinkcdc的StartupOptions.timestamp(timestamp)这种方式进行消费,目的是实时采集今日的数据

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您描述的问题,使用Flink CDC消费阿里云RDS MySQL时,采用StartupOptions.timestamp(timestamp)方式启动消费,目的是实时采集今日的数据。以下是针对该问题的详细分析和解决方案:

在使用StartupOptions.timestamp(timestamp)方式启动消费时,可能会遇到以下常见问题: - Binlog文件过期或不可用:如果指定的时间戳对应的Binlog文件已经被清理(例如,RDS MySQL默认的Binlog保留时间较短),会导致无法从指定时间戳开始消费。 - 时区不一致:Flink CDC解析Binlog中的timestamp字段时,依赖于作业中配置的server-time-zone参数。如果该参数与MySQL服务器的实际时区不一致,可能导致时间戳解析错误,进而影响消费逻辑。 - 只读实例限制:如果使用的是RDS MySQL的只读实例,其Binlog可能仅保留极短时间(如10秒),导致作业Failover后无法恢复消费。

确保MySQL服务器上的Binlog保留时间足够长,以覆盖您需要消费的时间范围。可以通过以下命令检查和调整Binlog保留时间:

-- 查看当前Binlog保留时间

SHOW VARIABLES LIKE 'expire_logs_days';

-- 设置Binlog保留时间为7天

SET GLOBAL expire_logs_days = 7;

注意:对于阿里云RDS MySQL,日志保留策略可能受存储空间限制(最长18小时或占用30%存储空间)。建议联系阿里云技术支持调整相关策略。

确保Flink CDC作业中配置的server-time-zone参数与MySQL服务器的实际时区一致。例如,如果MySQL服务器使用UTC+8时区,则需要在Flink作业中设置:

'server-time-zone' = 'Asia/Shanghai'

此外,如果您在DataStream作业中使用了自定义序列化器(如DebeziumDeserializationSchema),需要在解析timestamp字段时显式指定时区信息。可以参考RowDataDebeziumDeserializeSchema中的实现。

RDS MySQL的只读实例不保证Binlog的可用性,尤其是在Failover场景下。建议将Flink CDC源表配置为读取主实例数据,而不是只读实例。可以通过hostname区分实例类型: - rm开头的为主实例。 - rr开头的为只读实例。

在使用StartupOptions.timestamp(timestamp)时,确保指定的时间戳对应的数据仍然存在于Binlog中。如果时间戳过早,可能导致无法找到对应的Binlog文件。建议选择一个合理的时间戳,确保其对应的Binlog未被清理。

以下是一个完整的Flink CDC配置示例,用于从指定时间戳开始消费:

CREATE TABLE mysql_source (

id BIGINT,

name STRING,

update_time TIMESTAMP(3)

) WITH (

'connector' = 'mysql-cdc',

'hostname' = '<your-mysql-host>',

'port' = '3306',

'username' = '<your-username>',

'password' = '<your-password>',

'database-name' = '<your-database>',

'table-name' = '<your-table>',

'scan.startup.mode' = 'timestamp',

'scan.startup.timestamp-millis' = '<timestamp-in-millis>',

'server-time-zone' = 'Asia/Shanghai'

);

通过以上步骤,您可以有效解决Flink CDC消费阿里云RDS MySQL时遇到的问题。如果问题仍未解决,请提供更多具体的报错信息以便进一步分析。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。