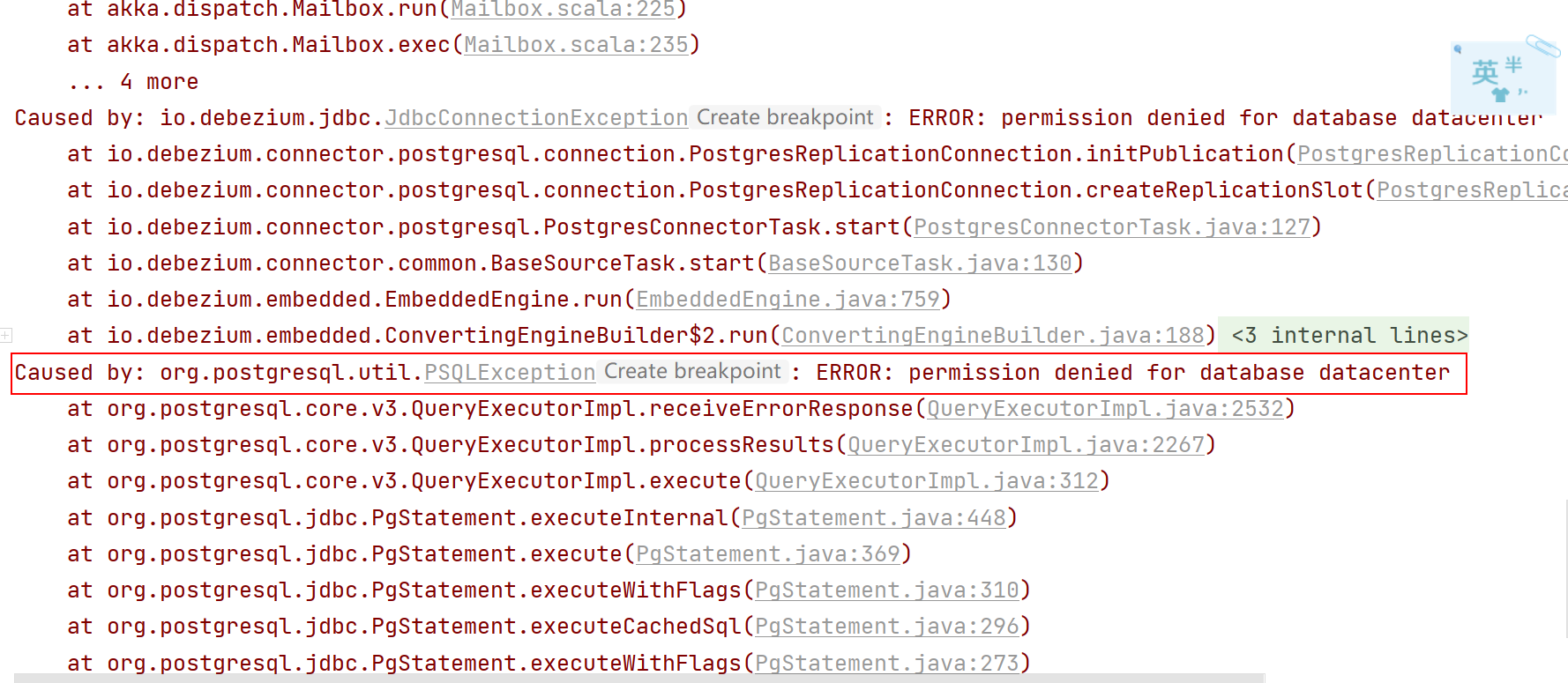

各位大佬,我本地在使用flinkcdc调试读取pg数据库的时候,报以下错误,请问这个有人遇到过吗,?

各位大佬,我本地在使用flinkcdc调试读取pg数据库的时候,报以下错误,请问这个有人遇到过吗,我的flink环境是1.13版本,pg是11.9版本,cdc是2.2版本?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您提供的错误信息以及知识库中的相关资料,以下是针对问题的详细解答:

1. 问题分析

您在使用 Flink CDC 调试读取 PostgreSQL 数据库时遇到报错。结合您的环境信息(Flink 1.13、PostgreSQL 11.9、Flink CDC 2.2),可能的原因包括以下几种: - 版本兼容性问题:Flink CDC 2.2 版本可能与 Flink 1.13 或 PostgreSQL 11.9 存在兼容性问题。 - 配置问题:PostgreSQL 的逻辑复制槽(Replication Slot)或相关参数未正确配置。 - 依赖冲突:Flink 环境中可能存在依赖冲突,导致运行时异常。

2. 解决方案

2.1 检查版本兼容性

Flink CDC 2.2 版本对 Flink 和 PostgreSQL 的版本有特定要求。建议您确认以下内容: - Flink 版本:Flink CDC 2.2 通常推荐使用 Flink 1.14 及以上版本。如果您的 Flink 版本为 1.13,可能会导致不兼容问题。 - PostgreSQL 版本:PostgreSQL 11.9 支持逻辑解码(Logical Decoding),但需要确保启用了相关插件(如 pgoutput 或 wal2json)。

建议操作: - 升级 Flink 至 1.14 或更高版本。 - 如果无法升级 Flink,尝试使用 Flink CDC 2.1 稳定版本(例如 flink-sql-connector-postgres-cdc-2.1.0.jar)。

2.2 配置 PostgreSQL 参数

PostgreSQL 的逻辑复制功能需要正确配置以下参数:

wal_level = logical

max_replication_slots = 10

max_wal_senders = 10

此外,确保逻辑复制槽(Replication Slot)已正确创建并处于可用状态。如果出现类似 Replication slot "xxxx" is active 的错误,可以手动释放或自动清理复制槽: - 手动释放:

SELECT pg_drop_replication_slot('rep_slot');

- 自动清理:在作业的 PostgreSQL Source 配置中添加以下参数:

'debezium.slot.drop.on.stop' = 'true'

2.3 检查依赖冲突

Flink 环境中可能存在依赖冲突,导致运行时异常。常见问题包括: - 类冲突:例如 java.lang.NoSuchMethodError 或 java.lang.ClassNotFoundException。 - 日志配置问题:可能导致日志不输出或 log4j 配置不生效。

建议操作: - 使用 flink-sql-connector-postgres-cdc-xxx.jar(FAT JAR),避免手动管理第三方依赖。 - 检查 Flink 的 lib 目录,确保没有重复或冲突的依赖包。 - 如果问题仍然存在,尝试使用 Blackhole 连接器进行调试,排除其他连接器配置问题。

2.4 验证配置文件

确保 Flink CDC 的配置文件中包含正确的参数。以下是一个示例配置:

'connector' = 'postgres-cdc',

'hostname' = '127.0.0.1',

'port' = '5432',

'username' = 'postgres',

'password' = '123456',

'database-name' = 'your_database',

'schema-name' = 'public',

'table-name' = 'your_table',

'decoding.plugin.name' = 'pgoutput',

'slot.name' = 'test_slot'

注意事项: - slot.name 必须唯一,避免与其他作业冲突。 - 如果使用 pgoutput 插件,确保 PostgreSQL 已启用逻辑解码。

3. 重要提醒

- PostgreSQL 备库限制:Flink CDC 2.4.0 及以下版本不支持同步 PostgreSQL 备库的数据,因为备库本身不支持读取增量数据。如果您正在尝试从备库读取数据,请切换至主库。

- 资源限制:如果作业启动失败并提示资源不足(如

exceeded quota: resourcequota),请检查工作空间的 CU 配置,并适当扩容或减少作业请求的资源。

4. 总结

通过上述步骤,您可以逐步排查并解决 Flink CDC 读取 PostgreSQL 数据库时的报错问题。如果问题仍未解决,请提供具体的错误日志,以便进一步分析。

希望以上内容对您有所帮助!