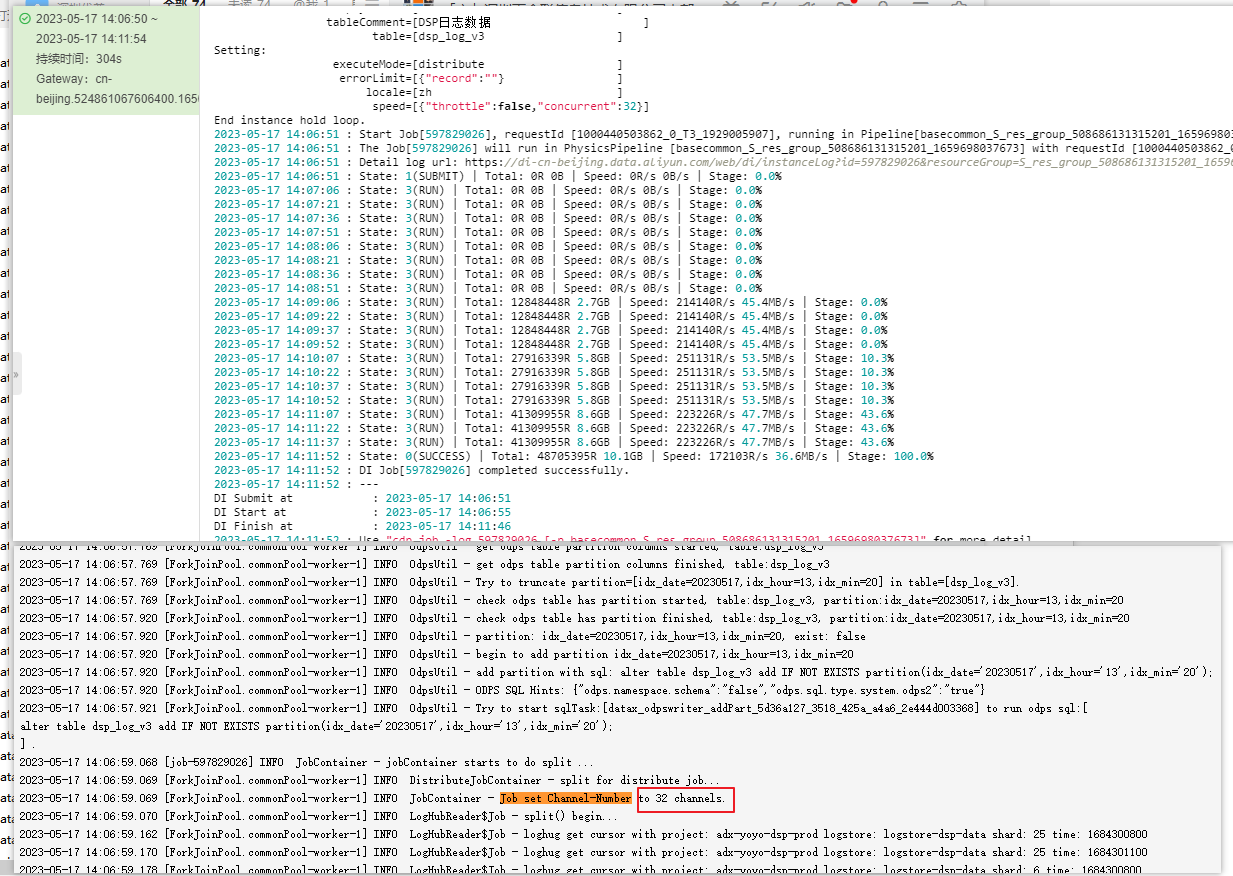

DataWorks离线同步节点现在已按32并发数来跑,每5分钟执行一次,现5分钟内拉不完从sls过来的日志 这种情况把独享集成资源扩容还有提升空间吗?(独享资源组规格8c16g,数量3)

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

从提供的信息来看,DataWorks离线同步节点目前每5分钟拉取来自sls的日志时已经按照32并发数来跑了,但是仍然不能在规定时间内完成任务。 在这种情况下,建议考虑以下方面来提高节点的性能:

调整并发数:尝试将并发数调整为更高的值以提高节点的性能。但是要注意,高并发数可能会影响其他节点的性能,因此需要进行实验来判断最佳的并发数。

扩容独享资源组: 如果当前节点仍未实现预期的性能,可以考虑为独享资源组添加更多的资源,比如增加CPU或内存。请注意,添加更多的资源可能会增加成本。

优化查询:审查查询是否可以重新设计来提高效率。优化查询可以减少资源使用和提高性能。

考虑使用云计算服务:考虑将数据迁移到云计算服务中,例如阿里云的MaxCompute、云数据库(RDS)等。这些服务可以为大规模数据处理提供更高效、更稳定的性能,并且可以根据需要进行横向/纵向扩展。

总之,在扩容独享资源组之前,需要先尝试优化节点的配置和查询,以确保性能得到最大化的提高。最终,如果无法通过优化解决性能问题,则可以考虑扩容独享资源组。

loghub和dw和mc是同主账号且同地域的吗 目前看任务已经开启了分布式 切配置了32并发 每个task读的数据量也比较均匀 当前资源组最大可支持48并发(不运行其他任务的情况下)目前只能建议再加些并发观察下 数据量比较大。,此回答整理自钉群“DataWorks交流群(答疑@机器人)”

DataWorks基于MaxCompute/Hologres/EMR/CDP等大数据引擎,为数据仓库/数据湖/湖仓一体等解决方案提供统一的全链路大数据开发治理平台。