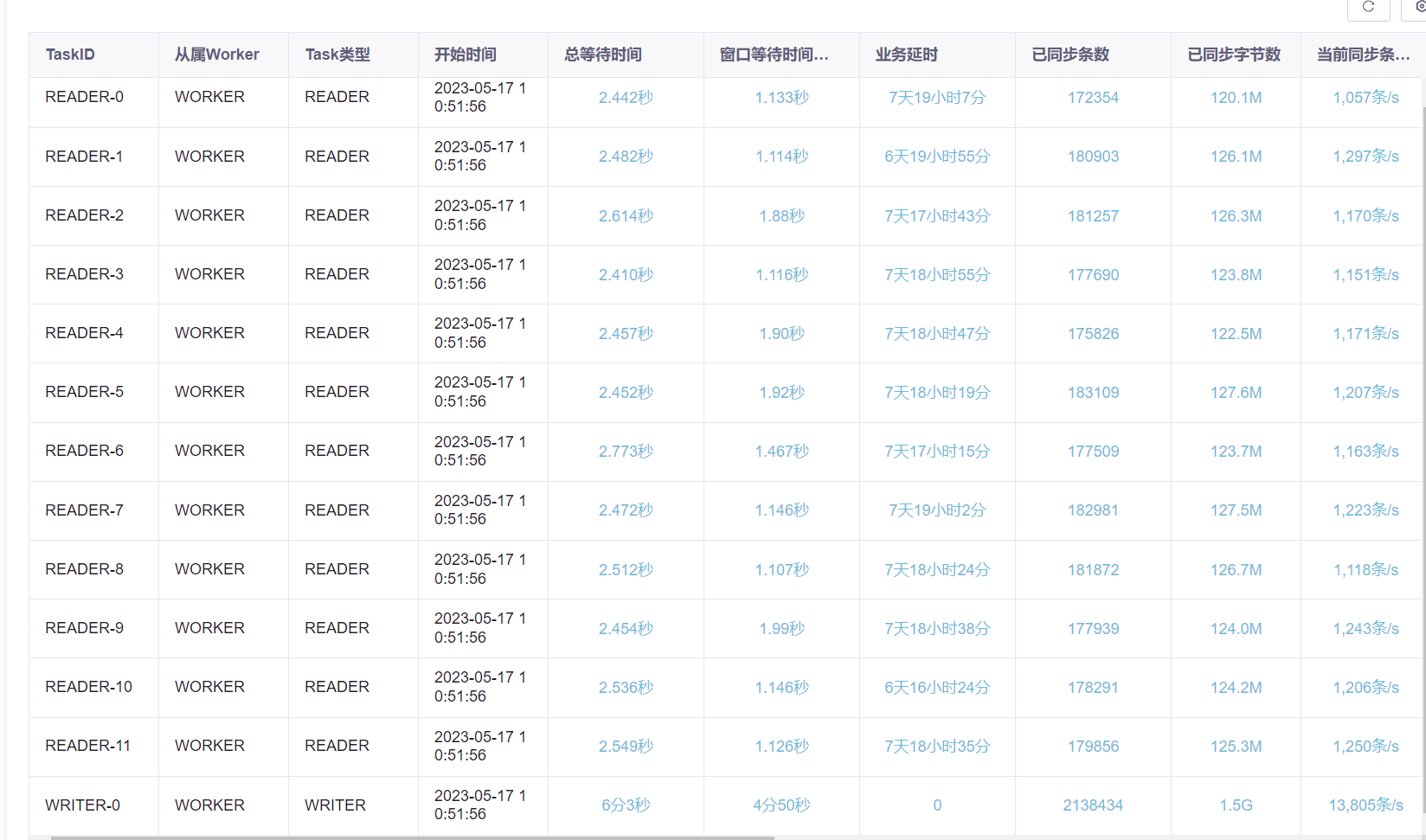

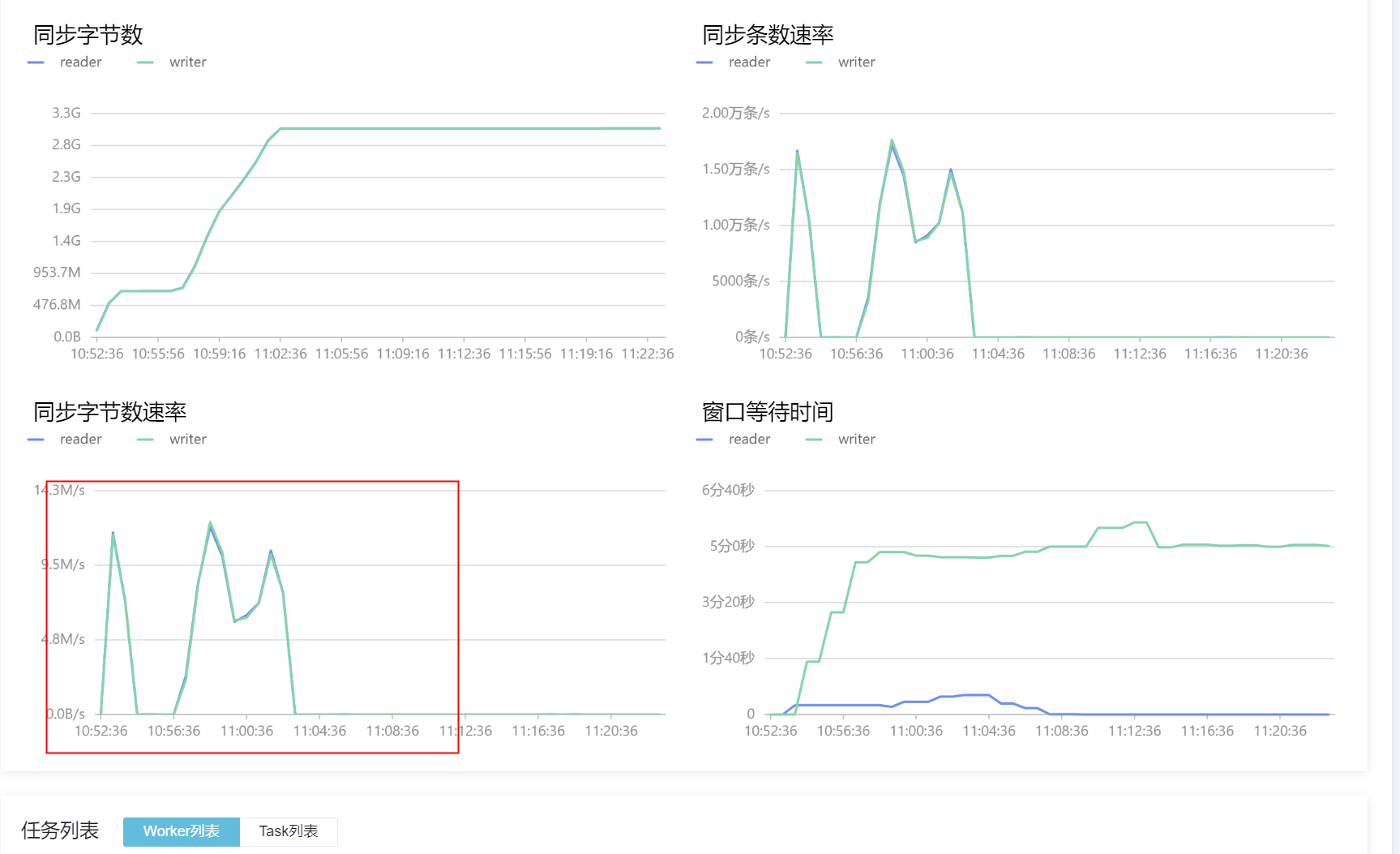

DataWorks中我感觉就是那个任务有啥问题,我重新建立了一个其他项目也是差不多一样的内容,数据量还要大上10倍,也是小时分区,你看看这速度,这个几千条每秒,那个两三条每秒? 问题2:这个新的也降下来了,这明显像是被限制了的感觉呀,感觉就像是同步了多少后就限制了,第二天再恢复

问题2:这个新的也降下来了,这明显像是被限制了的感觉呀,感觉就像是同步了多少后就限制了,第二天再恢复

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

嗯,根据你提供的信息,我可以来分析一下这两个问题。

问题1:

首先,DataWorks任务的执行速度可能会受到多种因素的影响。其中一个比较常见的因素是任务执行所需的资源是否够充足,例如CPU、内存、磁盘等资源。你可以检查一下任务执行时机器的资源消耗情况,看看是否存在某个资源利用率过高的情况。此外,还有可能会受到网络带宽的限制,如果数据传输速度较慢,也会影响任务的执行速度。

另外,数据量大小和分区设置也会对任务执行速度产生一定影响。一般来说,数据量越大,任务执行就越耗时。但是,如果正确设置了分区,可以使任务执行更加高效。建议你可以根据实际情况,合理设置分区,以提高任务执行速度。

问题2:

这个问题可能是由于DataWorks系统限制导致的。DataWorks对于一些任务会有执行时间限制及资源限制,当任务执行超时或资源使用超限时,系统会进行限制。这个限制通常会在一段时间后解除,所以第二天恢复了也很正常。建议你可以在任务执行时注意观察任务的执行情况,特别是对于耗时较长的任务,可以根据系统提示进行适当调整,以避免被系统限制。

回答1:和任务本身数据的分布 数据量等有关 从日志看 确实是在频繁建分区和不断切换分区 回答2:同步任务不会主动做限制 影响速度的因素比较多 ,此回答整理自钉群“DataWorks交流群(答疑@机器人)”

DataWorks基于MaxCompute/Hologres/EMR/CDP等大数据引擎,为数据仓库/数据湖/湖仓一体等解决方案提供统一的全链路大数据开发治理平台。