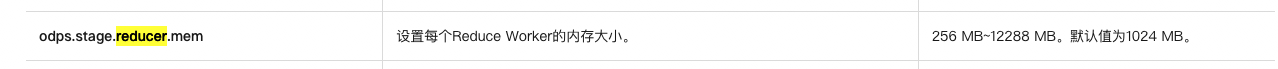

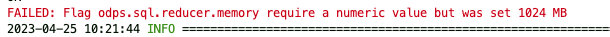

1.MaxCompute设置每个Reduce Worker的内存大小。我有32g数据,每个是1024,应该执行起来是32个左右的Reduce数量,odps.stage.reducer.mem:1024MB 这样设置?有参考案例吗?

所以还是1024 2.那我如何设置,让其自动reduce num的数量和数据集大小有一定的比例,比如1g数据大小一个reduce并发,手动设置不太合理

所以还是1024 2.那我如何设置,让其自动reduce num的数量和数据集大小有一定的比例,比如1g数据大小一个reduce并发,手动设置不太合理

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

1.我这边确认了下,odps.stage.reducer.mem这个参数和reduce端的并发没有关系,是单并发申请的内存。所以我理解log view上显示的并发数跟odps.stage.reducer.mem参数的设置没有关系 2. 这个底层是根据上游fuxi instance数量,及sql逻辑,自动划分并发数的,我理解是没办法设置,我问下。 此回答整理自钉群“MaxCompute开发者社区2群”

MaxCompute(原ODPS)是一项面向分析的大数据计算服务,它以Serverless架构提供快速、全托管的在线数据仓库服务,消除传统数据平台在资源扩展性和弹性方面的限制,最小化用户运维投入,使您经济并高效的分析处理海量数据。