Flink不走本地但是hdfs又不行,这种不是矛盾了吗?‘—C’ 指定的包必须是集群可以共享的,意思是这吗?所以 hdfs是可以共享的,但是它不支持hdfs 协议这个会有隐患吗?那像他们做的数据平台那种,就没有用hdfs管理jar的吗,不应该吧那他们是用什么方式的?我现在的想法是直接把URL拓展成支持hdfs协议的 这个更改默认的文件系统呢?

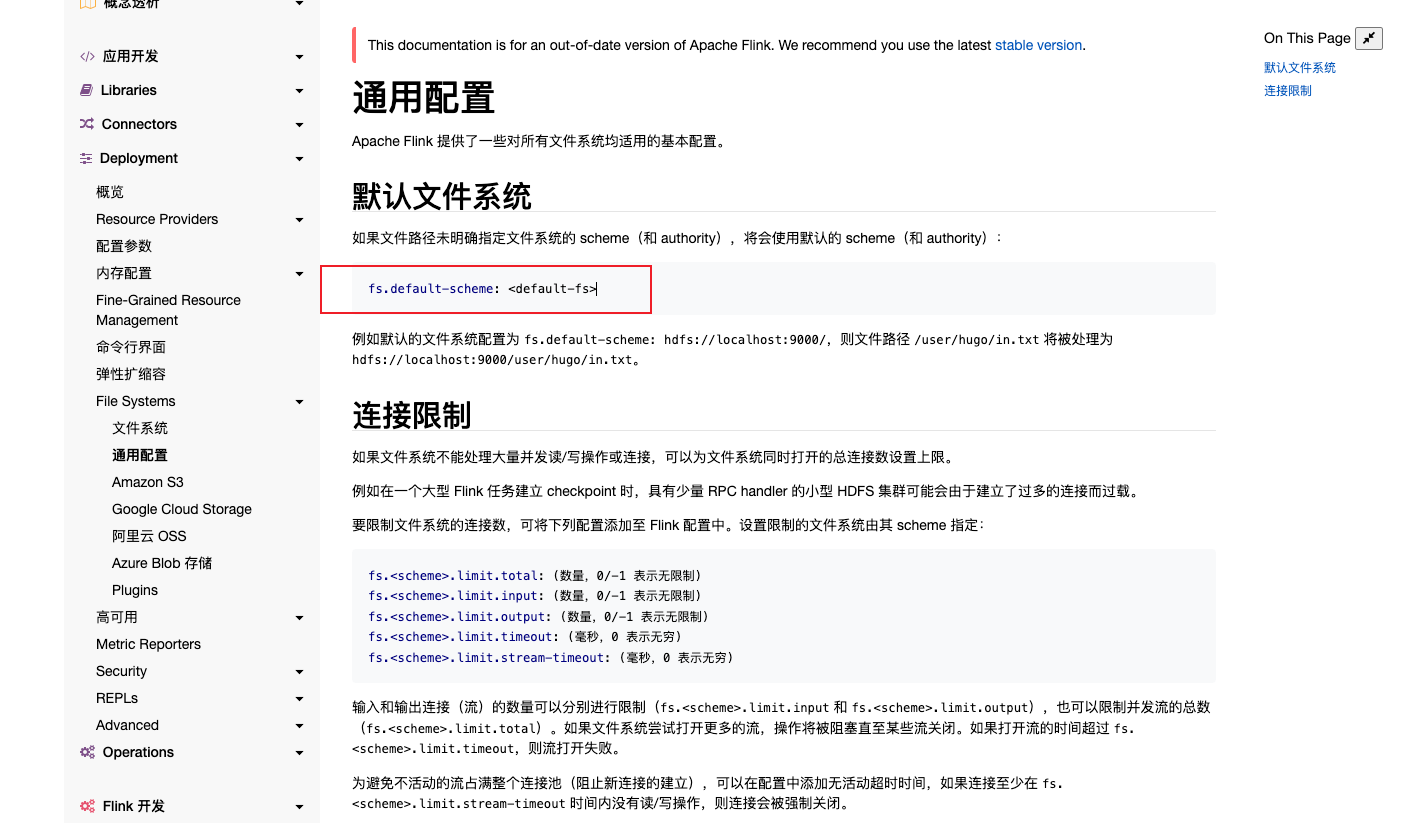

这个更改默认的文件系统呢?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

‘-C ’分发Task的时候会给远端用本地远端找不到依赖,‘-C ’其实就是做个maven私服,你可以改改用JVM系统属性支持 hdfsflink SPARK都没有这么搞应该是有原因的,Http凑合用吧。我瞅过没有用直接用hdfs加载依赖的,都是用hdfs中转。 别怂先直接把hdfs支持干上去,做个http文件服务器管理依赖也是可以的,直接拓展支持hdfs协议不难,G21这跟你依赖加载没关系此回答整理自钉群“【③群】Apache Flink China社区”

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。