Flink里ods是不是一般使用text方便后面加字段?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

txt在于方便看数据,不是方便加字段,加字段。修改字段多的表尽量用外部表,-- 新增经纬度字段center

-- 原表是外表的话直接删除 drop table ods_rs_basic_tbb_amap_area;

-- 重建 CREATE EXTERNAL TABLE ods_rs_basic_tbb_amap_area( ad_code string COMMENT '行政区码', area_name string COMMENT '标准城市', city_code string COMMENT '便准区号', center string COMMENT '经纬度', level string COMMENT '城市等级') COMMENT 'ods标准城市字典表' PARTITIONED BY ( event_week int, event_day string, event_hour string) ROW FORMAT SERDE 'org.apache.hadoop.hive.ql.io.parquet.serde.ParquetHiveSerDe' STORED AS INPUTFORMAT 'org.apache.hadoop.hive.ql.io.parquet.MapredParquetInputFormat' OUTPUTFORMAT 'org.apache.hadoop.hive.ql.io.parquet.MapredParquetOutputFormat' LOCATION 'hdfs://my-dw-cluster/hive/warehouse/ods.db/ods_rs_basic_tbb_amap_area' TBLPROPERTIES ( 'parquet.compression'='snappy') ;

--修复数据 MSCK REPAIR table ods_rs_basic_tbb_amap_area;

--确认下数据是否修复了 select * from ods_rs_basic_tbb_amap_area where event_day='20200522';  虽然这个图片有点偏激的过渡吹捧ORC文件格式,但是从任何角度而言,txt都不是最好的文件格式哟,更不会被一般使用在任何一层,只有不一般的情况下才会使用txt,此回答整理自钉群“【③群】Apache Flink China社区”

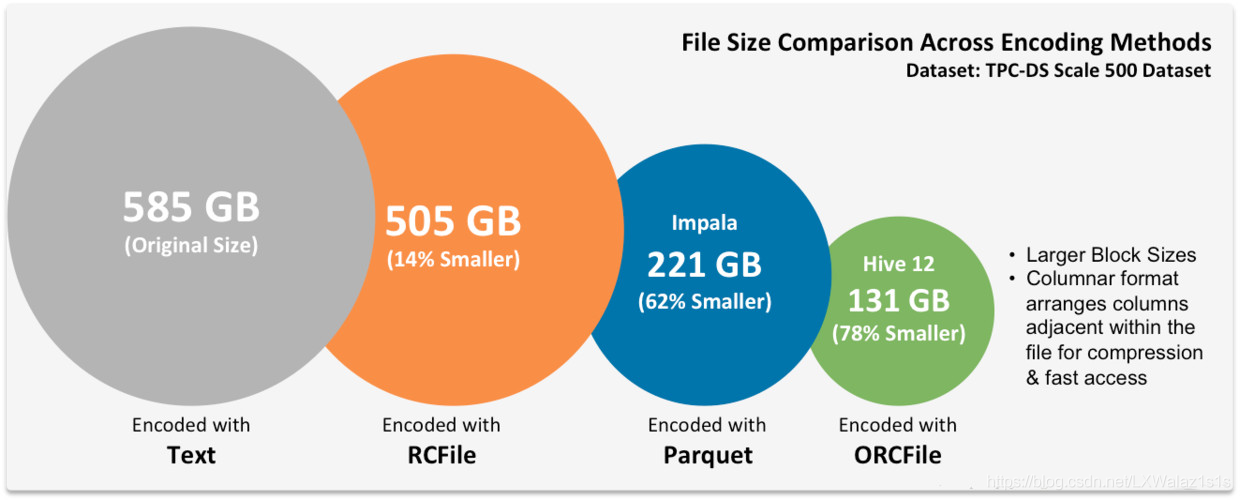

虽然这个图片有点偏激的过渡吹捧ORC文件格式,但是从任何角度而言,txt都不是最好的文件格式哟,更不会被一般使用在任何一层,只有不一般的情况下才会使用txt,此回答整理自钉群“【③群】Apache Flink China社区”

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。