dolphinscheduler安装节点上 hive使用都正常

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您提供的信息,您在DolphinScheduler安装节点上使用Hive时一切正常。这表明您的DolphinScheduler环境与Hive集成配置是正确的,并且能够顺利执行Hive相关任务。为了进一步利用这一配置或解决可能遇到的特定问题,以下是一些建议和确认点:

确保HiveCLI任务配置正确:

利用DolphinScheduler调度Spark作业结合Hive:

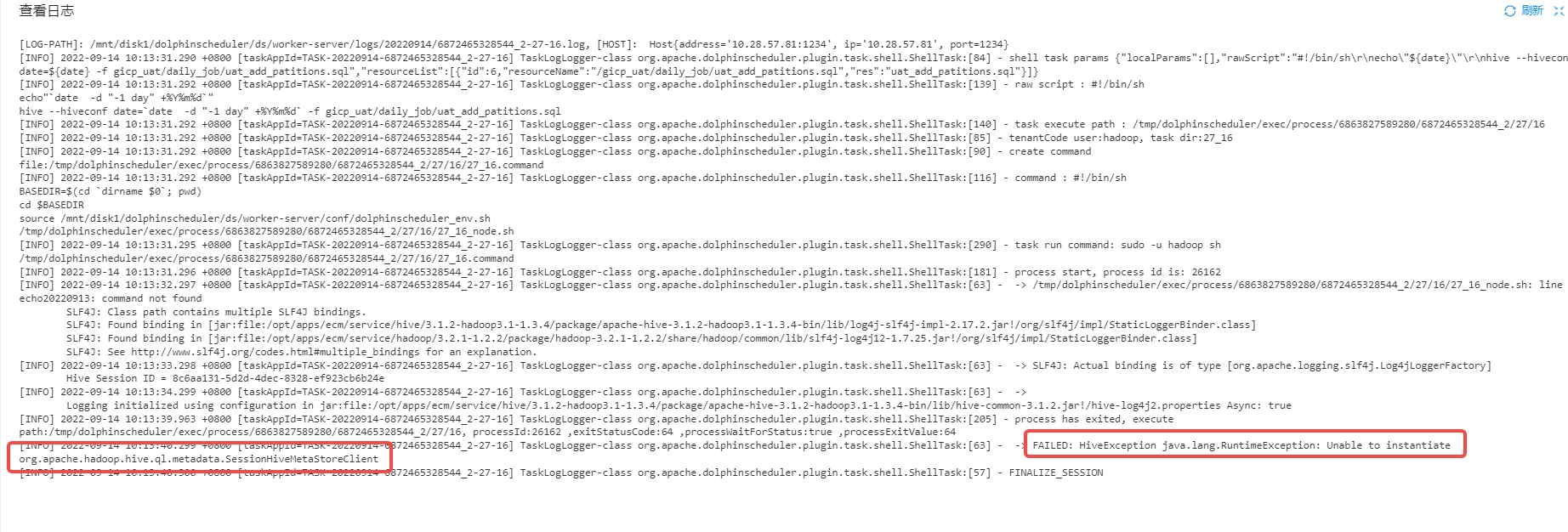

监控与日志分析:

性能与资源优化:

安全与权限管理:

综上所述,既然当前Hive使用正常,您可以继续深化其与DolphinScheduler的集成应用,通过细致的配置管理和适时的性能调优,实现更高效的数据处理流程。

阿里云EMR是云原生开源大数据平台,为客户提供简单易集成的Hadoop、Hive、Spark、Flink、Presto、ClickHouse、StarRocks、Delta、Hudi等开源大数据计算和存储引擎,计算资源可以根据业务的需要调整。EMR可以部署在阿里云公有云的ECS和ACK平台。