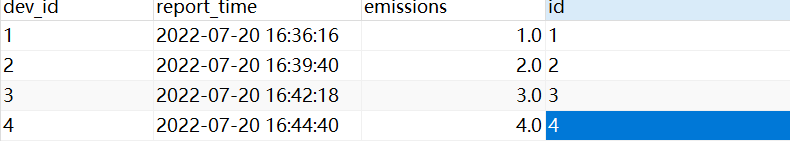

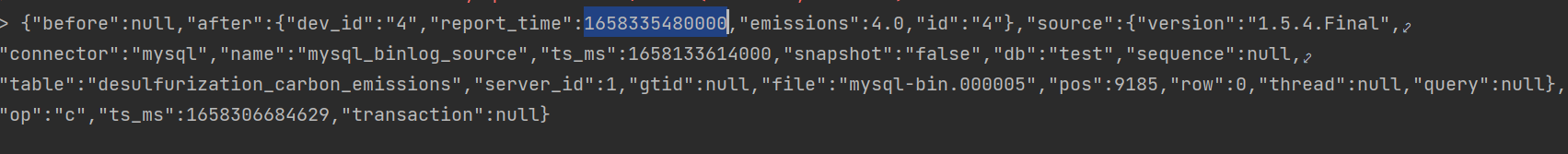

大佬们,问个问题,就是我数据库的字段是datetime类型,为啥flink cdc 获取到后打印出来的确是毫秒值呢??

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

您好!遇到这种情况,是因为Flink CDC在读取MySQL的datetime类型字段时,默认会将其转换为毫秒值表示的时间戳。这是因为内部处理时,为了统一和高效,很多系统(包括Flink)倾向于使用时间戳(通常是自1970年1月1日以来的毫秒数或微秒数)来表示时间点。

解决方案:

如果您希望在Flink中以datetime格式查看这些数据,而不是直接显示为毫秒值,您可以在数据处理管道中加入一步转换操作,将毫秒值转换回datetime格式。这里提供一个简单的示例说明如何进行转换:

使用Java API: 在您的Flink DataStream或Table API代码中,可以使用java.time包中的Instant和LocalDateTime类来进行转换。例如:

import java.time.Instant;

import java.time.LocalDateTime;

import java.time.ZoneId;

// 假设dataStream是包含毫秒时间戳的DataStream

DataStream<String> dataStream = ...;

DataStream<String> dateTimeDataStream = dataStream.map(new MapFunction<String, String>() {

@Override

public String map(String value) throws Exception {

long timestampMillis = Long.parseLong(value); // 假设字符串可以直接解析为Long类型

Instant instant = Instant.ofEpochMilli(timestampMillis);

LocalDateTime dateTime = LocalDateTime.ofInstant(instant, ZoneId.systemDefault());

return dateTime.toString(); // 或者按需格式化日期时间字符串

}

});

使用SQL DDL: 如果您是在使用Flink SQL处理数据,可以在创建表或者查询时指定时间戳的格式转换。例如,如果要从毫秒值转换为datetime格式并输出,可以在SELECT语句中使用TO_TIMESTAMP函数(具体函数名可能根据Flink版本有所不同,如FROM_UNIXTIME等),并指定相应的格式。

请根据您实际使用的API(DataStream API、Table API还是SQL)选择合适的方法进行转换。这样处理后,原本显示为毫秒值的时间数据就会以datetime格式展示出来。

记得调整时区设置以确保转换后的datetime与预期相符,特别是在跨时区应用中。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。