版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

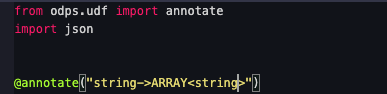

可以使用Flink的UDF函数来实现这个需求。具体步骤如下:

编写一个Java类,实现Flink的UDF接口。UDF接口有两个方法:evaluate和getFunctionSignature(),evaluate方法用于执行UDF函数,getFunctionSignature()方法用于返回UDF函数的参数类型和返回值类型。

将Java类打成jar包,并上传到Flink的classpath中。

在Flink的配置文件中配置UDF函数,例如:

{

"name": "my_udf",

"type": "class",

"class": "com.example.MyUDF",

"params": [

{

"name": "input",

"type": "string"

},

{

"name": "output",

"type": "array",

"elementType": "string"

}

]

}

其中,name表示UDF函数的名称,type表示UDF函数的类型,class表示UDF函数的类路径,params表示UDF函数的参数列表,input和output分别表示UDF函数的输入和输出参数。

在Flink的代码中使用UDF函数,例如:

DataStream<String> stream = ...;

DataStream<String[]> result = stream

.map(new MapFunction<String, String[]>() {

@Override

public String[] map(String value) throws Exception {

// 执行UDF函数

String[] result = myUDF(value);

return result;

}

})

.returns(Arrays.class);

// 输出结果

result.print();

其中,myUDF是UDF函数的名称,value是UDF函数的输入参数,result是UDF函数的输出结果。

需要注意的是,UDF函数的输入和输出参数类型需要与配置文件中的参数类型一致,否则会出现编译错误。另外,UDF函数的执行效率可能会受到限制,需要考虑优化。

DataWorks基于MaxCompute/Hologres/EMR/CDP等大数据引擎,为数据仓库/数据湖/湖仓一体等解决方案提供统一的全链路大数据开发治理平台。