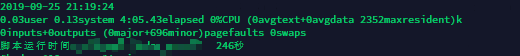

引擎是innodb,表无索,插入100万,脚本打出执行时间是4-5分钟,但是表中的创建时间是跟插入前的时间是一致的,为什么在4-5分钟才提交完全,难道是事务?不过才100万的数据不至于吧,求解惑 表中创建时间是跟最上面的打出的时间是一致的,但脚本显示246秒才完成

表中创建时间是跟最上面的打出的时间是一致的,但脚本显示246秒才完成

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在MySQL中,尤其是使用InnoDB存储引擎时,数据的插入操作默认是支持事务的。这意味着当你开始插入大量数据直到执行COMMIT命令之前,所有更改可能都处于一个未提交的事务中。即使数据实际上已经被写入到数据库(但未对外可见),表的元数据如“创建时间”不会因为数据的变动而更新,它通常指的是表结构创建的时间。

关于你提到的4-5分钟(即246秒)才完成插入操作,这可能是由以下几个因素导致的:

事务处理:如前所述,如果你的数据插入是在一个事务中进行的,那么直到事务提交前,所有的更改都不会对其他并发会话可见。这个过程包括了数据的写入、日志记录(如redo log和undo log)、以及最终的事务提交,这些步骤都需要时间,特别是对于大量的数据插入。

索引维护:虽然你说表无索引,但是InnoDB存储引擎有一个特殊的聚簇索引(Clustered Index),即主键索引。即使没有额外定义索引,每次插入数据时,InnoDB都会维护这个聚簇索引。当数据量大时,这种维护也会消耗时间。

锁竞争与并发控制:InnoDB使用行级锁来管理并发访问,但在大量数据插入时,即使是行锁也可能产生一定的开销,尤其是在高并发环境下。

磁盘I/O性能:数据的写入速度受限于磁盘的写入速度,特别是如果磁盘I/O成为瓶颈时,插入大量数据将显著变慢。

缓冲池与刷盘策略:InnoDB使用缓冲池(Buffer Pool)来缓存数据页,提高读写效率。数据可能先被写入缓冲池,然后根据配置的刷盘策略(如innodb_flush_log_at_trx_commit参数设置)逐步或立即刷到磁盘上。不同的配置会影响数据持久化的时间。

解决或优化这一问题的方法可能包括:

综上所述,尽管100万数据量对于现代系统来说可能不算巨大,但在特定条件下仍可能导致较长时间的插入延迟。