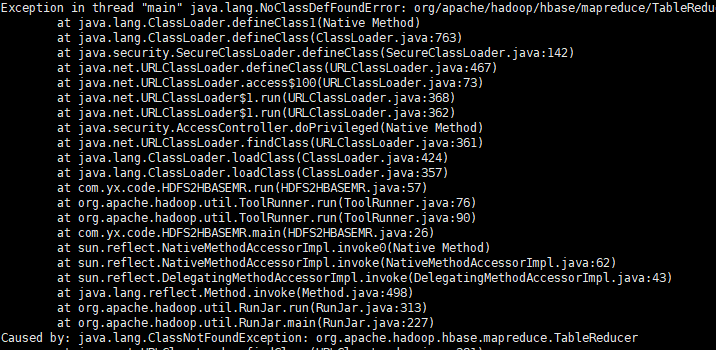

我想从HDFS导数据到Hbase中,但是我运行的MapReduce报错找不到TableReducer,我用的是cdh版本的。

请问这个有人遇到过么?

本问题来自阿里云开发者社区的【11大垂直技术领域开发者社群】。https://developer.aliyun.com/article/706511 点击链接欢迎加入感兴趣的技术领域群。

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

遇到从HDFS导入数据到HBase时,MapReduce作业报错找不到TableReducer的问题,这通常意味着你的作业中可能缺少了必要的类库引用,或者类路径设置不正确。在CDH(Cloudera Distribution including Apache Hadoop)环境下,确保你正确地配置了依赖和类路径尤其重要。

以下是一些排查和解决此问题的建议:

检查依赖: 确保你的项目或作业构建中包含了所有必要的HBase和Hadoop相关的依赖。对于使用Maven或Gradle等构建工具的项目,需要确认pom.xml或build.gradle文件中是否添加了正确的HBase客户端和MapReduce相关依赖。例如,对于Maven,你可能需要如下依赖:

<!-- HBase Client -->

<dependency>

<groupId>org.apache.hbase</groupId>

<artifactId>hbase-client</artifactId>

<version>${hbase.version}</version>

</dependency>

<!-- HBase MapReduce -->

<dependency>

<groupId>org.apache.hbase</groupId>

<artifactId>hbase-mapreduce</artifactId>

<version>${hbase.version}</version>

</dependency>

请替换${hbase.version}为你的HBase版本对应的版本号,并确保它与CDH集群中的HBase版本兼容。

Classpath问题: 如果你在运行MapReduce作业时直接通过命令行指定jar包,请确保-libjars参数包含了HBase的MapReduce jar和其他必要的库。例如:

hadoop jar your-job.jar your.main.class -libjars /path/to/hbase-mapreduce.jar,/path/to/other-dependency.jar ...

CDH特有配置: CDH环境可能有一些特定的配置要求或库路径。检查CDH的文档,看是否有特定于CDH的指导或注意事项,特别是关于如何在CDH环境中正确部署和执行MapReduce作业的信息。

版本兼容性: 确认你的HBase客户端版本与HBase服务器版本以及CDH的其他组件版本之间是兼容的。不同版本间的不兼容可能会导致各种奇怪的问题。

查看详细的错误日志: 查看MapReduce作业失败的具体错误信息和堆栈跟踪,这将提供更具体的线索。错误日志中可能会提到缺失的类名或库,根据这些信息进行针对性的修正。

环境变量和配置: 检查Hadoop和HBase的相关环境变量是否设置正确,以及hbase-site.xml、core-site.xml等配置文件是否被正确地包含在了你的作业环境中。

如果以上步骤不能解决问题,考虑在阿里云开发者社区或Cloudera的官方论坛上寻求帮助,提供尽可能多的错误信息和配置细节,以便获得更专业的支持。