请教大家一个问题,我写了一个sparkstreaming,做了一个checkpoint,但是首次启动总能成功,第二次启动就报错了,说某一个注册的临时维表找不到,我把checkpoint 目录内容删除掉,就又可以了?

这个是什么原因啊?

感觉 checkpoint 没有对 维度表生效

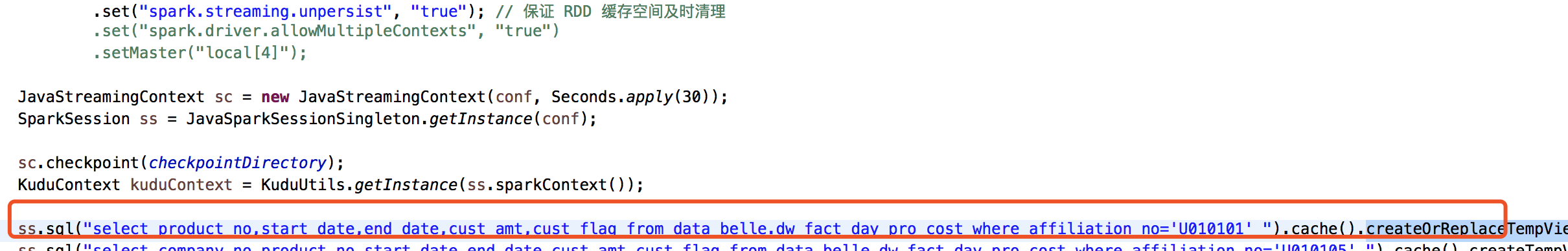

这种方式注册的临时表

这种方式注册的临时表

本问题来自阿里云开发者社区的【11大垂直技术领域开发者社群】。https://developer.aliyun.com/article/706511 点击链接欢迎加入感兴趣的技术领域群。

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在Spark Streaming中使用checkpoint机制时,确实可能会遇到一些与状态保存和恢复相关的挑战,尤其是当涉及到外部数据源(如临时维表)的注册时。根据您的描述,问题可能出在以下几个方面:

临时表未持久化: Spark checkpoint主要是为了保存Spark作业的元数据(比如DStream的偏移量、宽依赖的边界等)以及自定义的RDD或DataFrame/Dataset的快照,以便于故障恢复。但是,它不会自动保存或恢复那些通过代码动态创建的临时视图或者外部数据源的连接信息。您提到的“临时维表”如果是在每次应用启动时通过代码动态注册的,那么这些信息在checkpoint恢复时并不会被自动重新创建。

外部资源依赖: 如果这个“临时维表”是基于外部系统(如Hive Metastore、数据库或其他存储服务)的,那么在Spark作业重启后,需要确保该外部系统仍然可用,并且能够正确访问到之前注册的表。有时候,由于网络问题、权限变更或外部系统状态变化,可能导致第二次启动时找不到之前注册的表。

Checkpoint目录清理不彻底: 有时即使删除了checkpoint目录,某些隐藏文件或依赖的其他状态可能没有完全清除,导致恢复时出现问题。

解决办法建议如下:

显式管理临时表: 在Spark应用启动时,除了初始化checkpoint外,还应该确保所有必要的临时表或外部数据源都被重新注册。可以考虑将注册临时表的逻辑放在一个初始化方法中,每次应用启动时都调用此方法。

使用更稳定的外部存储: 如果可能,考虑将频繁查询的维表数据提前加载到更稳定、易于管理和恢复的存储中,比如BroadcastVariable或者直接缓存在Spark内存中,这样可以减少对外部系统的依赖。

检查并优化Checkpoint策略: 确认checkpoint的频率和位置设置是否合理,避免过于频繁的checkpoint导致资源竞争或状态混乱。同时,定期清理和验证checkpoint目录的内容。

日志分析: 查看Spark作业的日志,特别是第二次启动失败时的日志,寻找有关为何无法找到临时表的具体错误信息,这有助于定位问题所在。

希望这些建议能帮助您解决问题。如果还有其他技术细节需要探讨,欢迎继续提问。