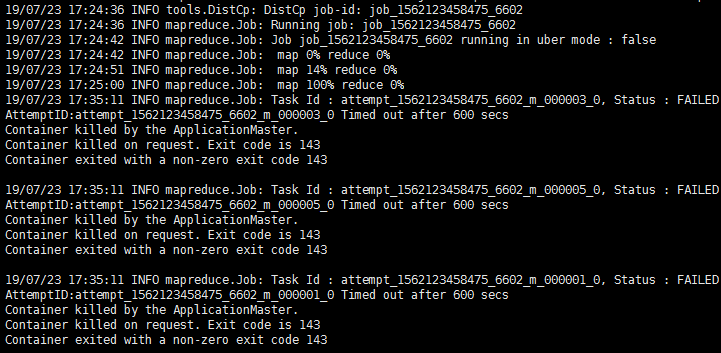

1.使用emrtool工具从本地集群hdfs迁移数据至oss。 2.迁移数据大小为1G。 3.迁移过程中遇到以下报错。

尝试修改hdfs2oss4emr.sh脚本配置 在启动项中 hadoop jar ${jar} org.apache.hadoop.tools.DistCp -Dfs.oss.core.dependency.cache.path=${dep_jar} -Dfs.oss.impl=com.aliyun.fs.oss.nat.NativeOssFileSystem -Djob.output.oss.redirect=false -Dmapreduce.job.user.classpath.first=true $queue $maps $1 $2

添加-Dmapreduce.mapreduce.task.timeout=1200000配置重试扔出现上述错误,小文件上传没问题,感觉是上传速率太慢超时,请问该如何修改。

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在使用emrtool工具迁移HDFS数据至OSS时遇到超时问题,尤其是大文件上传出现问题而小文件正常,这确实可能是由于上传速率慢导致的超时。您已经尝试通过增加任务超时时间-Dmapreduce.task.timeout来解决,但问题依旧存在。这里有一些建议您可以尝试:

调整DistCp参数以优化性能:

-Dmapreduce.job.maps=<number>,这里的<number>可以根据您的集群资源情况适当增加,以提高并发度。-Ddistcp.blocksize=<size>,默认情况下,DistCp会使用HDFS的块大小(通常为128MB或256MB),您可以尝试增加这个值,比如设置为256MB或更高,以减少需要创建的文件数量和元数据操作。优化网络传输配置:

修改OSS客户端缓冲区大小: 在DistCp命令中添加OSS客户端缓冲相关的配置,例如: -Dfs.oss.buffer.size=<size>,这里的<size>可以设为一个较大的值,如64MB或更大,以提高读写效率。

检查OSS限速设置: 登录阿里云控制台,检查目标OSS bucket是否有上传速度限制,如果有,根据需要适当调高或取消限制。

分批迁移: 如果单个大文件迁移始终有问题,考虑将大文件分割成多个小文件进行迁移,虽然这会增加一些额外的处理步骤,但可能会绕过当前的超时问题。

监控与日志分析: 详细查看DistCp运行的日志,特别是错误信息,可能会提供更具体的超时原因。同时,利用YARN或Hadoop的监控工具观察任务执行过程中的资源使用情况,以便进一步调优。

请尝试上述建议,并根据实际情况调整,希望能帮助您解决问题。