Wesky

已加入开发者社区466天

勋章

专家博主

专家博主

星级博主

星级博主

技术博主

技术博主

江湖新秀

江湖新秀

我关注的人

粉丝

游客vuktgflm6mahw

游客vuktgflm6mahw

游客emru3uumc2goi

游客emru3uumc2goi

游客4msgqv24w4yjs

游客4msgqv24w4yjs

skvzfwnnpimvo

skvzfwnnpimvo

by7bptp27tcqw

by7bptp27tcqw

yuzhang333

yuzhang333

钟懒懒

钟懒懒

鹤啸天

鹤啸天

1666323245468293

1666323245468293

1061038138621753

1061038138621753

游客uvxsepy2unp2g

游客uvxsepy2unp2g

游客ni4scqgfeatk4

游客ni4scqgfeatk4

技术能力

兴趣领域

擅长领域

技术认证

-

-

Apsara Clouder云原生专项技能认证:函数计算入门和实战

获得于2023-02-01 16:29:12

Apsara Clouder云原生专项技能认证:函数计算入门和实战

获得于2023-02-01 16:29:12 -

Apsara Clouder云计算专项技能认证:云服务器ECS入门

获得于2023-02-01 16:01:26

Apsara Clouder云计算专项技能认证:云服务器ECS入门

获得于2023-02-01 16:01:26

-

为别人开路,让别人有路可走,这是我写博客的动力之一。

暂无精选文章

暂无更多信息

2023年05月

-

05.28 13:56:26

发表了文章

2023-05-28 13:56:26

发表了文章

2023-05-28 13:56:26

.NET面向AI编程——SK框架(SemanticKernel)的简易入门实践

随着ChatGPT开始在各个领域遍地开花,有关的应用也开始层出不穷。随着微软开源SK框架,无疑是给.NET开发者带来面向AI应用的新机遇。以下内容,通过创建一个简单的prompt开始,开发一个使用SK框架进行开发的入门教程,供参考。

2023年02月

-

02.28 10:38:55

发表了文章

2023-02-28 10:38:55

发表了文章

2023-02-28 10:38:55

Java学习之路006——Servlet开发

包括引入servlet的api库、IDEA2022配置servlet有关操作,以及servlet的xml配置与注解使用;以及简单的servlet编程实现。

-

02.28 10:32:36

发表了文章

2023-02-28 10:32:36

发表了文章

2023-02-28 10:32:36

Java学习之路002——面向对象编程

包括面向对象编程的基础使用,包括封装、继承、多态,以及接口的使用等。最后还有一些IDEA操作的快捷键附录。

-

02.28 10:28:40

发表了文章

2023-02-28 10:28:40

发表了文章

2023-02-28 10:28:40

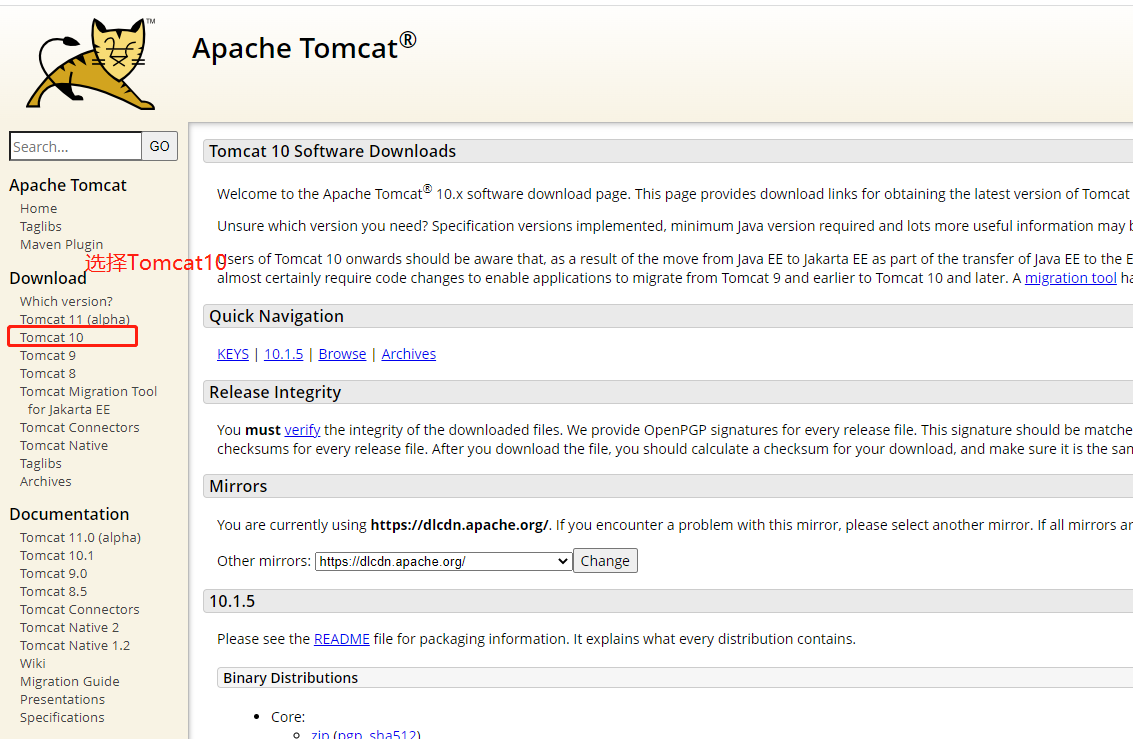

Java学习之路005——Tomcat服务器环境搭建、JavaWeb项目创建以及IDEA配置Tomcat环境教程

Tomcat服务器环境搭建、使用IDEA2022版本进行JavaWeb项目创建以及IDEA配置Tomcat环境教程。

-

02.28 10:25:48

发表了文章

2023-02-28 10:25:48

发表了文章

2023-02-28 10:25:48

Java学习之路003——集合

Java基础操作之——集合。文章演示了集合的一些常规常用的操作,以及遍历、Set集合、Map集合、和一些集合操作工具的使用。

-

02.28 10:21:50

发表了文章

2023-02-28 10:21:50

发表了文章

2023-02-28 10:21:50

Java学习之路004——JDBC基础操作

使用JDBC对Mysql数据库进行基础查询操作的演示,包括JDBC连接器下载、引用、使用等。

-

02.20 20:31:02

发表了文章

2023-02-20 20:31:02

发表了文章

2023-02-20 20:31:02

Java学习之路001——基础语法以及IDEA的基本使用(下)

在一个程序执行的过程中,各条语句的执行顺序对程序的结果是有直接影响的。也就是说程序的流程对运行结果有直接的影响。所以,我们必须清楚每条语句的执行流程。而且,很多时候我们要通过控制语句的执行顺序来实现我们要完成的功能。 -

02.20 20:30:36

发表了文章

2023-02-20 20:30:36

发表了文章

2023-02-20 20:30:36

Java学习之路001——基础语法以及IDEA的基本使用(中)

默认转换(从小的数据类型到大的数据类型) • byte,short,char-int-long-float-double • byte,short,char相互之间不转换,它们参与运算首先转换为int -

02.19 18:25:28

发表了文章

2023-02-19 18:25:28

发表了文章

2023-02-19 18:25:28

Java学习之路001——基础语法以及IDEA的基本使用(上)

目录 1.1 开发工具介绍 1.2 案例开发步骤 1.3 程序解析 1.4 常见错误 2.1 关键字 2.1.1 常见关键字 -

02.19 17:48:52

发表了文章

2023-02-19 17:48:52

发表了文章

2023-02-19 17:48:52

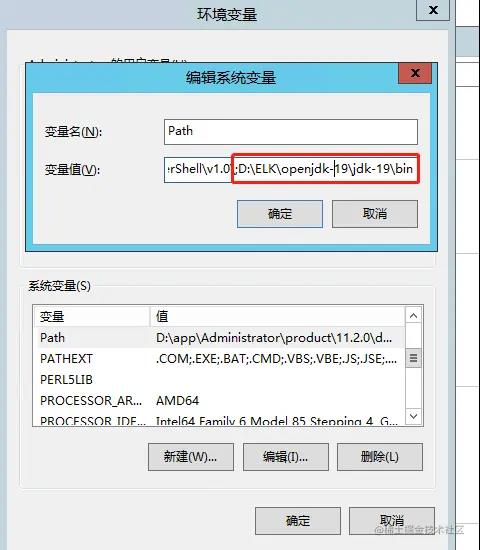

IDEA社区版环境配置和插件安装

解压缩openjdk到任意路径,建议路径不要有中文。然后把路径的bin文件,配置到系统的环境变量Path里面去。

-

02.17 00:14:08

发表了文章

2023-02-17 00:14:08

发表了文章

2023-02-17 00:14:08

使用.NET开发搭建OpenAI模型的中间服务端

前不久微信上大家玩ChatGPT聊天机器人玩的不亦乐乎;不过随着ChatGPT被封杀,所以用微信聊天机器人有可能导致封号的风险。那如果自己不想每次都去OpenAI官网上进行对话【PS:官网上面聊天对话有局限性,例如回复的内容比较长,AI回答是一个一个字写的,就可能导致超过一定时间以后,变成请求超时之类的异常;而通过API直接访问,可以避免这个情况发生】,想要自己搭建一个服务来本地调用,是不是也可以?

-

02.17 00:08:48

发表了文章

2023-02-17 00:08:48

发表了文章

2023-02-17 00:08:48

使用Jupyter记事本记录和制作.NET可视化笔记

对于记录笔记的工具特别多,不过对于程序员来说,记录笔记+程序代码+运行结果演示可以同时存在,无疑会极大增加我们的笔记的可读性和体验感。以前在写python的时候,使用jupyter的体验很好,所以此处做一个基于jupyter的记录C#代码的笔记简易教程,供大家围观。

-

02.17 00:04:33

发表了文章

2023-02-17 00:04:33

发表了文章

2023-02-17 00:04:33

【ELK解决方案】ELK集群+RabbitMQ部署方案以及快速开发RabbitMQ生产者与消费者基础服务

大概一年多前写过一个部署ELK系列的博客文章,前不久刚好在部署一个ELK的解决方案,我顺便就把一些基础的部分拎出来,再整合成一期文章。大概内容包括:搭建ELK集群,以及写一个简单的MQ服务。

-

02.16 23:45:34

发表了文章

2023-02-16 23:45:34

发表了文章

2023-02-16 23:45:34

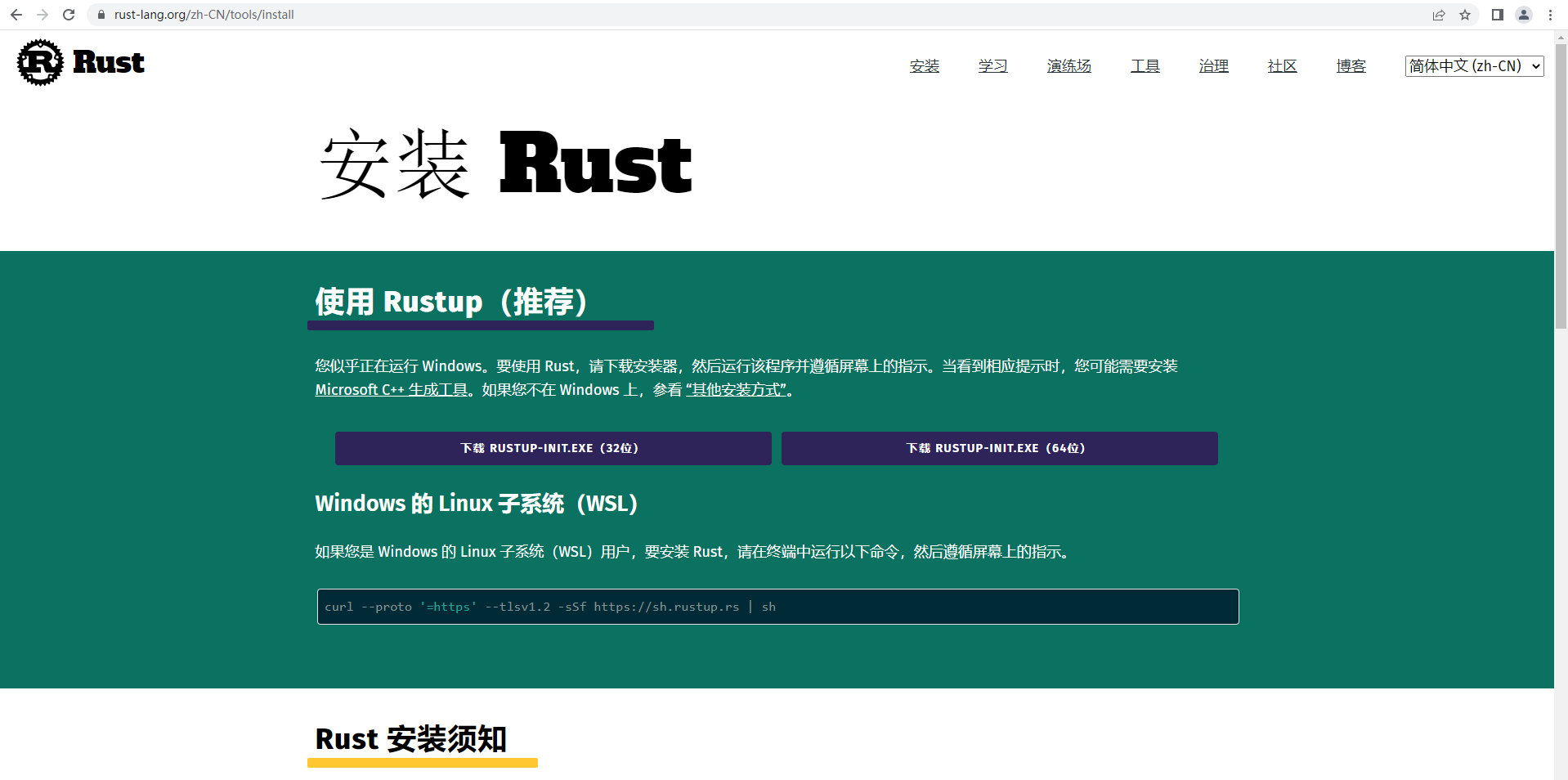

【番外篇】Rust环境搭建+基础开发入门+Rust与.NET6、C++的基础运算性能比较

突然想打算把Rust作为将来自己主要的副编程语言。当然,主语言还是C#,毕竟.NET平台这么强大,写起来就是爽。缘起:之前打算一些新的产品或者新的要开发的东西,由于没有历史包袱,就想重新选型一下,在.NET平台(C#语言)、Golang、Rust里面进行选择一个。

-

02.16 23:38:16

发表了文章

2023-02-16 23:38:16

发表了文章

2023-02-16 23:38:16

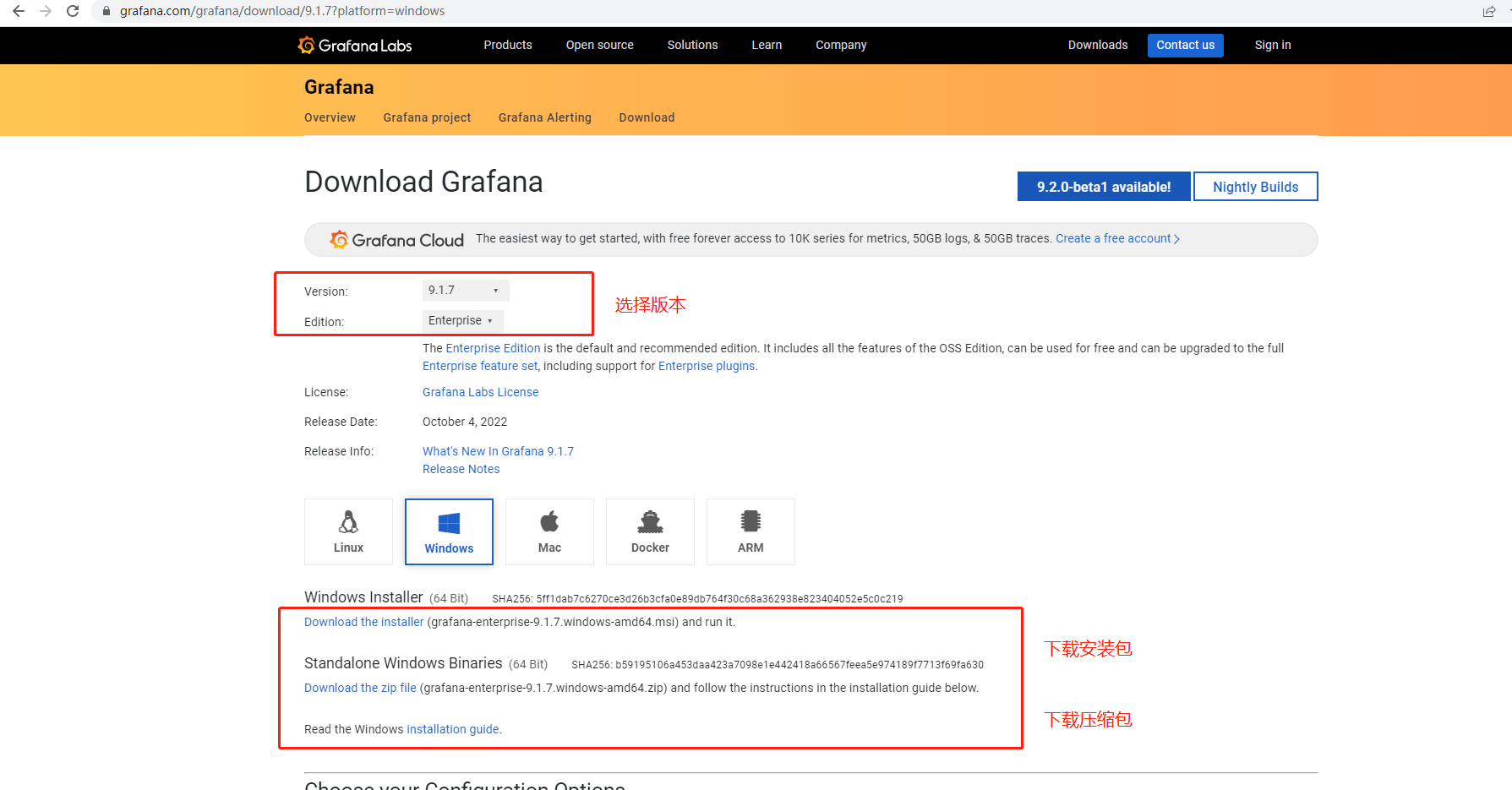

【.NET 6+Loki+Grafana】实现轻量级日志可视化服务功能

日志功能是几乎所有程序或系统都必备的一个功能。该文章通过使用Loki+Grafana来实现日志记录与可视化查询,欢迎围观。

-

02.16 23:29:17

发表了文章

2023-02-16 23:29:17

发表了文章

2023-02-16 23:29:17

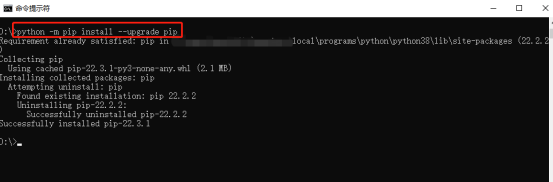

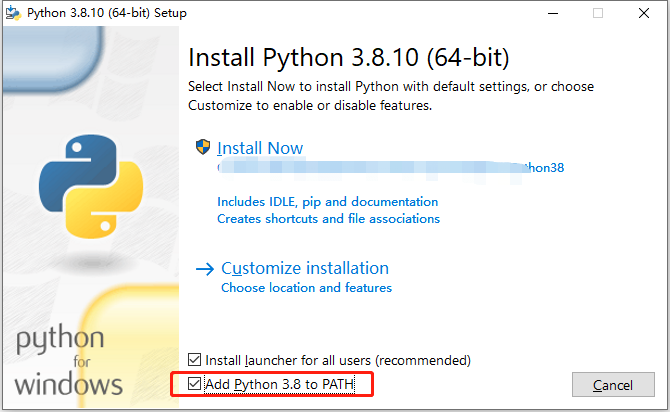

【Python+C#】手把手搭建基于Hugging Face模型的离线翻译系统,并通过C#代码进行访问

目前翻译都是在线的,要在C#开发的程序上做一个可以实时翻译的功能,好像不是那么好做。而且大多数处于局域网内,所以访问在线的api也显得比较尴尬。于是,就有了以下这篇文章,自己搭建一套简单的离线翻译系统。以下内容采用python提供基础翻译服务+ C#访问服务的功能,欢迎围观。

-

02.16 23:18:43

发表了文章

2023-02-16 23:18:43

发表了文章

2023-02-16 23:18:43

【WPF】实现动态切换语言(国际化)以及动态换肤功能

以下内容,手把手从搭建到最终实现,完成多语言切换以及换装功能。

-

02.16 23:08:45

发表了文章

2023-02-16 23:08:45

发表了文章

2023-02-16 23:08:45

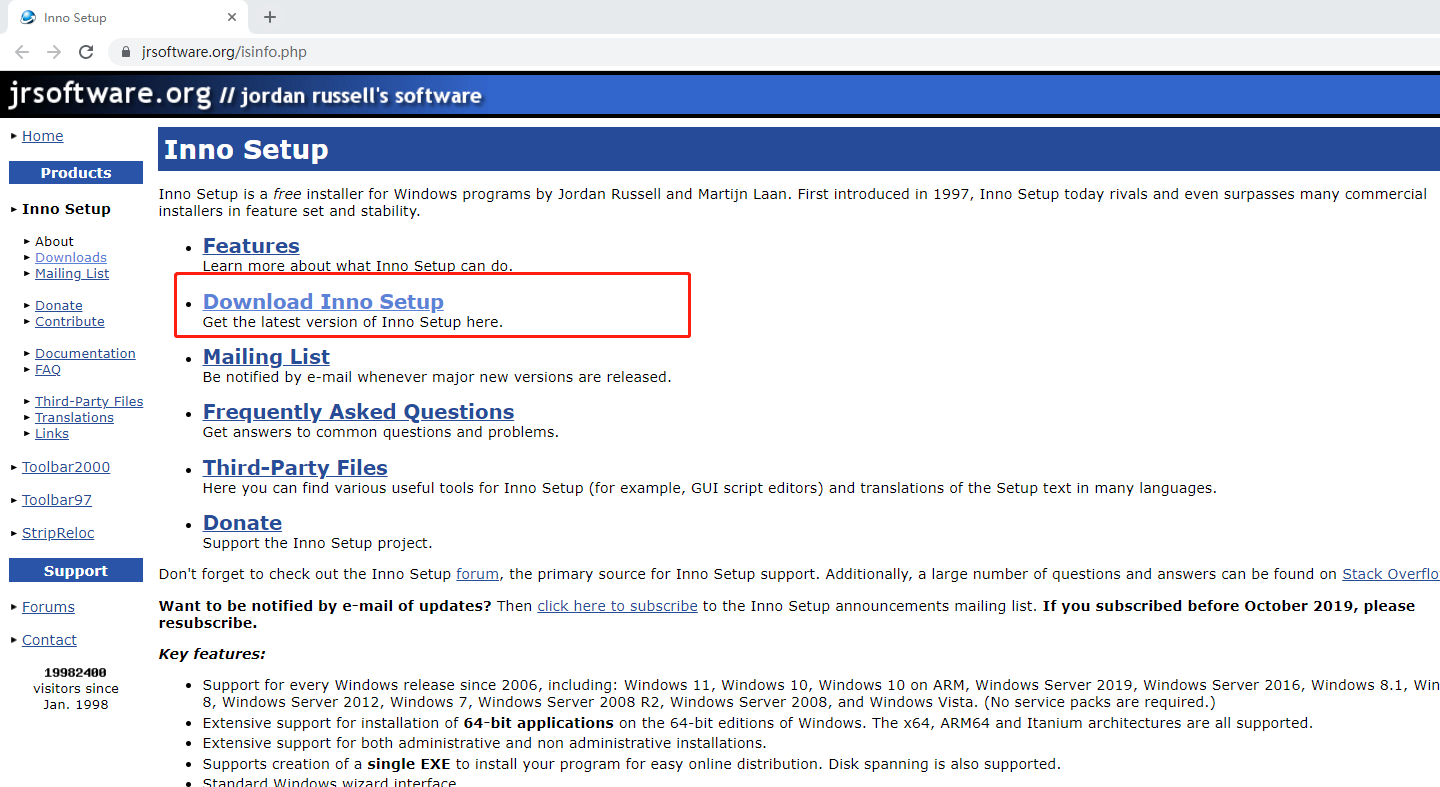

使用Inno Setup 制作软件安装包详细教程(与开发语言无关)

前言:关于如何制作一个软件安装包的教程,与编程语言无关。以下,请看详情~

-

02.16 22:55:41

发表了文章

2023-02-16 22:55:41

发表了文章

2023-02-16 22:55:41

【Maui正式版】创建可跨平台的Maui程序,以及有关依赖注入、MVVM双向绑定的实现和演示

Maui终于在昨天(2022年8月9日)推送出来了。今儿就迫不及待来把玩一下先。

-

02.16 22:47:54

发表了文章

2023-02-16 22:47:54

发表了文章

2023-02-16 22:47:54

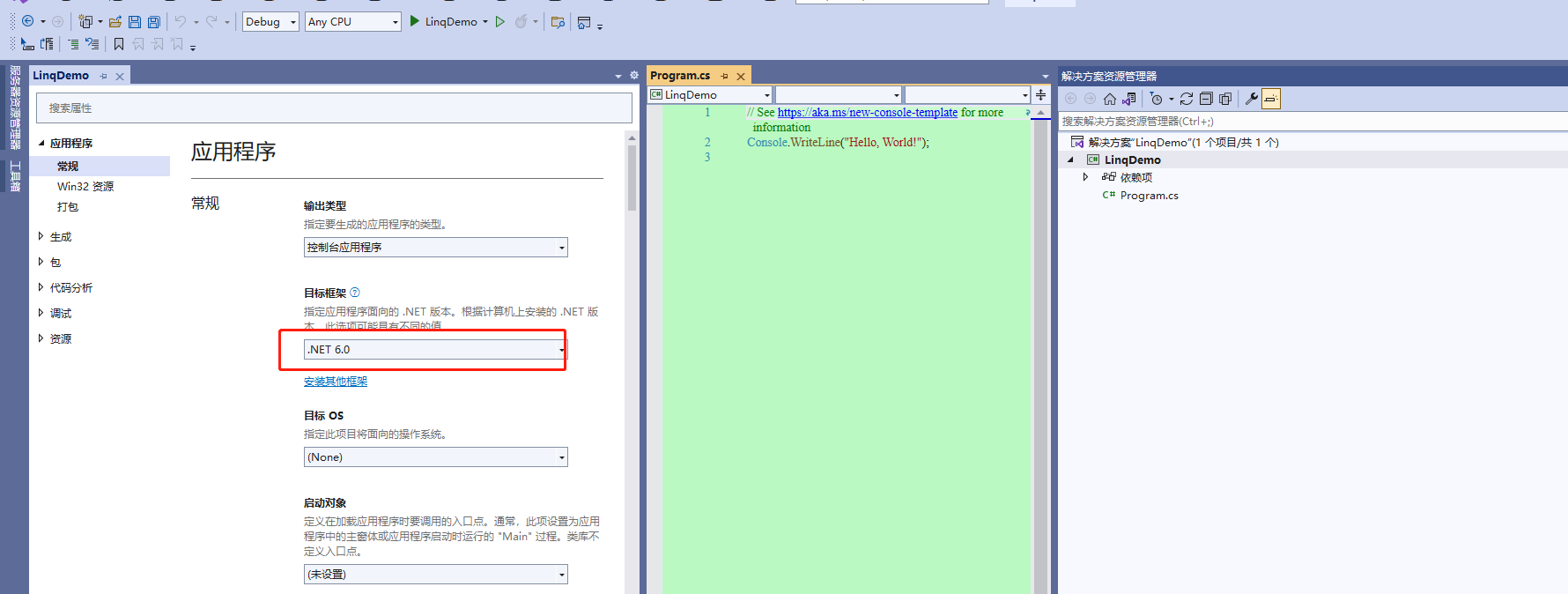

【.NET基础】Linq常用语法代码演示

前言:前言不重要,linq入门常用的语法,linq语法可以用来写操作集合、数据库表集合等等几乎所有集合类型的操作。下面就写几个案例(以List集合来做的),看代码和运行结果即可。

-

02.16 22:43:14

发表了文章

2023-02-16 22:43:14

发表了文章

2023-02-16 22:43:14

【.NET+MQTT】.NET6 环境下实现MQTT通信,以及服务端、客户端的双边消息订阅与发布的代码演示

MQTT广泛应用于工业物联网、智能家居、各类智能制造或各类自动化场景等。MQTT是一个基于客户端-服务器的消息发布/订阅传输协议,在很多受限的环境下,比如说机器与机器通信、机器与物联网通信等。好了,科普的废话不多说,下面直接通过.NET环境来实现一套MQTT通信demo,实现服务端与客户端的双边消息发布与订阅的功能和演示。

-

02.16 22:28:43

发表了文章

2023-02-16 22:28:43

发表了文章

2023-02-16 22:28:43

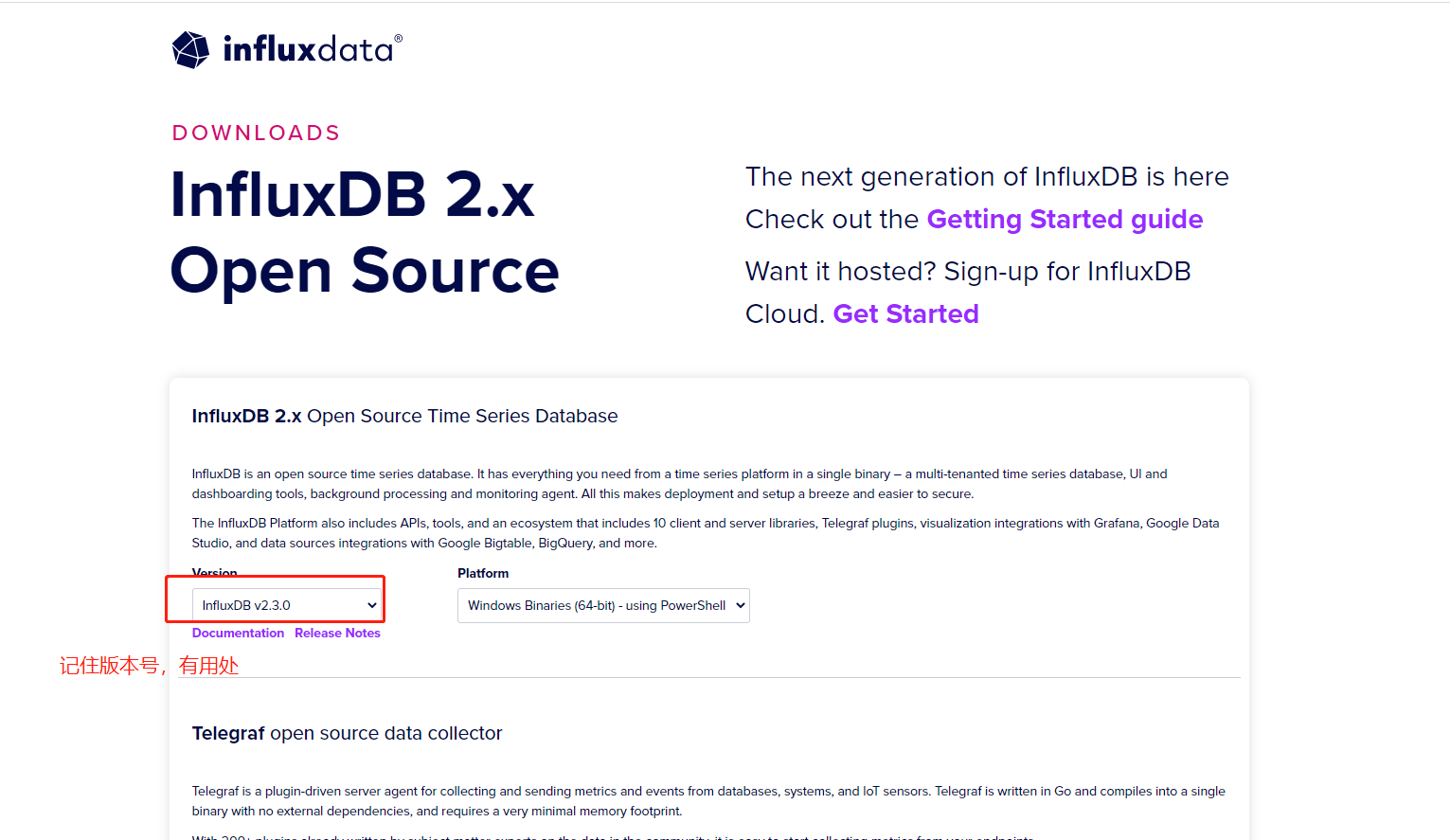

【时序数据库InfluxDB】Windows环境下配置InfluxDB+数据可视化,以及使用 C#进行简单操作的代码实例

influxDB的官网下载地址 https://portal.influxdata.com/downloads/打开以后,如下图所示,可以选择版本号,以及平台。此处咱们选择windows平台。不过此处没有实际的可以下载的地方,着实比较过分,不过咱们可以另辟蹊径。

-

02.16 22:20:29

发表了文章

2023-02-16 22:20:29

发表了文章

2023-02-16 22:20:29

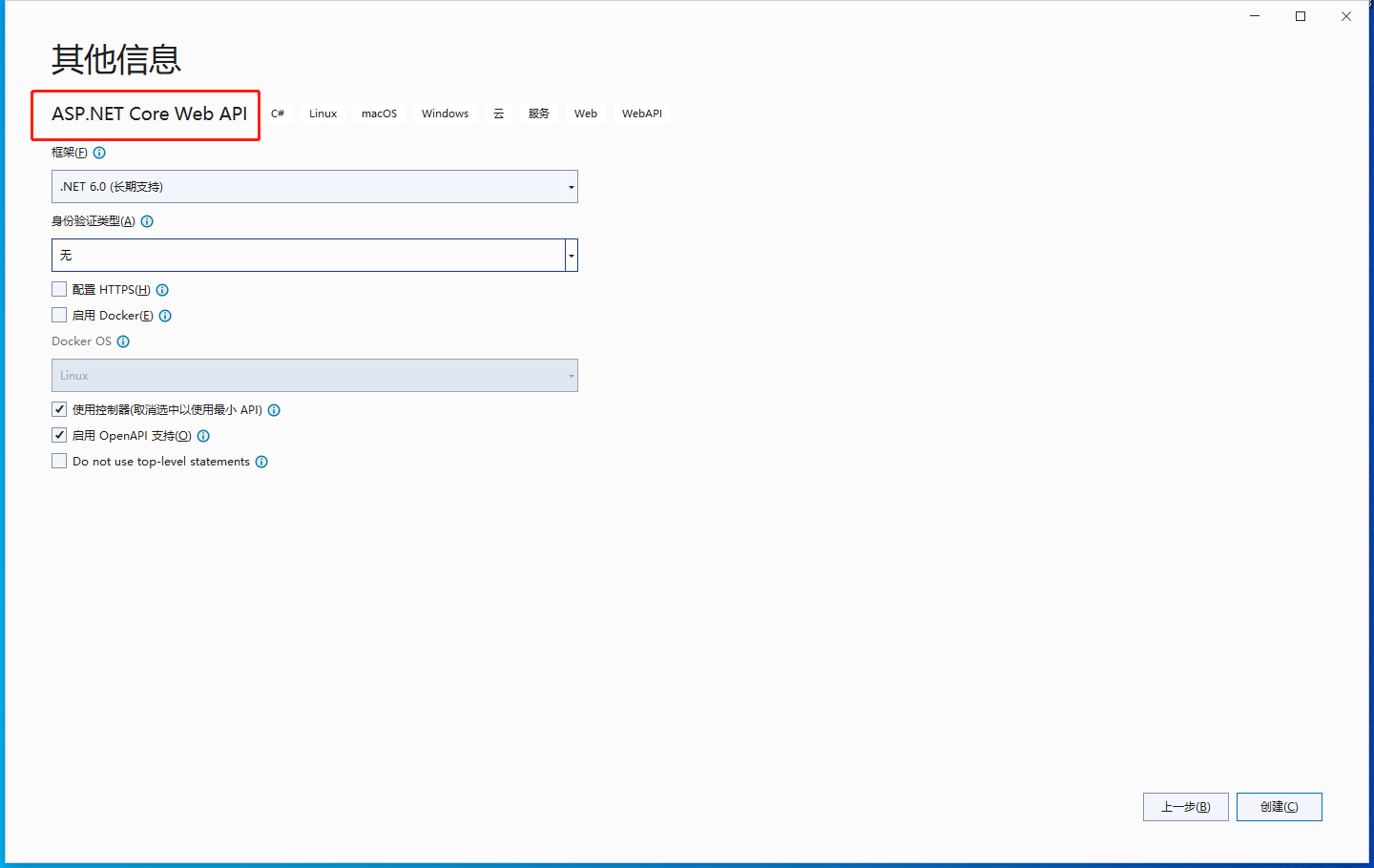

【Nginx】Windows平台下配置Nginx服务实现负载均衡

系统环境:win10 测试用的开发环境和服务类型:VS2022 + DotNet 6 + WebApi

-

02.16 22:15:57

发表了文章

2023-02-16 22:15:57

发表了文章

2023-02-16 22:15:57

【WPF】CAD工程图纸转WPF可直接使用的xaml代码技巧

随着工业化的进一步发展,制造业、工业自动化等多领域,都可能用到上位监控系统。而WPF在上位监控系统方面,应该算是当下最流行的前端框架之一了。而随着监控体系的不断完善与更新迭代,监控画面会变得越来越复杂、多样化和全面化。

-

02.16 22:12:07

发表了文章

2023-02-16 22:12:07

发表了文章

2023-02-16 22:12:07

【.NET 6】多线程的几种打开方式和代码演示

多线程无处不在,平常的开发过程中,应该算是最常用的基础技术之一了。以下通过Thread、ThreadPool、再到Task、Parallel、线程锁、线程取消等方面,一步步进行演示多线程的一些基础操作。欢迎大家围观。如果大佬们有其他关于多线程的拓展,也欢迎在评论区进行留言,大佬们的知识互助,是.net生态发展的重要一环,欢迎大佬们进行留言,帮助更多的人。

-

02.16 21:57:35

发表了文章

2023-02-16 21:57:35

发表了文章

2023-02-16 21:57:35

【WPF】WPF开发用户控件、用户控件属性依赖DependencyProperty实现双向绑定、以及自定义实现Command双向绑定功能演示

Wpf开发过程中,最经常使用的功能之一,就是用户控件(UserControl)了。用户控件可以用于开发用户自己的控件进行使用,甚至可以用于打造一套属于自己的UI框架。依赖属性(DependencyProperty)是为用户控件提供可支持双向绑定的必备技巧之一,同样用处也非常广泛。

-

02.16 21:52:39

发表了文章

2023-02-16 21:52:39

发表了文章

2023-02-16 21:52:39

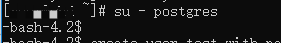

【PostgreSQL】入门学习笔记(包括安装、环境与参数配置、故障排查以及备份还原等)

以下内容为前几天在备考PostgreSQL入门考试时候做的笔记,经过了全职的两天的奋战与实验,并最终顺利通过了PCA初级认证考试。现在把我学习的笔记分享给大家,文中有对应的思维导图图片可供查看,内容与后面正文文本一致。另外,由于SQL语句部分比较基础,基本上会一门数据库就都会,所以此处部分省略掉不做过多记录了。

-

02.16 21:49:46

发表了文章

2023-02-16 21:49:46

发表了文章

2023-02-16 21:49:46

【.NET6+Modbus】Modbus TCP协议解析、仿真环境以及基于.NET实现基础通信

随着工业化的发展,目前越来越多的开发,从互联网走向传统行业。其中,工业领域也是其中之一,包括各大厂也都在陆陆续续加入工业4.0的进程当中。

-

02.16 21:40:13

发表了文章

2023-02-16 21:40:13

发表了文章

2023-02-16 21:40:13

【.NET 6】使用EF Core 访问Oracle+Mysql+PostgreSQL并进行简单增改操作与性能比较

唠嗑一下。都在说去O或者开源,但是对于数据库选型来说,很多人却存在着误区。例如,去O,狭义上讲,是去Oracle数据库。但是从广义上来说,是去Oracle公司产品或者具有漂亮国垄断地位和需要商业授权的数据库产品。

-

02.16 21:31:15

发表了文章

2023-02-16 21:31:15

发表了文章

2023-02-16 21:31:15

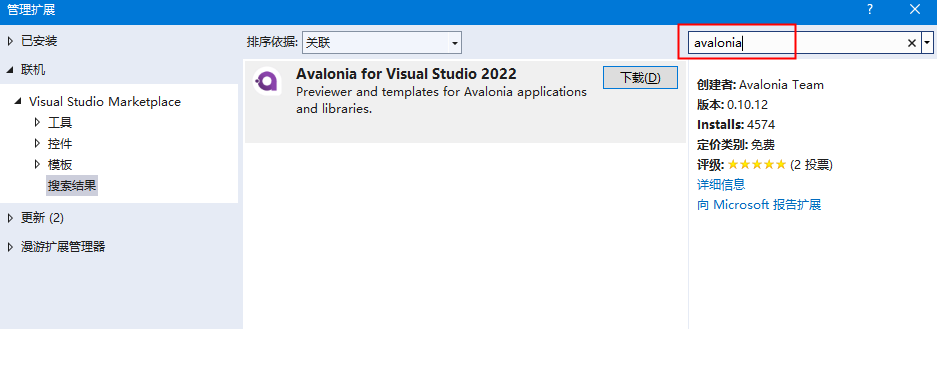

【.NET6+Avalonia】开发支持跨平台的仿WPF应用程序以及基于ubuntu系统的演示

随着跨平台越来越流行,.net core支持跨平台至今也有好几年的光景了。但是目前基于.net的跨平台,大多数还是在使用B/S架构的跨平台上;至于C/S架构,大部分人可能会选择QT进行开发,或者很早之前还有一款Mono可以支持.NET开发者进行开发跨平台应用。

-

02.16 21:20:21

发表了文章

2023-02-16 21:20:21

发表了文章

2023-02-16 21:20:21

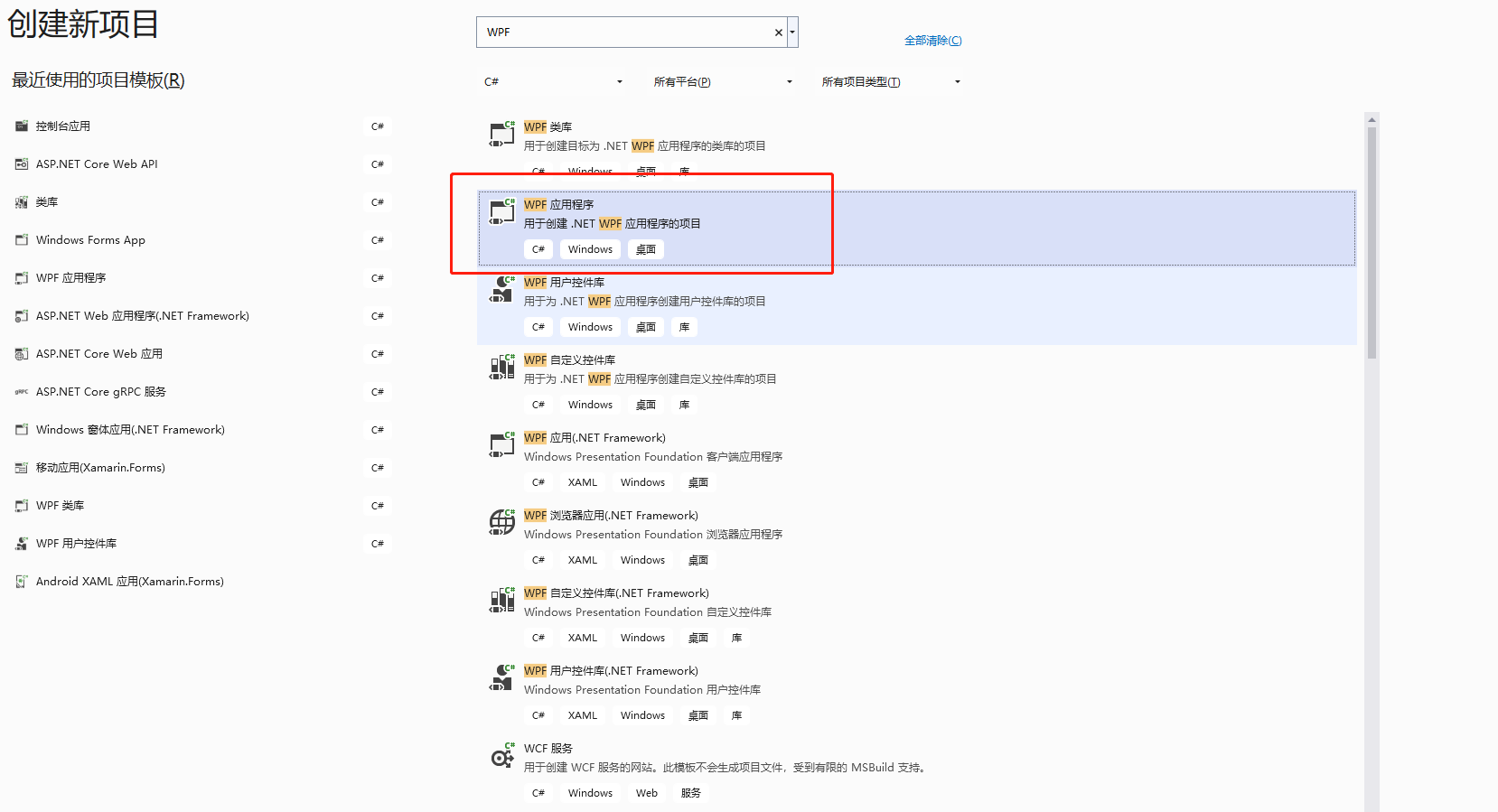

【.NET6+WPF】WPF使用prism框架+Unity IOC容器实现MVVM双向绑定和依赖注入

前言:在C/S架构上,WPF无疑已经是“桌面一霸”了。在.NET生态环境中,很多小伙伴还在使用Winform开发C/S架构的桌面应用。但是WPF也有很多年的历史了,并且基于MVVM的开发模式,受到了很多开发者的喜爱。

-

02.16 21:10:16

发表了文章

2023-02-16 21:10:16

发表了文章

2023-02-16 21:10:16

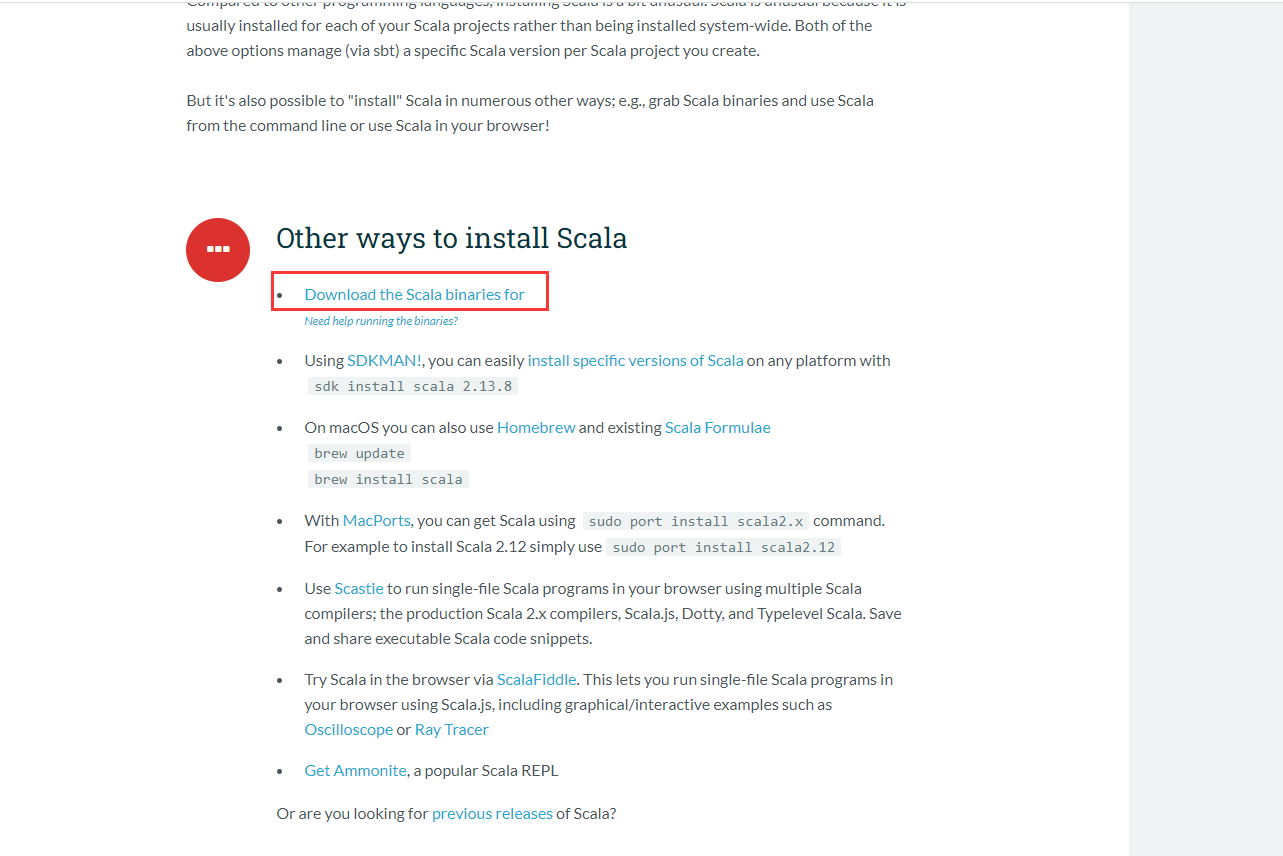

【Kafka】基于Windows环境的Kafka有关环境(scala+zookeeper+kafka+可视化工具)搭建、以及使用.NET环境开发的案例代码与演示

基于Windows系统下的Kafka环境搭建;以及使用.NET 6环境进行开发简单的生产者与消费者的演示。

-

02.16 20:52:55

发表了文章

2023-02-16 20:52:55

发表了文章

2023-02-16 20:52:55

【备战软考架构师系列笔记 · 003】软件工程篇 —— 软件开发模型(下篇:敏捷开发) ⭐⭐⭐⭐⭐

软件开发模型笔记(下篇)—— 敏捷开发模型/方法

-

02.16 20:50:23

发表了文章

2023-02-16 20:50:23

发表了文章

2023-02-16 20:50:23

【备战软考架构师系列笔记 · 002】软件工程篇 —— 软件开发模型(上篇:经典开发模型) ⭐⭐⭐⭐⭐

软件开发模型笔记(上篇)—— 经典的几个软件开发模型

-

02.16 20:46:50

发表了文章

2023-02-16 20:46:50

发表了文章

2023-02-16 20:46:50

【备战软考架构师系列笔记 · 001】软件工程篇 —— 软件开发方法的主要分类 ⭐

# 软件开发方法### 分类- 按功能 - 水平原型(针对界面) - 垂直原型(针对复杂算法)

-

02.16 20:38:03

发表了文章

2023-02-16 20:38:03

发表了文章

2023-02-16 20:38:03

【Redis的那些事 · 续集】Redis的位图、HyperLogLog数据结构演示以及布隆过滤器

位图的最小单位是bit,每个bit的值只能是0和1,位图的应用场景一般用于一些签到记录,例如打卡等。场景举例: 例如某APP要存储用户的打卡记录,如果按照正常的思路来做,可能是用户每天是否打卡的记录都单独设置一个key-value键值对来存储,这样的话,每个用户每天都需要耗费一个键值对空间。而如果是位图,就可以很方便地通过位图来进行记录

-

02.16 20:27:12

发表了文章

2023-02-16 20:27:12

发表了文章

2023-02-16 20:27:12

【Redis的那些事 · 上篇】Redis的介绍、五种数据结构演示和分布式锁

Redis,全称是Remote Dictionary Service,翻译过来就是,远程字典服务。redis属于nosql非关系型数据库。Nosql常见的数据关系,基本上是以key-value键值对形式存在的。Key-value: 就像翻阅中文字典或者单词字典,通过指定的需要查询的字或者单词(key),可以查找到字典里面对应的详细内容和介绍(value)

-

02.16 20:15:17

发表了文章

2023-02-16 20:15:17

发表了文章

2023-02-16 20:15:17

【C++】使用VS2022开发可以在线远程编译部署的C++程序

c++类库源码以及其他有关资源。站点是英文的,英文不好的话可以谷歌浏览器在线翻译。http://www.cplusplus.com/

-

02.16 20:06:35

发表了文章

2023-02-16 20:06:35

发表了文章

2023-02-16 20:06:35

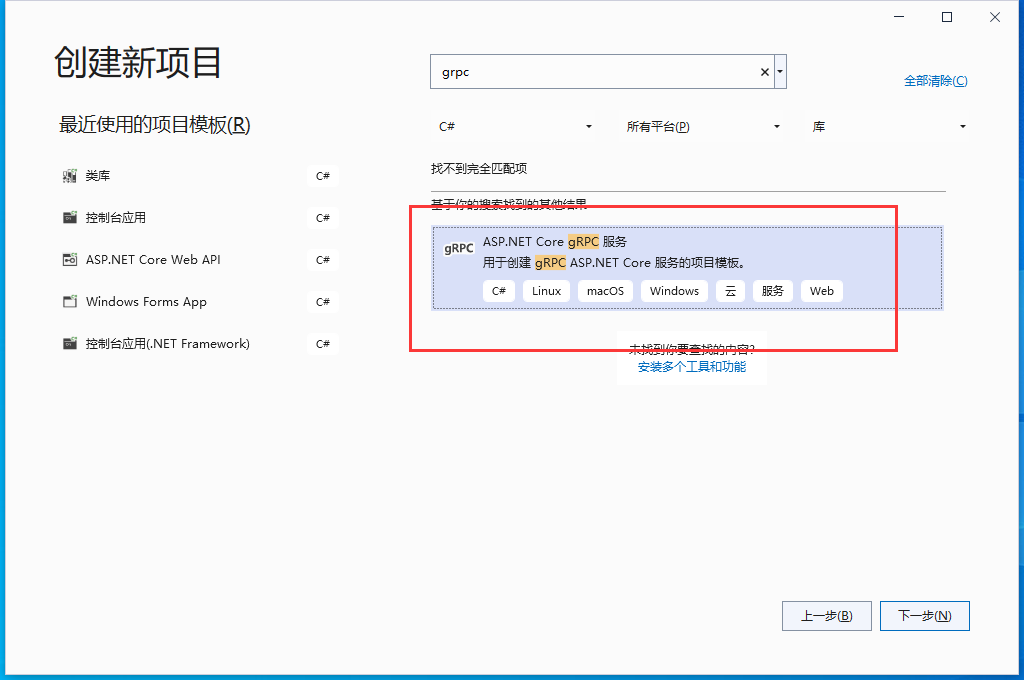

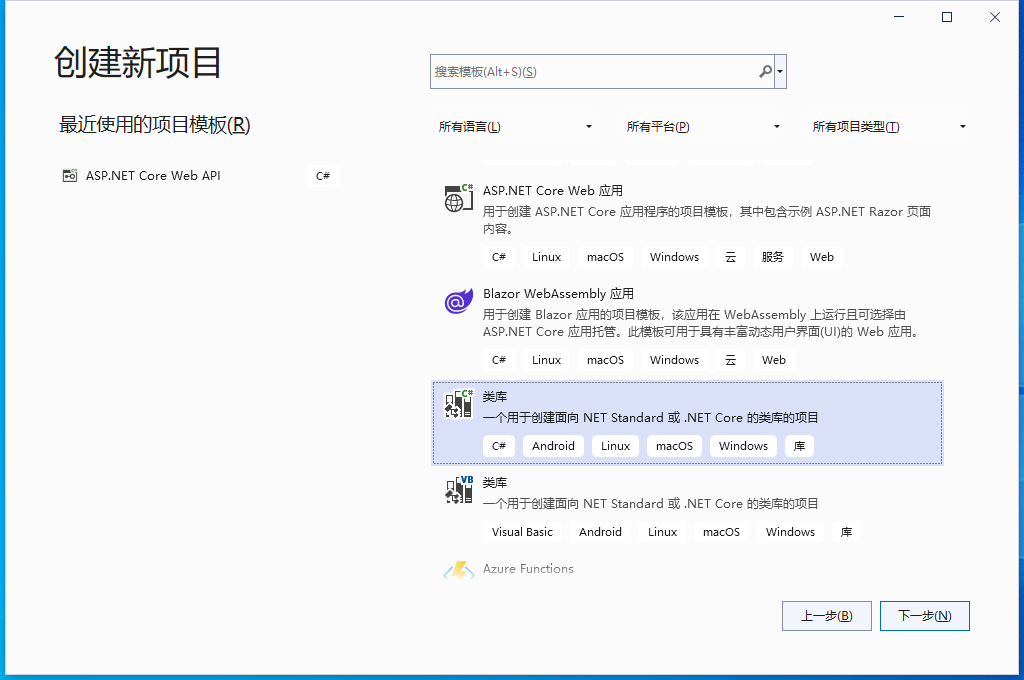

【.NET6】gRPC服务端和客户端开发案例,以及minimal API服务、gRPC服务和传统webapi服务的访问效率大对决

前言:随着.Net6的发布,Minimal API成了当下受人追捧的角儿。而这之前,程序之间通信效率的王者也许可以算得上是gRPC了。那么以下咱们先通过开发一个gRPC服务的教程,然后顺势而为,再接着比拼一下minimal api服务和gRPC服务在通信上的效率。

-

02.16 19:57:27

发表了文章

2023-02-16 19:57:27

发表了文章

2023-02-16 19:57:27

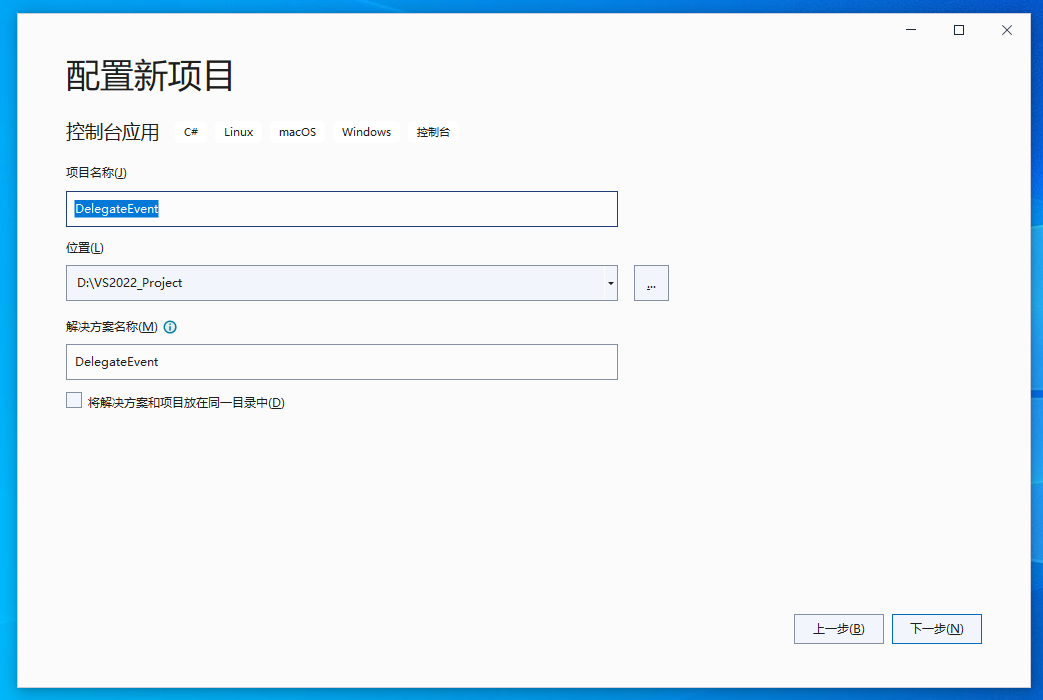

【.Net】使用委托实现被引用的项目向上级项目的消息传递事件

在实际项目过程中,经常可能遇到被引用的项目要向上传递消息,但是又不能通过方法进行返回等操作,这个时候委托就派上用场了。以下使用委托,来实现被引用的项目向上传递消息的小教程,欢迎各位大佬提供建议。1、新增控制台项目(一般在CS架构中会用的比较多,用于跨线程传递消息使用)。此处用一个控制台项目来模拟演示使用委托进行消息事件的传递教程。

-

02.16 19:53:34

发表了文章

2023-02-16 19:53:34

发表了文章

2023-02-16 19:53:34

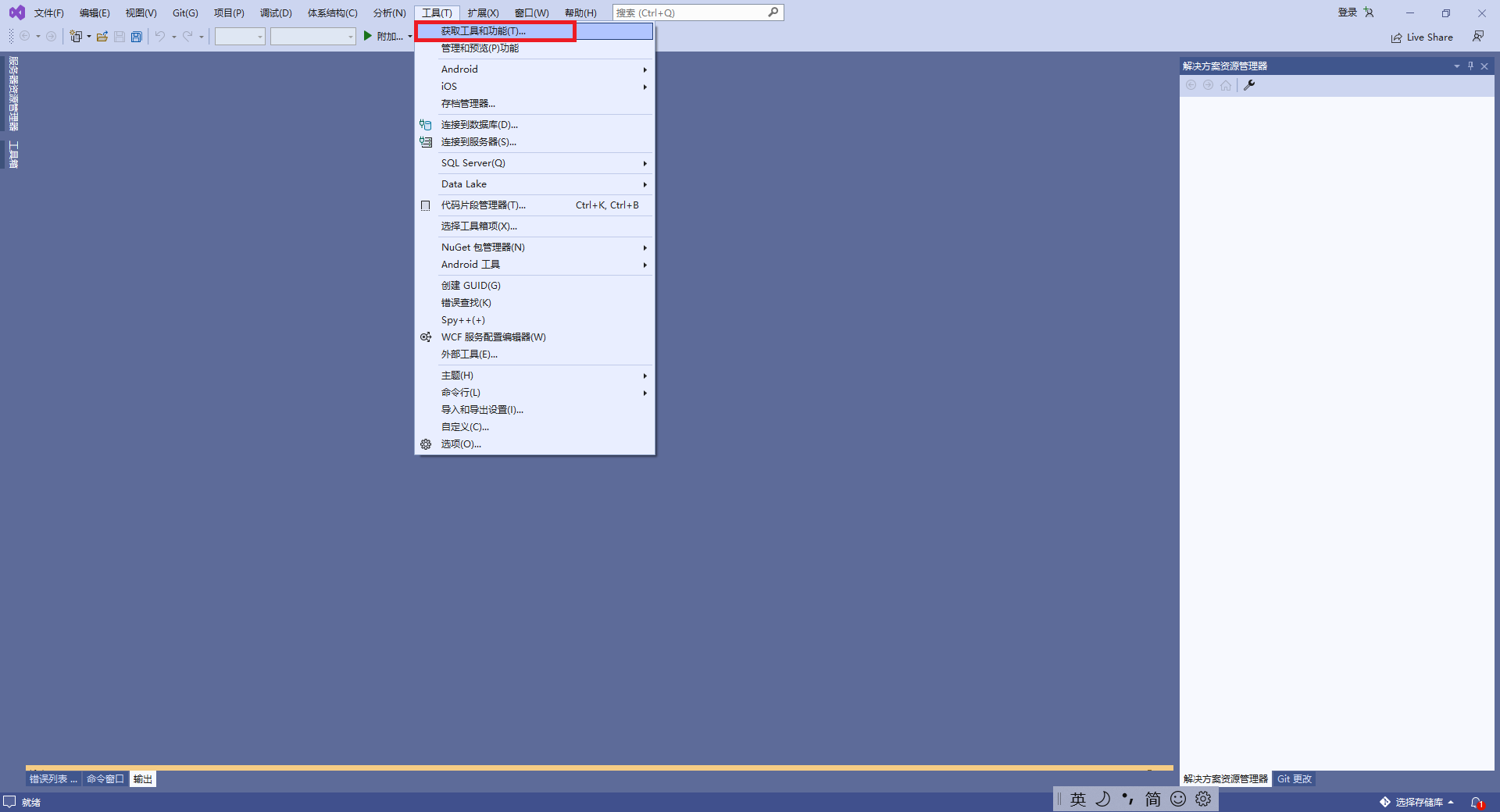

【.NET 6】使用.NET 6开发minimal api以及依赖注入的实现、VS2022热重载和自动反编译功能的演示

.net 6 LTS版本发布已经有若干天了。此处做一个关于使用.net 6 开发精简版webapi(minimal api)的入门教程,以及VS2022 上面的两个强大的新技能(热重载、代码自动反编译)的顺带演示。

-

02.16 19:46:15

发表了文章

2023-02-16 19:46:15

发表了文章

2023-02-16 19:46:15

【拥抱元宇宙】创建你的第一个Unity程序HelloWorld,并发布

需要先下载一个Unity Hub,以及安装Unity编辑器。Unity Hub需要登陆,激活码可以选择个人用户,免费的。免费的无法改变启动画面,其他的都还好。以下案例,我以Unity2020.3.22 LTS 版本进行创建,其他大佬们可以根据自己情况选择版本。

-

02.16 19:40:45

发表了文章

2023-02-16 19:40:45

发表了文章

2023-02-16 19:40:45

【不费脑筋系列】为程序添加注释模板/版权注释/自定义头部注释等

大佬们如果经常遇到要写注释,但是手写又那么费时间,并且存在有格式标准化的情况下,可以试试使用注释模板进行配置。教程如下:

-

02.16 19:35:19

发表了文章

2023-02-16 19:35:19

发表了文章

2023-02-16 19:35:19

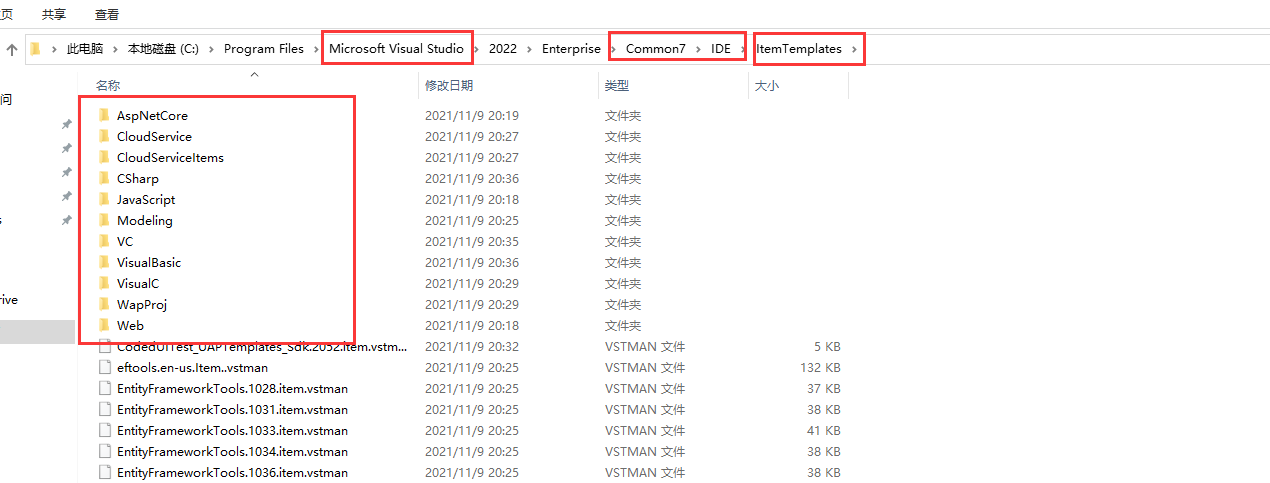

【不费脑筋系列】发布个人的代码包到Nuget服务器上,并通过VS引用进行使用的方法

下面讲个关于个人如何开发nuget包,并部署到nuget服务器上的例子。为了保证.net framework和 .net core都可以访问到我的包,我此处以新建一个.net standard 2.0的版本为例子,提供一个简单的示范。

-

02.16 19:23:28

发表了文章

2023-02-16 19:23:28

发表了文章

2023-02-16 19:23:28

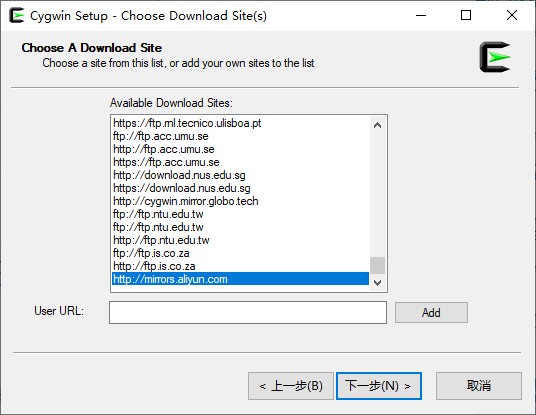

.net core工具组件系列之Redis—— 第一篇:Windows环境配置Redis(5.x以上版本)以及部署为Windows服务

Cygwin工具编译Redis Redis6.x版本是未编译版本(官方很调皮,所以没办法,咱只好帮他们编译一下了),所以咱们先下载一个Cygwin,用它来对Redis进行编译。

-

发表了文章

2023-05-28

发表了文章

2023-05-28

.NET面向AI编程——SK框架(SemanticKernel)的简易入门实践

-

发表了文章

2023-02-28

发表了文章

2023-02-28

Java学习之路006——Servlet开发

-

发表了文章

2023-02-28

发表了文章

2023-02-28

Java学习之路002——面向对象编程

-

发表了文章

2023-02-28

发表了文章

2023-02-28

Java学习之路005——Tomcat服务器环境搭建、JavaWeb项目创建以及IDEA配置Tomcat环境教程

-

发表了文章

2023-02-28

发表了文章

2023-02-28

Java学习之路003——集合

-

发表了文章

2023-02-28

发表了文章

2023-02-28

Java学习之路004——JDBC基础操作

-

发表了文章

2023-02-20

发表了文章

2023-02-20

Java学习之路001——基础语法以及IDEA的基本使用(下)

-

发表了文章

2023-02-20

发表了文章

2023-02-20

Java学习之路001——基础语法以及IDEA的基本使用(中)

-

发表了文章

2023-02-19

发表了文章

2023-02-19

Java学习之路001——基础语法以及IDEA的基本使用(上)

-

发表了文章

2023-02-19

发表了文章

2023-02-19

IDEA社区版环境配置和插件安装

-

发表了文章

2023-02-17

发表了文章

2023-02-17

使用.NET开发搭建OpenAI模型的中间服务端

-

发表了文章

2023-02-17

发表了文章

2023-02-17

使用Jupyter记事本记录和制作.NET可视化笔记

-

发表了文章

2023-02-17

发表了文章

2023-02-17

【ELK解决方案】ELK集群+RabbitMQ部署方案以及快速开发RabbitMQ生产者与消费者基础服务

-

发表了文章

2023-02-16

发表了文章

2023-02-16

【番外篇】Rust环境搭建+基础开发入门+Rust与.NET6、C++的基础运算性能比较

-

发表了文章

2023-02-16

发表了文章

2023-02-16

【.NET 6+Loki+Grafana】实现轻量级日志可视化服务功能

-

发表了文章

2023-02-16

发表了文章

2023-02-16

【Python+C#】手把手搭建基于Hugging Face模型的离线翻译系统,并通过C#代码进行访问

-

发表了文章

2023-02-16

发表了文章

2023-02-16

【WPF】实现动态切换语言(国际化)以及动态换肤功能

-

发表了文章

2023-02-16

发表了文章

2023-02-16

使用Inno Setup 制作软件安装包详细教程(与开发语言无关)

-

发表了文章

2023-02-16

发表了文章

2023-02-16

【Maui正式版】创建可跨平台的Maui程序,以及有关依赖注入、MVVM双向绑定的实现和演示

-

发表了文章

2023-02-16

发表了文章

2023-02-16

【.NET基础】Linq常用语法代码演示

滑动查看更多

暂无更多信息

暂无更多信息