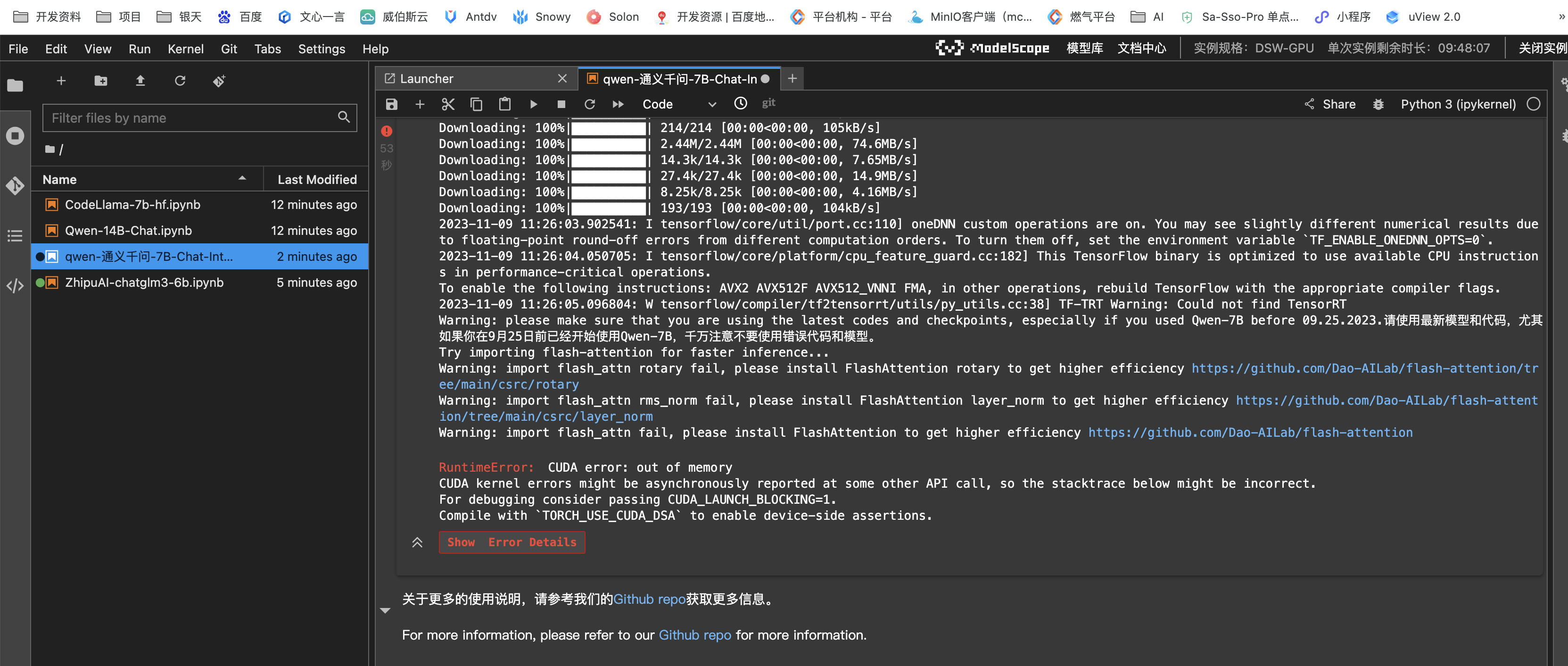

ModelScope 24G的显存,没有一个大模型能跑起来?

ModelScope 24G的显存,没有一个大模型能跑起来?

是代码层面做了什么优化吗?和modelscope版本有关吗

展开

收起

2

条回答

写回答

-

ModelScope的大模型通常需要大量的显存来运行。如果你的服务器只有24GB的显存,那么可能无法运行一些非常大的模型。这是因为深度学习模型通常需要大量的显存来存储其权重和激活。

以下是一些可能的解决方案:

降低模型的规模。你可以尝试使用较小的模型,或者使用更小的输入尺寸。

增加服务器的显存。你可以考虑升级服务器的硬件配置,增加显存的大小。

使用分布式训练。通过将模型分布在多个GPU上运行,可以有效地减少单个GPU的显存需求。

使用梯度累积。这是一种优化技术,可以通过累积多批次的梯度,然后在一次更新中应用这些梯度,从而减少每次迭代所需的显存。

使用更高效的模型结构。一些更高效的模型结构,如EfficientNet和MobileNet,可以在保持高性能的同时,减少显存的需求。

2023-11-29 17:29:16赞同 展开评论 -

一般量化版本显存占用比较少,int8差不多也就12G左右,按说没问题的。 没有,内存增长到最大后可以跑。另一个模型damo/mplug_visual-question-answering_coco_large_en,没有没存增长。您可以在damo/mplug_visual-question-answering_coco_base_zh模型卡片上留言问一下。镜像我用的是registry.cn-hangzhou.aliyuncs.com/modelscope-repo/modelscope:ubuntu20.04-cuda11.8.0-py38-torch2.0.1-tf2.13.0-1.9.4,此回答整理自钉群“魔搭ModelScope开发者联盟群 ①”

2023-11-16 08:51:39赞同 展开评论

相关问答

相关文章

热门讨论

热门文章

展开全部

展开全部

还有其他疑问?

咨询AI助理