导读:首先感谢北京智源大会进行主题演讲的各领域顶级教授,博主受益匪浅,此文章为博主在聆听各领域教授或专家演讲时,一张一张截图进行保存,希望与大家一起学习,共同进步,一起见证或筑起人工智能的下一个十年。非常欢迎国内外人工智能领域网友,前来留言探讨与分享,同时感谢点赞或评论!

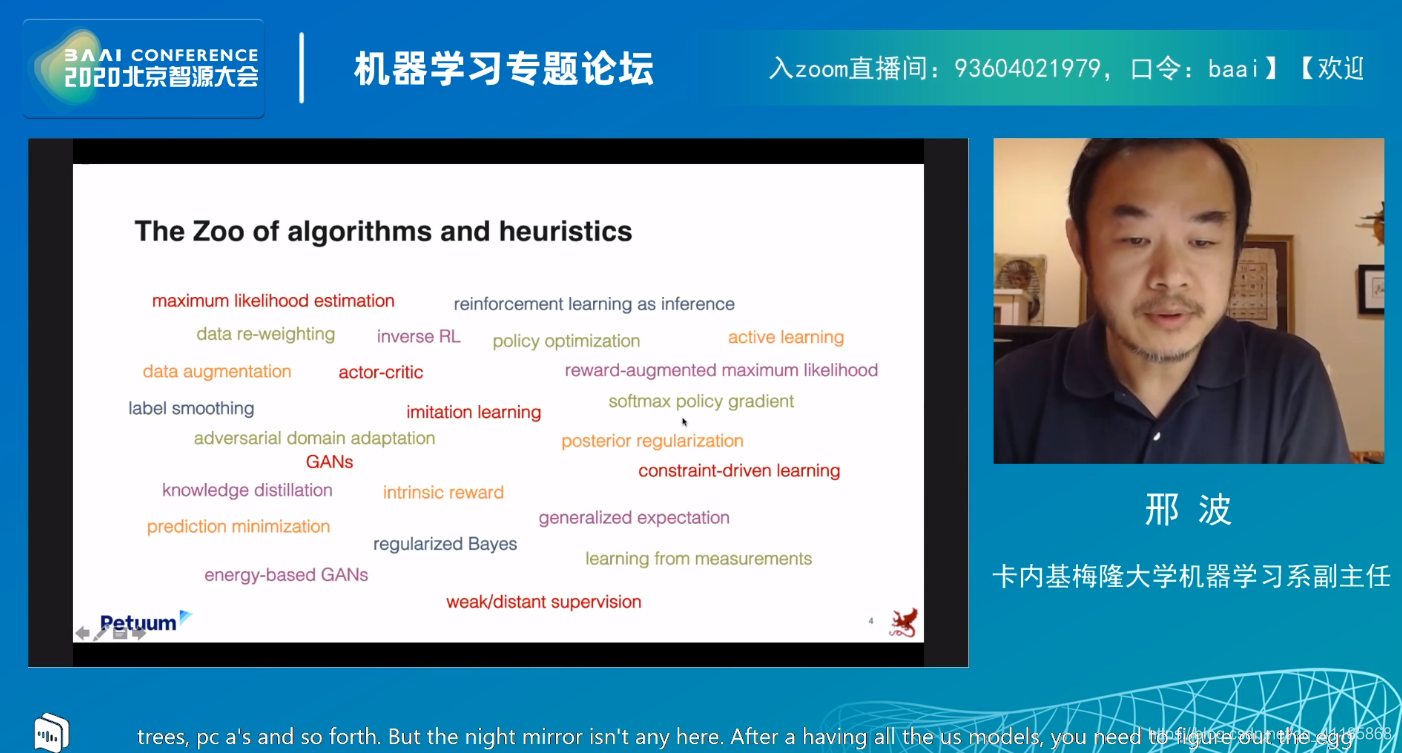

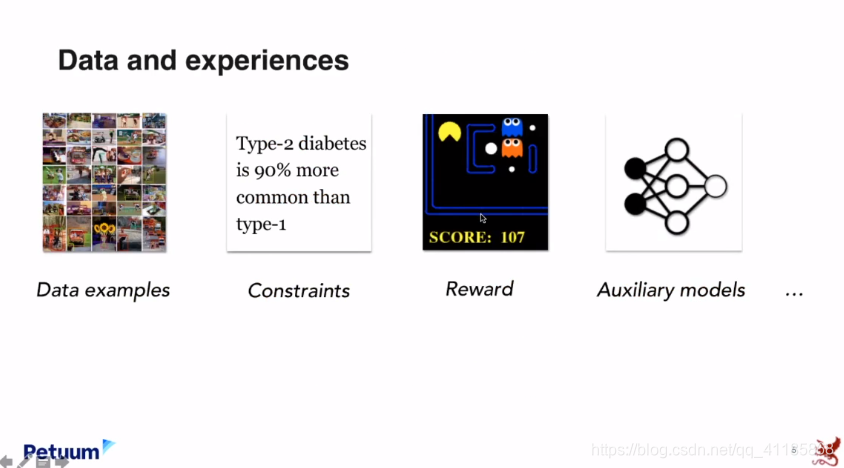

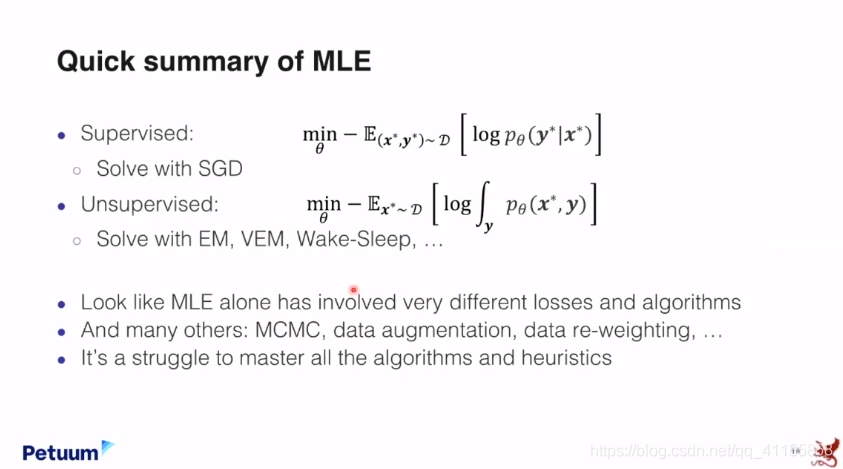

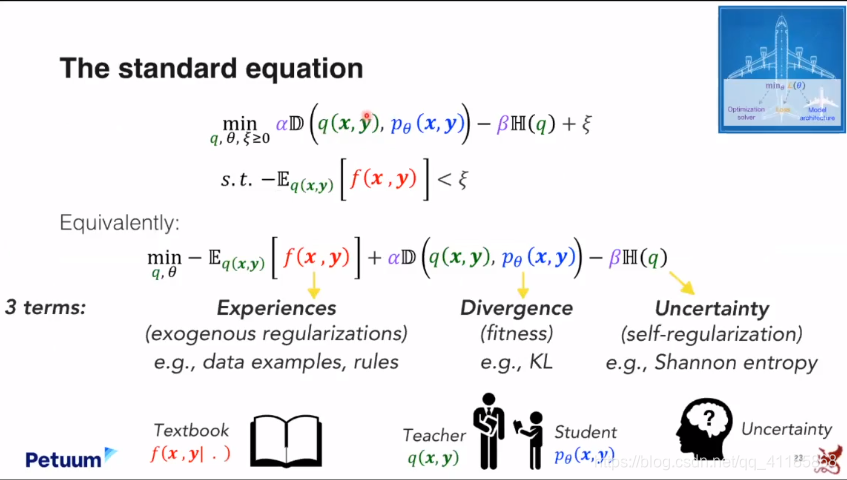

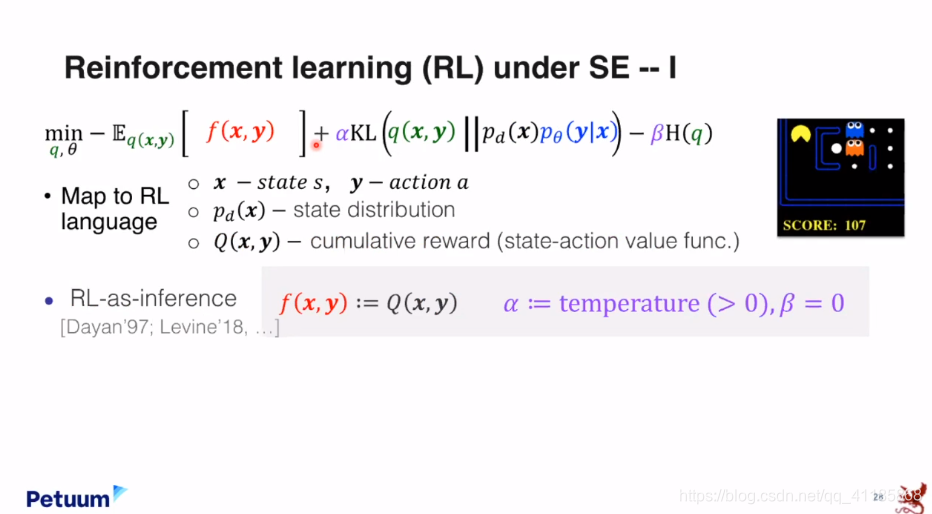

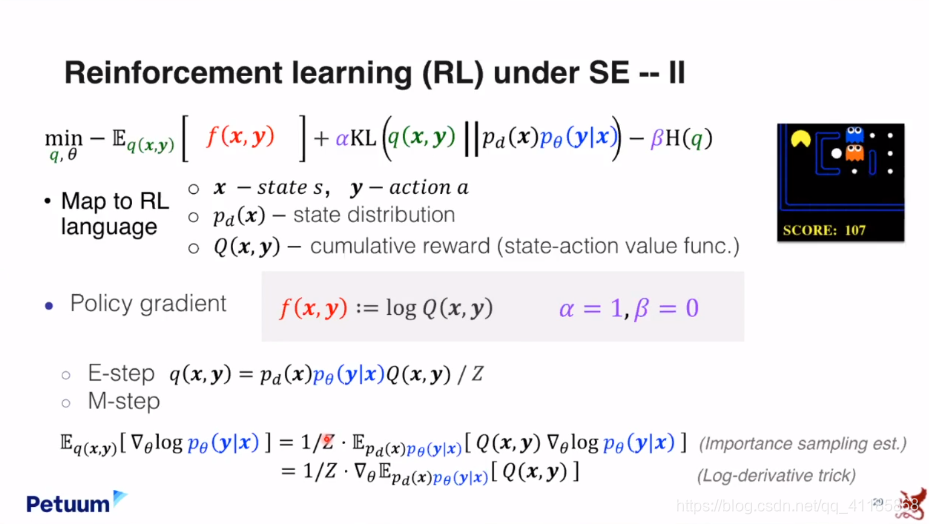

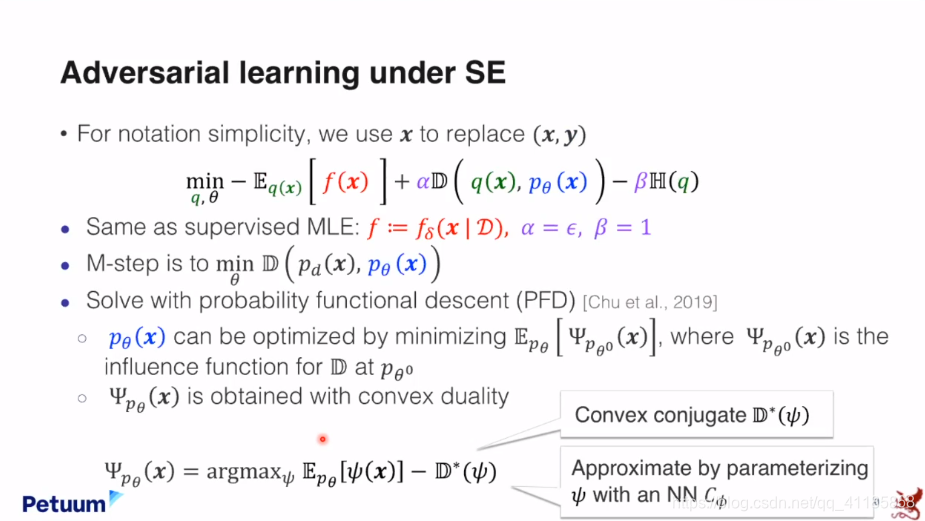

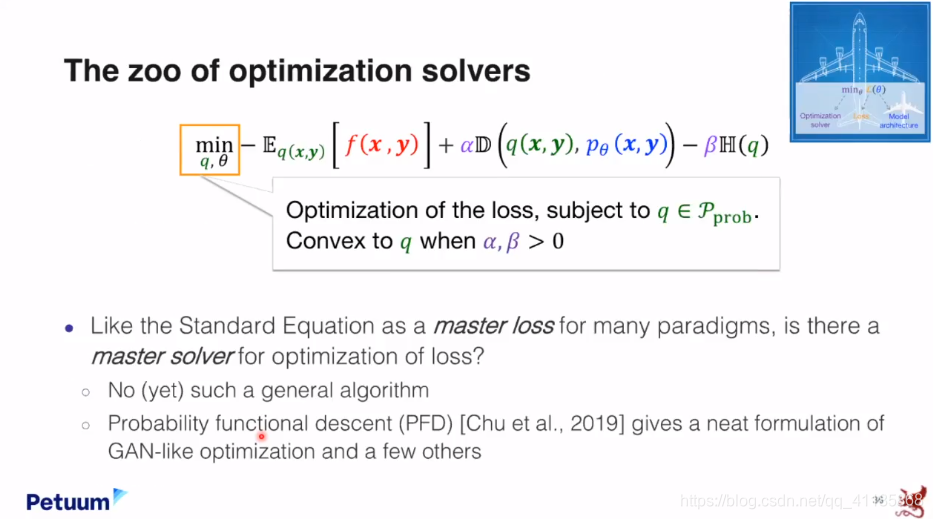

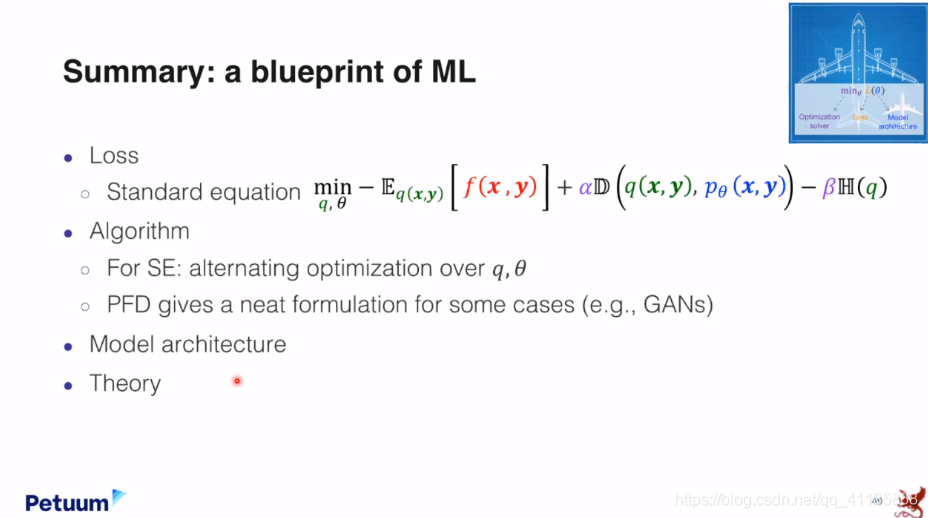

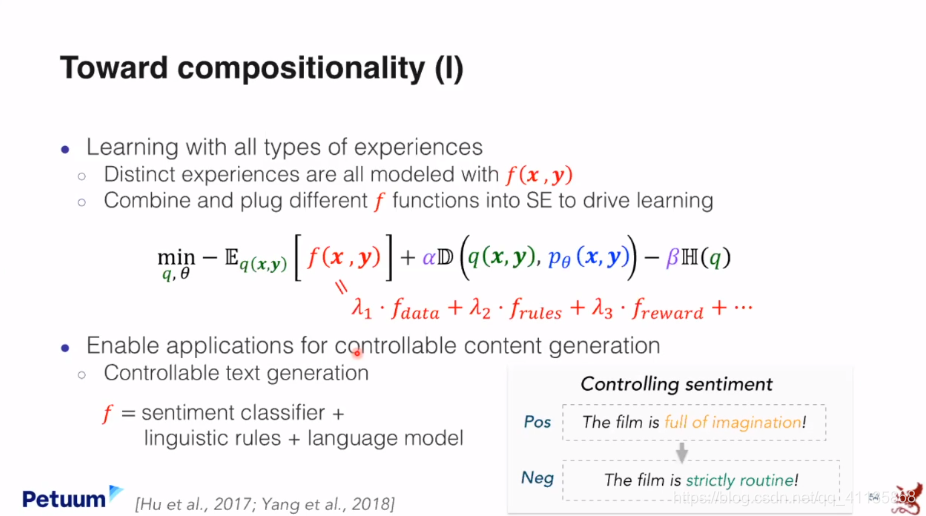

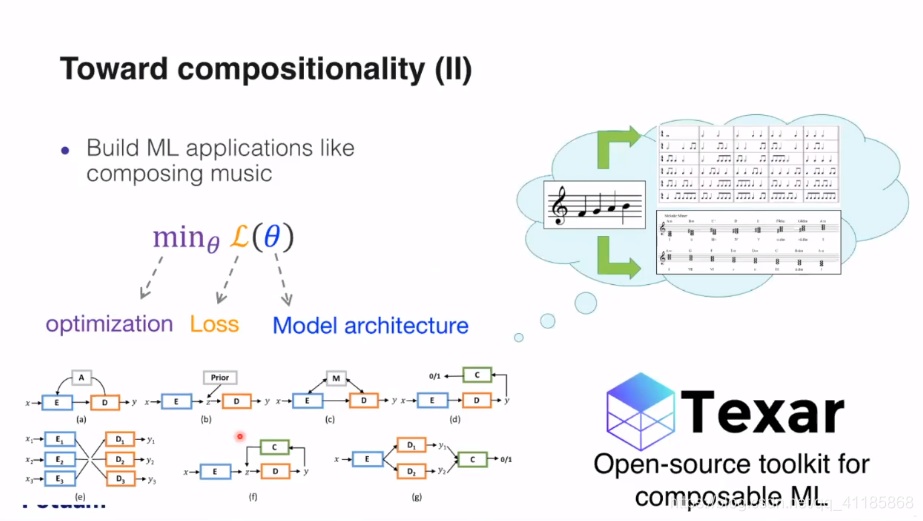

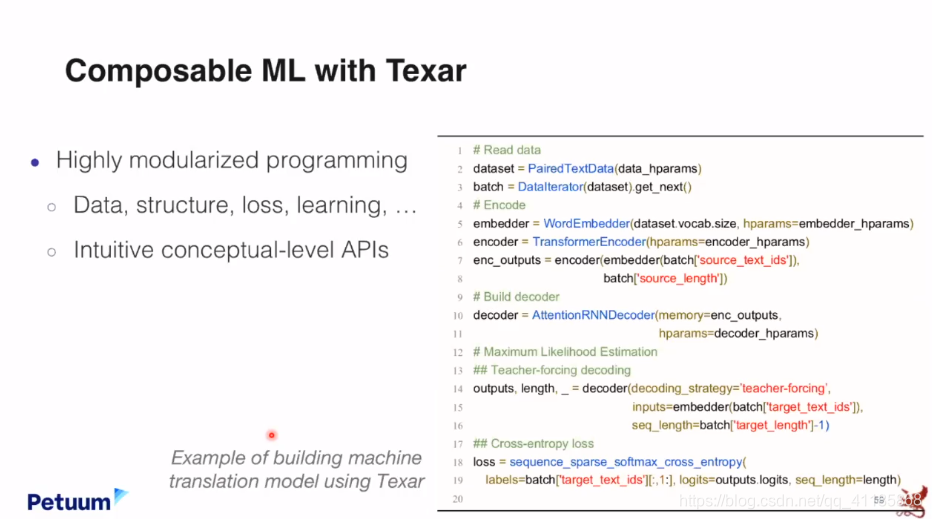

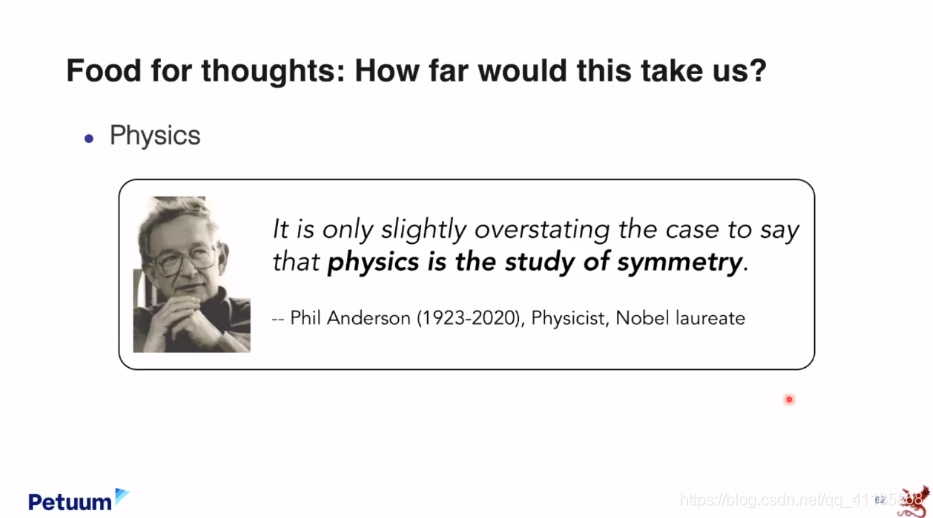

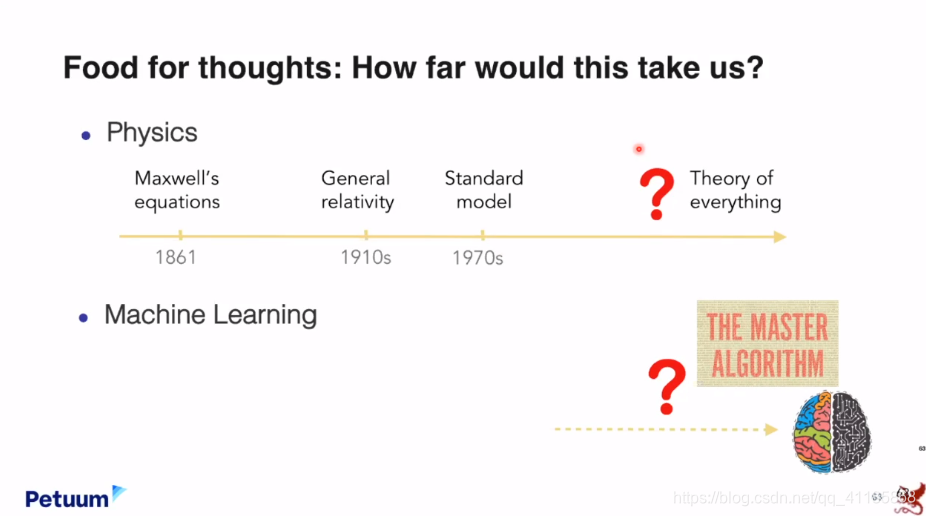

09:45-10:25 A Blueprint of Standardized and Composable Machine Learning

- 邢波 卡内基梅隆大学机器学习系副主任

10:25-11:05 Geometry and Symmetry in (some!) Nonconvex Optimization Problems

- John Wright 哥伦比亚大学教授

11:05-11:35 Learning Based Optimization

- 林宙辰 北京大学教授,智源研究员

11:35-12:05 视觉计算前沿进展

- 孙剑 旷视研究院院长,智源研究员

6月23日上午 — 决策智能专题论坛

- 论坛主席、主持人:徐波 中科院自动化所所长,智源研究院理事

09:00-09:10 Opening Speech

- 徐波 中科院自动化所所长,智源研究院理事

09:10-09:50 Efficient Collaborative Multi-Agent Reinforcement Learning

- 张崇洁 清华大学交叉信息学院

09:50-10:30 Emergent Tool Use From Multi-Agent Autocurricula

- 吴翼 OpenAI

10:30-11:10 通信驱动的合作学习

- 卢宗青 北京大学计算机系

11:10-11:50 StarCraft Commander: Grandmaster level Reinforcement Learning Agent Trained from Hyper Efficient AI Platform

- 高超 启元世界

11:50-12:30 深度强化学习-从仿真到实体

- 赵冬斌 中科院自动化所

12:30-12:40 Closing Speech