类目筛选

2024-11-29

1161

性能提升利器|PolarDB- X 超详细列存查询技术解读

本文将深入探讨 PolarDB-X 列存查询引擎的分层缓存解决方案,以及其在优化 ORC 列存查询性能中的关键作用。

1,161

2024-05-15

102467

大语言模型推理提速,TensorRT-LLM 高性能推理实践

大型语言模型(Large language models,LLM)是基于大量数据进行预训练的超大型深度学习模型,本文主要讲述TensorRT-LLM利用量化、In-Flight Batching、Attention、Graph Rewriting提升 LLM 模型推理效率。

102,467

2024-05-16

57082

容器内存可观测性新视角:WorkingSet 与 PageCache 监控

本文介绍了 Kubernetes 中的容器工作内存(WorkingSet)概念,它用于表示容器内存的实时使用量,尤其是活跃内存。

57,082

2024-05-24

47982

“黏土风格”轻松拿捏,基于函数计算部署 ComfyUI实现AI生图

使用阿里云函数计算FC,快速部署AI绘画工具ComfyUI,体验高质量图像生成。新用户可享180元试用额度,包括GPU、vCPU、内存和调用次数。开通FC和文件存储NAS,通过应用中心选择ComfyUI模板创建应用。

47,982

2025-04-03

1864

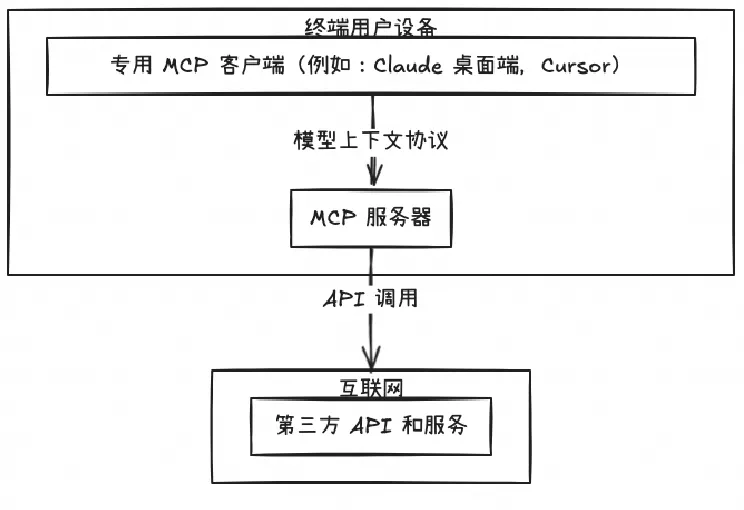

开源 Remote MCP Server 一站式托管来啦!

MCP Server 的实施存在着诸多挑战,特别是在认证授权、服务可靠性和可观测性方面,Higress 作为 AI 原生的 API 网关,提供了完整的开源 MCP Server 托管解决方案,实现存量 API 到 MCP 的协议转换。即将上线的 MCP 市场,将大幅降低开发者构建 MCP Server 的时间和人力成本。

1,864

2025-06-03

1096

实现企业级 MCP 服务统一管理和智能检索的实践

本文将深入剖析 MCP Server 的五种主流架构模式,并结合 Nacos 服务治理框架,为企业级 MCP 部署提供实用指南。

1,096