类目筛选

vLLM部署Yuan2.0:高吞吐、更便捷

vLLM是UC Berkeley开源的大语言模型高速推理框架,其内存管理核心——PagedAttention、内置的加速算法如Continues Batching等,一方面可以提升Yuan2.0模型推理部署时的内存使用效率,另一方面可以大幅提升在实时应用场景下Yuan2.0的吞吐量。

容器内存可观测性新视角:WorkingSet 与 PageCache 监控

本文介绍了 Kubernetes 中的容器工作内存(WorkingSet)概念,它用于表示容器内存的实时使用量,尤其是活跃内存。

Multi-Agent实践第5期:RAG智能体的应用:让AgentScope介绍一下自己吧

本期文章,我们将向大家展示如何使用AgentScope中构建和使用具有RAG功能的智能体,创造AgentScope助手群,为大家解答和AgentScope相关的问题。

开源 Remote MCP Server 一站式托管来啦!

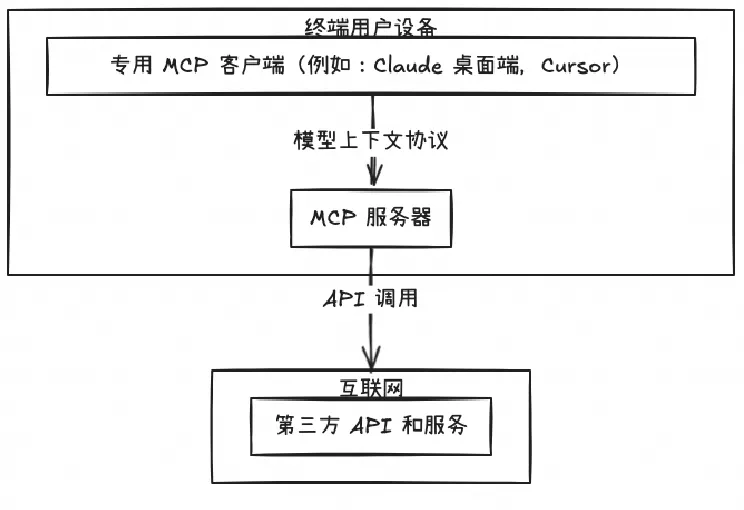

MCP Server 的实施存在着诸多挑战,特别是在认证授权、服务可靠性和可观测性方面,Higress 作为 AI 原生的 API 网关,提供了完整的开源 MCP Server 托管解决方案,实现存量 API 到 MCP 的协议转换。即将上线的 MCP 市场,将大幅降低开发者构建 MCP Server 的时间和人力成本。

实现企业级 MCP 服务统一管理和智能检索的实践

本文将深入剖析 MCP Server 的五种主流架构模式,并结合 Nacos 服务治理框架,为企业级 MCP 部署提供实用指南。

「迁移急救包」全云平台无缝迁移云效实操手册

阿里云云效是国内领先的一站式DevOps平台,提供代码全生命周期管理、智能化交付流水线及精细化研发管控,支持多种开发场景。本文详细介绍了从其他平台(如Coding)向云效迁移的完整方案,包括代码仓库、流水线、制品仓库及项目数据的迁移步骤,帮助用户实现高效、安全的平滑迁移,提升研发效率与协作能力。

All in One:Prometheus 多实例数据统一管理最佳实践

当管理多个Prometheus实例时,阿里云Prometheus托管版相比社区版提供了更可靠的数据采集和便捷的管理。本文比较了全局聚合实例与数据投递方案,两者在不同场景下各有优劣。

阿里云百炼应用实践系列-10分钟构建能主动提问的智能导购

通过使用阿里云百炼平台,您可以快速构建一个多代理(Multi-Agent)架构的智能导购助手。该助手能够通过多轮互动了解顾客的具体需求,收集详细信息后,利用阿里云百炼的知识检索增强功能或已有的商品数据库进行商品搜索,为顾客推荐最合适的产品。