一个典型的推理场景面临的问题可以概括为限流、负载均衡、异步化、数据管理、索引增强 5 个场景。通过云数据库 Tair 丰富的数据结构可以支撑这些场景,解决相关问题,本文我们会针对每个场景逐一说明。

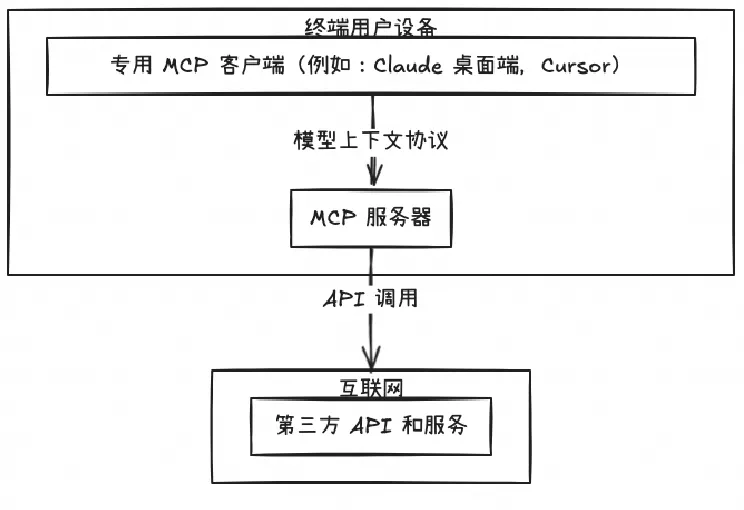

MCP Server 的实施存在着诸多挑战,特别是在认证授权、服务可靠性和可观测性方面,Higress 作为 AI 原生的 API 网关,提供了完整的开源 MCP Server 托管解决方案,实现存量 API 到 MCP 的协议转换。即将上线的 MCP 市场,将大幅降低开发者构建 MCP Server 的时间和人力成本。

Qwen3 Coder 是全球领先的开源编程大模型,具备强大的代码生成能力与1M超长上下文支持,适用于构建复杂应用。本文通过实际案例展示其在电商网站开发中的应用,并详解提示词设计、技术拆解与部署方案,探讨Agentic AI落地的挑战与经验。

探讨了 SLS 中增强数据安全的几种方式:权限精细化管控有效减少了潜在安全风险;接入层脱敏技术阻止敏感数据落库,提升了隐私保护;StoreView 字段集控制通过限制查询数据范围,降低数据泄露损害。智能监控系统提供实时监测,快速识别并阻断异常拖库行为,为企业提供了迅速响应和抵御威胁的能力。

在 2.0 阶段,我们目标是实现面向任务的协同编码模式,人的主要职责转变为任务的下发、干预以及最后结果的审查。在这个过程中,人的实际工作量开始减轻,AI 工作的占比显著提升。目前的 2.0 版本是我们最近上线的。

XTuner和魔搭社区(SWIFT)合作引入了一项长序列文本训练技术,该技术能够在多GPU环境中将长序列文本数据分割并分配给不同GPU,从而减少每个GPU上的显存占用。通过这种方式,训练超大规模模型时可以处理更长的序列,提高训练效率。魔搭社区的SWIFT框架已经集成了这一技术,支持多种大模型和数据集的训练。此外,SWIFT还提供了一个用户友好的界面,方便用户进行训练和部署,并且支持评估功能。

本次分享意在帮助用户更加全面、深入地了解百炼的核心产品能力,并通过实际操作学会如何快速将大模型与自己的系统及应用相结合。主要包括以下三个方面: 1. 阿里云百炼产品定位和能力简介 2. 知识检索 RAG 智能体应用能力和优势 3. 最佳落地案例实践分享